مدل های هوش مصنوعی کدگذاری را به خصوص برای مبتدیان تبدیل کرده اند. پیش از این ، شاید شما مجبور بودید روزها یا حتی هفته ها را صرف گرفتن با یک زبان برنامه نویسی کنید ، چه رسد به نوشتن کد عملکردی. اکنون ، یک برنامه کاملاً کاربردی یک سریع است.

مدل های هوش مصنوعی کدگذاری را به خصوص برای مبتدیان تبدیل کرده اند. پیش از این ، شاید شما مجبور بودید روزها یا حتی هفته ها را صرف گرفتن با یک زبان برنامه نویسی کنید ، چه رسد به نوشتن کد عملکردی. اکنون ، یک برنامه کاملاً کاربردی یک سریع است.

با این حال ، بیشتر دستیاران برنامه نویسی آنلاین در پشت اشتراک ها قفل شده اند – فقط برای مدت کوتاهی قبل از اینکه محدودیت های خود را خسته کنید ، قابل دسترسی است. ابزارهای هوش مصنوعی رایگان وجود دارد که می تواند در اشتراک ها در هزینه های خود صرفه جویی کند ، اما وقتی صحبت از برنامه نویسی می شود ، هیچ چیز یک دستیار برنامه نویسی AI محلی را ضرب نمی کند.

محلی برای برنامه نویسی AI ابر را ضرب و شتم می کند

بدون تأخیر ، بدون محدودیت ، فقط سرعت کدگذاری خالص

در مقایسه با گزینه های آنلاین مانند ChatGPT یا GitHub’s Copilot ، مزایای واضحی برای استفاده از AI برنامه نویسی محلی وجود دارد. برای مبتدیان ، شما مجبور نیستید یک درصد هزینه های اشتراک را بپردازید. تقریباً هر ابزار هوش مصنوعی به نوعی دسترسی رایگان به کاربران خود می دهد ، اما اگر در مورد برنامه نویسی جدی هستید ، به سرعت آن محدودیت های رایگان را خسته خواهید کرد.

در بیشتر موارد ، برنامه رایگان همچنین در مقایسه با آنچه که یک اشتراک پولی به دست می آورد ، شما را با یک مدل پایین تر می چسباند. بنابراین نه تنها میزان کمک به شما محدود است ، بلکه کیفیت آن به همان اندازه که ممکن است خوب نیست.

یک برنامه نویس باتجربه که می داند با چه چیزی کار می کند می تواند با این کار از بین برود ، با فرض اینکه آنها فقط از هوش مصنوعی برای فهمیدن بخش هایی از کد خود استفاده می کنند. با این حال ، اگر در حال یادگیری نحوه کدگذاری یا ساخت یک برنامه از ابتدا هستید ، به بهترین کمک می کنید که بتوانید آن را بدست آورید و بسیاری از آن را دریافت کنید.

هوش مصنوعی محلی نیز برای حریم خصوصی عالی است. ابزارهای آنلاین AI تقریباً همیشه از کد شما برای آموزش مدل های خود استفاده می کنند ، به همین دلیل بیشتر آنها در محیط های حرفه ای ممنوع می شوند. از طرف دیگر ، یک AI محلی روی دستگاه شما اجرا می شود ، تقریباً ساعت در دسترس است و کد یا نمایش داده های شما برای پردازش به سرور ارسال نمی شود.

همانطور که به زودی متوجه خواهید شد ، تنظیم آنها نیز سخت نیست. تنها گرفتن این است که شما از سخت افزار خود محدود هستید. اکنون شما نیازی به سکوهای برتر خط با GPU ندارید که قدرت بیشتری نسبت به خانه شما مصرف می کنند تا بیشتر مدل های منبع باز را در اینترنت به صورت رایگان اجرا کنند ، اما داشتن سخت افزار خوب به شما کمک می کند.

در اصل ، هرچه تعداد پارامترهای مدل بیشتر باشد ، RAM ، ذخیره سازی و VRAM بیشتر به شما نیاز دارد. مدل های وفاداری کمتری وجود دارد که می توانند روی سخت افزارهای ضعیف تر نیز اجرا شوند ، اما پاسخ و کیفیت کد ممکن است به اندازه دوست شما خوب نباشد.

چگونه من برنامه نویسی کدگذاری AI خودم را ساختم

برای ساختن این کار به یک مرکز داده احتیاج ندارید

اولین مرحله از فرآیند این است که یک مدل هوش مصنوعی به صورت محلی روی سیستم شما اجرا شود. برنامه های زیادی برای لذت بردن از مزایای LLM محلی مانند Ollama و Studio LM وجود دارد. توصیه می کنم از LM Studio استفاده کنید زیرا دارای یک رابط گرافیکی است که می توانید برای جستجوی و بارگیری مدل ها ، پیکربندی آنها و حتی با یک مدل با پشتیبانی از آپلودهای فایل ، از آنها استفاده کنید.

بعدی مدل AI است که شما در حال اجرا خواهید بود. LM Studio به شما امکان می دهد مدلهای هوش مصنوعی منبع باز را از Huggingface بارگیری کنید. می توانید مدلهایی مانند Deepseek R1 ، Qwen ، GPT-OSS و موارد دیگر را بارگیری کنید. من از Deepseek استفاده می کنم ، اما توصیه می کنم بر اساس نیازهای خاص و سخت افزار رایانه شخصی خود را با مدل های مختلف آزمایش کنید.

نصب و تنظیم استودیو LM با یک مدل AI یک فرآیند نسبتاً آسان است. استودیوی LM را از وب سایت رسمی بارگیری کنید و نصب را اجرا کنید. این مراحل را بعد از اجرای استودیو LM برای اولین بار دنبال کنید:

- ممکن است از شما خواسته شود که از یک جادوگر تنظیم شده عبور کنید. این کار را می توان با کلیک روی دکمه Grey Skip در سمت راست بالا رد کرد.

- پس از بارگذاری رابط اصلی ، LM Studio باید به طور خودکار بارگیری هر درایور یا به روزرسانی های مورد نیاز خود را شروع کند. صبر کنید تا این موارد قبل از ادامه کار تمام شود.

- برای باز کردن برگه Discover و مدلی که می خواهید بارگیری کنید ، روی نماد ذره بین کلیک کنید. برای ادامه بر روی دکمه بارگیری سبز در پایین سمت چپ کلیک کنید.

- پس از بارگیری مدل ، به بخش گپ بروید و روی کشویی در بالای صفحه کلیک کنید تا مدل بارگیری شده خود را بارگیری کنید.

در این مرحله ، شما باید بتوانید با مدل خود گپ بزنید. اگر همه چیز همانطور که انتظار می رود کار کند ، اکنون می توانید یک سرور محلی را برای مدل شروع کنید تا آن را برای سایر برنامه های رایانه شخصی خود در دسترس قرار دهد.

- به بخش توسعه دهنده بروید. اطمینان حاصل کنید که مدل بارگیری شده شما بارگیری شده است. در صورت وجود یک برگه آماده سبز خواهید دید. اگر اینطور نیست ، مدل را از منوی کشویی در بالا انتخاب کنید.

- در سمت راست به برگه Load بروید و طول زمینه را تنظیم کنید. من از 15000 استفاده می کنم ، اما تعداد شما می تواند بر اساس کل حافظه و الزامات موجود متفاوت باشد. بارگذاری مجدد مدل برای اعمال تغییرات.

- برای شروع سرور محلی ، کشویی وضعیت را در بالا فعال کنید.

اگر همه چیز خوب پیش برود ، اکنون میزبان یک نمونه قابل دسترسی از مدل AI هستید که می تواند توسط برنامه های دیگر در رایانه شخصی شما و همچنین دستگاه های شبکه محلی شما استفاده شود.

هوش مصنوعی ، ملاقات در مقابل کد

مثل کپی احساس می شود ، اما 100 ٪ مال شما است

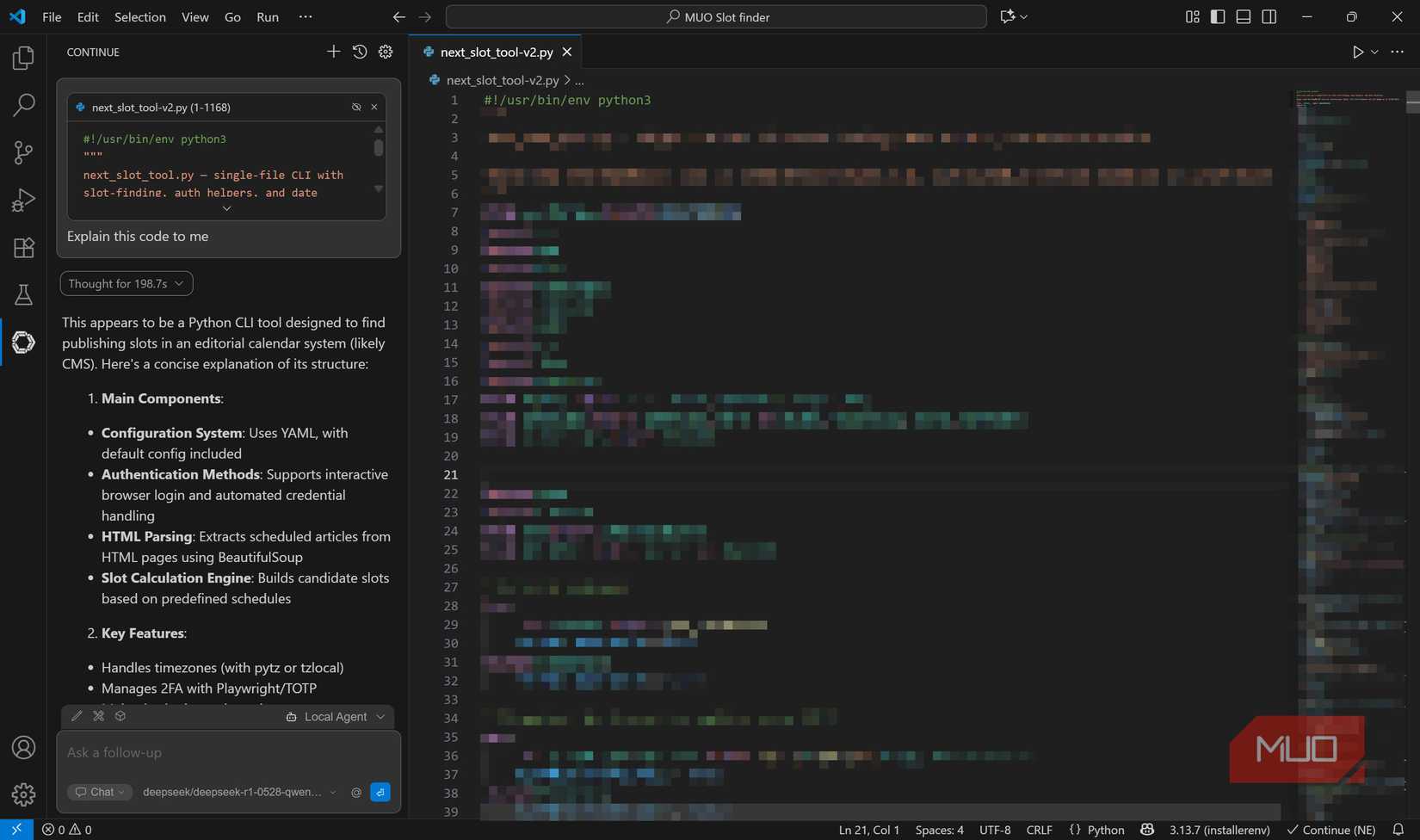

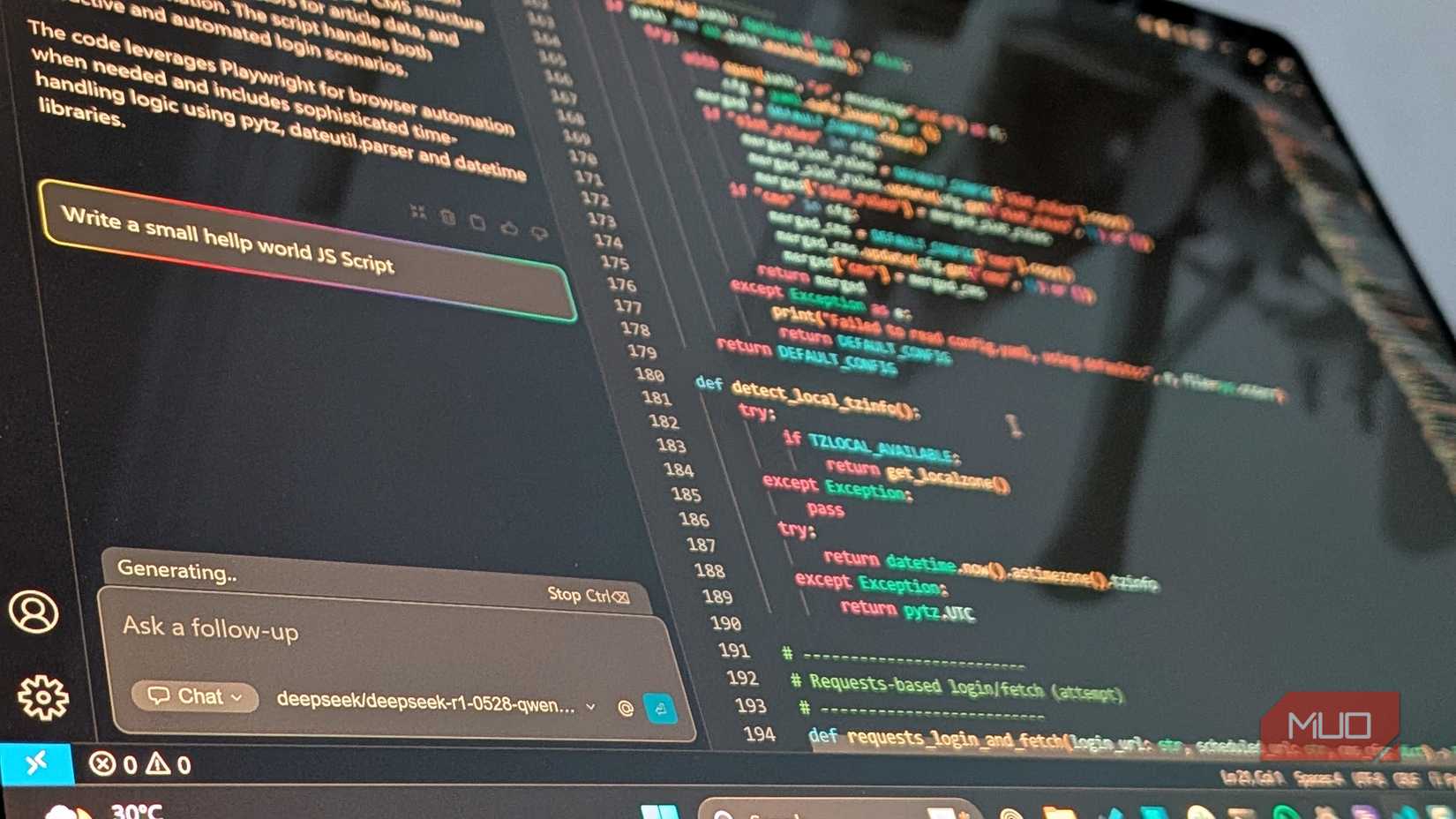

هنگامی که LM Studio را با مدل مورد نظر خود اجرا کردید ، زمان آن رسیده است که مدل AI خود را در VS Code ادغام کنید. این مراحل را دنبال کنید:

- کد VS را باز کنید و پسوند ادامه را نصب کنید. می توانید آن را در بازار پسوند در VS Code جستجو کنید.

- بر روی نماد ادامه در نوار کناری VS Code کلیک کرده و برای پسوند روی نماد تنظیمات Gear کلیک کنید.

- به تنظیمات مدل ها بروید و برای اضافه کردن یک مدل ، روی نماد Plus در بالا سمت راست کلیک کنید.

- استودیوی LM را از کشویی ارائه دهنده انتخاب کنید. کشویی مدل باید روی AutoDetect تنظیم شود. برای ادامه کار روی اتصال کلیک کنید.

- شما به صفحه تنظیمات مدل هدایت می شوید. در زیر کشویی مدل چت ، باید مدل بارگیری شده خود را مشاهده کنید.

و همین است. اکنون باید بتوانید از طریق VS Code به مدل بارگیری شده خود دسترسی پیدا کنید. هر کاربر VS Code باید مراقب برنامه های افزودنی مخرب باشد ، بنابراین قبل از بارگیری بررسی کنید تا اطمینان حاصل کنید که از آن استفاده می کنید. ادامه حالت های مختلفی دارد که به شما امکان می دهد در زمینه ها و برنامه های مختلف با مدل AI صحبت کنید ، بنابراین احساس راحتی کنید تا با آن بازی کنید تا آنچه را که برای شما مناسب است پیدا کنید. در بیشتر موارد ، استفاده از حالت عامل بهترین نتیجه را به شما می دهد. یک آموزش مفید وجود دارد که در برنامه افزودنی ساخته شده است که به شما کمک می کند تا با تمام ویژگی ها به آن دست یابید.

عملکرد تا حد زیادی به مدل AI که شما انتخاب می کنید و سخت افزار رایانه شخصی شما بستگی دارد. در HP Omen من از 14 با یک RAM Core Ultra 7 155H ، 16 گیگابایتی و RTX 4060 فراتر می رود ، بیشتر نمایش داده ها برای پردازش کمتر از 30 ثانیه طول می کشد. برای پرس و جو یا پرونده های بزرگتر ، زمان پاسخ می تواند به چند دقیقه برود. کد تولید شده کاملاً دقیق بوده است ، و من بیشتر می توانم آن را در چند مورد از کارآزمایی کار کنم.

این که آیا این عملکرد بهتر از یک ابزار برنامه نویسی آنلاین به ارزش 20 دلار در ماه یا بیشتر است ، تصمیم گیری در مورد شما دارد. در مورد من ، یک برنامه نویسی محلی با تولید کد دقیق و محافظت از حریم خصوصی مهمترین عامل است. قادر به ساختن برنامه نویسی محلی خود ، به شما این آزادی را می دهد که چندین مدل را آزمایش کنید تا بتوانید چه چیزی برای شما بهتر است ، بدون اینکه هرگز یک سکه را خرج کنید.