چه داده های بد باشد و چه کاربران بد، هوش مصنوعی ایجاد شده با یادگیری ماشینی ممکن است به اشتباهات جدی منجر شود.

یادگیری ماشینی روشی عالی برای ایجاد هوش مصنوعی قدرتمند و سازگار با داده های آموزشی آن است. اما گاهی اوقات، این داده ها می توانند مشکلاتی ایجاد کنند. در موارد دیگر، نحوه استفاده مردم از این ابزارهای هوش مصنوعی مشکل ساز است.

در اینجا نگاهی به برخی از حوادث پرمخاطب که در آن یادگیری ماشینی منجر به نتایج مشکلساز شده است، میبینیم.

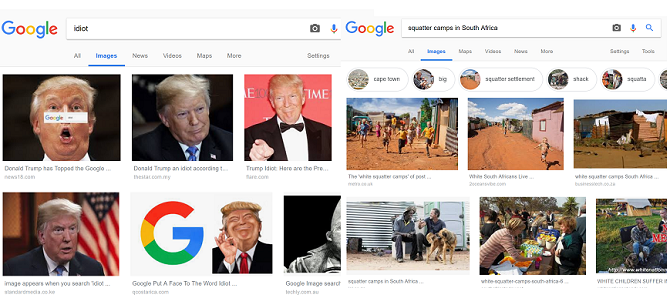

1. نتایج نادرست جستجوی تصویر گوگل

جستجوی گوگل پیمایش در وب را بسیار آسان کرده است. الگوریتم موتور هنگام به دست آوردن نتایج، موارد مختلفی را در نظر می گیرد. اما الگوریتم همچنین از ترافیک کاربر یاد می گیرد که می تواند کیفیت نتایج جستجو را با مشکل مواجه کند.

این در هیچ کجا بیشتر از نتایج تصویر آشکار نیست. از آنجایی که صفحاتی که ترافیک بالایی دریافت میکنند، احتمالاً تصاویرشان نمایش داده میشود، داستانهایی که تعداد زیادی از کاربران را به خود جذب میکنند، از جمله طعمه کلیک، میتوانند در اولویت قرار گیرند.

به عنوان مثال، نتایج جستجوی تصویر برای «اردوگاههای اسکوتر در آفریقای جنوبی» زمانی که مشخص شد که عمدتاً سفیدپوستهای آفریقای جنوبی را نشان میدهد، بحثبرانگیز شد. این در حالی است که آمارها نشان می دهد که اکثریت قریب به اتفاق کسانی که در خانه های غیررسمی زندگی می کنند سیاه پوستان آفریقای جنوبی هستند.

فاکتورهای استفاده شده در الگوریتم گوگل به این معنی است که کاربران اینترنت می توانند نتایج را دستکاری کنند. به عنوان مثال، کمپینی توسط کاربران بر نتایج جستجوی تصویر گوگل تأثیر گذاشت تا جایی که جستجوی عبارت «احمق» تصاویری از دونالد ترامپ، رئیس جمهور سابق آمریکا را برای مدتی نشان داد.

2. مایکروسافت بات تای به نازی تبدیل شد

چت ربات های مجهز به هوش مصنوعی بسیار محبوب هستند، به خصوص آنهایی که با مدل های زبان بزرگ مانند ChatGPT پشتیبانی می شوند. ChatGPT مشکلات متعددی دارد، اما سازندگان آن از اشتباهات شرکت های دیگر نیز درس گرفته اند.

یکی از مهمترین اتفاقات مربوط به چتباتها، تلاش مایکروسافت برای راهاندازی ربات چت Tay بود.

تای الگوهای زبانی یک دختر نوجوان را تقلید کرد و از طریق تعامل خود با سایر کاربران توییتر یاد گرفت. با این حال، زمانی که شروع به اشتراک گذاری اظهارات نازی ها و توهین های نژادی کرد، او به یکی از بدنام ترین اشتباهات هوش مصنوعی تبدیل شد. به نظر می رسد که ترول ها از یادگیری ماشینی هوش مصنوعی علیه آن استفاده کرده اند و آن را با تعاملات مملو از تعصب پر کرده اند.

چندی بعد، مایکروسافت Tay را برای همیشه آفلاین کرد.

3. مشکلات تشخیص چهره هوش مصنوعی

هوش مصنوعی تشخیص چهره اغلب به دلایل اشتباه، مانند داستانهایی در مورد تشخیص چهره و نگرانیهای مربوط به حفظ حریم خصوصی، تیتر خبرها میشود. اما این هوش مصنوعی در هنگام تلاش برای تشخیص افراد رنگین پوست سابقه مشکل دارد.

در سال 2015، کاربران متوجه شدند که Google Photos برخی از سیاه پوستان را به عنوان گوریل دسته بندی می کند. در سال 2018، تحقیقات ACLU نشان داد که نرمافزار شناسایی چهره Rekognition آمازون، 28 عضو کنگره ایالات متحده را به عنوان مظنونان پلیس شناسایی کرده است، با نتایج مثبت کاذب که به طور نامتناسبی بر افراد رنگین پوست تأثیر میگذارد.

یک اتفاق دیگر مربوط به این بود که نرم افزار Face ID اپل به اشتباه دو زن مختلف چینی را به عنوان یک شخص شناسایی کرد. در نتیجه، همکار صاحب آیفون X می تواند قفل گوشی را باز کند.

در نمونه ای از پیامدهای شدید، هوش مصنوعی تشخیص چهره منجر به دستگیری اشتباه چندین نفر شده است. Wired در مورد سه مورد از این قبیل گزارش داد.

در همین حال، جوی بولاموینی، دانشمند کامپیوتر، به یاد می آورد که اغلب نیاز به پوشیدن ماسک سفید در حین کار بر روی فناوری تشخیص چهره داشت تا بتواند او را تشخیص دهد. برای حل مسائلی مانند این، Buolamwini و سایر متخصصان فناوری اطلاعات به موضوع سوگیری هوش مصنوعی و نیاز به مجموعه دادههای فراگیرتر توجه میکنند.

4. دیپ فیک مورد استفاده برای حقه

در حالی که مردم مدتهاست از فتوشاپ برای ایجاد تصاویر جعلی استفاده میکنند، یادگیری ماشینی این را به سطح جدیدی میبرد. Deepfakes از هوش مصنوعی یادگیری عمیق برای ایجاد تصاویر و ویدیوهای جعلی استفاده می کند. نرمافزاری مانند FaceApp به شما امکان میدهد سوژهها را از یک ویدیو به ویدیوی دیگر تغییر دهید.

اما بسیاری از افراد از این نرم افزار برای مصارف مخرب مختلف، از جمله قرار دادن چهره افراد مشهور در ویدیوهای بزرگسالان یا تولید ویدیوهای دروغین، سوء استفاده می کنند. در همین حال، کاربران اینترنت به بهبود این فناوری کمک کرده اند تا تشخیص ویدیوهای واقعی از جعلی به طور فزاینده ای دشوار شود. در نتیجه، این نوع هوش مصنوعی را از نظر انتشار اخبار جعلی و حقهبازی بسیار قدرتمند میکند.

برای نشان دادن قدرت این فناوری، کارگردان جردن پیل و مدیر عامل BuzzFeed، جونا پرتی، ویدئویی ساختند که به نظر می رسد رئیس جمهور سابق ایالات متحده، باراک اوباما، یک PSA در مورد قدرت دیپ فیک ارائه می دهد.

قدرت تصاویر جعلی توسط مولدهای تصویری که توسط هوش مصنوعی طراحی شده اند، تسریع شده است. پست های ویروسی در سال 2023 که دونالد ترامپ را در حال دستگیری و پاپ کاتولیک با ژاکت پف دار به تصویر می کشد، نتیجه هوش مصنوعی مولد است.

نکاتی وجود دارد که می توانید برای مشاهده تصویری که توسط هوش مصنوعی ایجاد شده است دنبال کنید، اما این فناوری روز به روز پیچیده تر می شود.

5. کارمندان می گویند هوش مصنوعی آمازون تصمیم گرفت مردان را استخدام کند

در اکتبر 2018، رویترز گزارش داد که آمازون مجبور شد ابزار استخدام شغلی را پس از اینکه هوش مصنوعی نرم افزار تصمیم گرفت که نامزدهای مرد ترجیحی هستند را کنار بگذارد.

کارمندانی که می خواستند نامشان فاش نشود، به رویترز آمدند تا در مورد کار خود در این پروژه صحبت کنند. توسعه دهندگان از هوش مصنوعی می خواستند تا بر اساس رزومه آنها بهترین نامزدها را برای یک شغل شناسایی کند. با این حال، افراد درگیر در این پروژه به زودی متوجه شدند که هوش مصنوعی نامزدهای زن را جریمه می کند. آنها توضیح دادند که هوش مصنوعی از رزومه های دهه گذشته، که بیشتر آنها از مردان بودند، به عنوان مجموعه داده آموزشی خود استفاده می کرد.

در نتیجه، هوش مصنوعی شروع به فیلتر کردن CV ها بر اساس کلمه کلیدی “زنان” کرد. کلمه کلیدی در CV تحت فعالیت هایی مانند “کاپیتان باشگاه شطرنج زنان” ظاهر شد. در حالی که توسعه دهندگان هوش مصنوعی را تغییر دادند تا از این جریمه شدن رزومه های زنان جلوگیری کنند، آمازون در نهایت این پروژه را کنار گذاشت.

6. چت بات های جیلبریک

در حالی که چتباتهای جدیدتر محدودیتهایی دارند تا از دادن پاسخهایی بر خلاف شرایط خدماتشان جلوگیری کنند، کاربران در حال یافتن راههایی برای جیلبریک کردن ابزارهای ارائه محتوای ممنوعه هستند.

در سال 2023، یک محقق امنیتی Forcepoint، آرون مولگرو، توانست بدافزار روز صفر را با استفاده از دستورات ChatGPT ایجاد کند.

Mulgrew در یک پست Forcepoint گفت: “به سادگی با استفاده از دستورات ChatGPT، و بدون نوشتن هیچ کدی، ما توانستیم یک حمله بسیار پیشرفته را تنها در چند ساعت ایجاد کنیم.”

طبق گزارشها، کاربران همچنین توانستهاند چتباتهایی را دریافت کنند تا دستورالعملهایی را در مورد نحوه ساخت بمب یا سرقت ماشین به آنها ارائه دهند.

7. تصادفات اتومبیل خودران

اشتیاق به وسایل نقلیه خودران از مرحله تبلیغات اولیه خود به دلیل اشتباهات انجام شده توسط هوش مصنوعی خودران کاهش یافته است. در سال 2022، واشنگتن پست گزارش داد که در حدود یک سال، 392 تصادف شامل سیستم های پیشرفته کمک راننده به اداره ملی ایمنی ترافیک بزرگراه ایالات متحده گزارش شده است.

این تصادفات شامل جراحات جدی و شش کشته بود.

در حالی که این امر شرکتهایی مانند تسلا را از دستیابی به وسایل نقلیه کاملاً خودمختار منع نکرده است، اما نگرانیهایی را در مورد افزایش تصادفات ایجاد کرده است زیرا خودروهای بیشتری با نرمافزار خودران به جادهها میروند.

هوش مصنوعی یادگیری ماشینی اشتباه نیست

در حالی که یادگیری ماشینی می تواند ابزارهای هوش مصنوعی قدرتمندی ایجاد کند، اما آنها از داده های بد یا دستکاری انسان مصون نیستند. چه به دلیل داده های آموزشی ناقص، محدودیت های فناوری هوش مصنوعی یا استفاده توسط بازیگران بد، این نوع هوش مصنوعی منجر به حوادث منفی بسیاری شده است.