آینده برای هوش مصنوعی روشن است.

هوش مصنوعی (AI) از پایان سال 2022 پیشرفت های چشمگیری داشته است. برنامه های کاربردی نرم افزاری مبتنی بر هوش مصنوعی به طور فزاینده ای با ارائه راه حل های ابداعی، بخش های مختلف را متحول می کنند. از چت رباتهای خدمات مشتری یکپارچه گرفته تا مولدهای بصری خیرهکننده، هوش مصنوعی تجربیات روزانه ما را بهبود میبخشد. با این حال، در پشت صحنه، سخت افزار هوش مصنوعی در تامین سوخت این سیستم های هوشمند نقش اساسی دارد.

سخت افزار هوش مصنوعی چیست؟

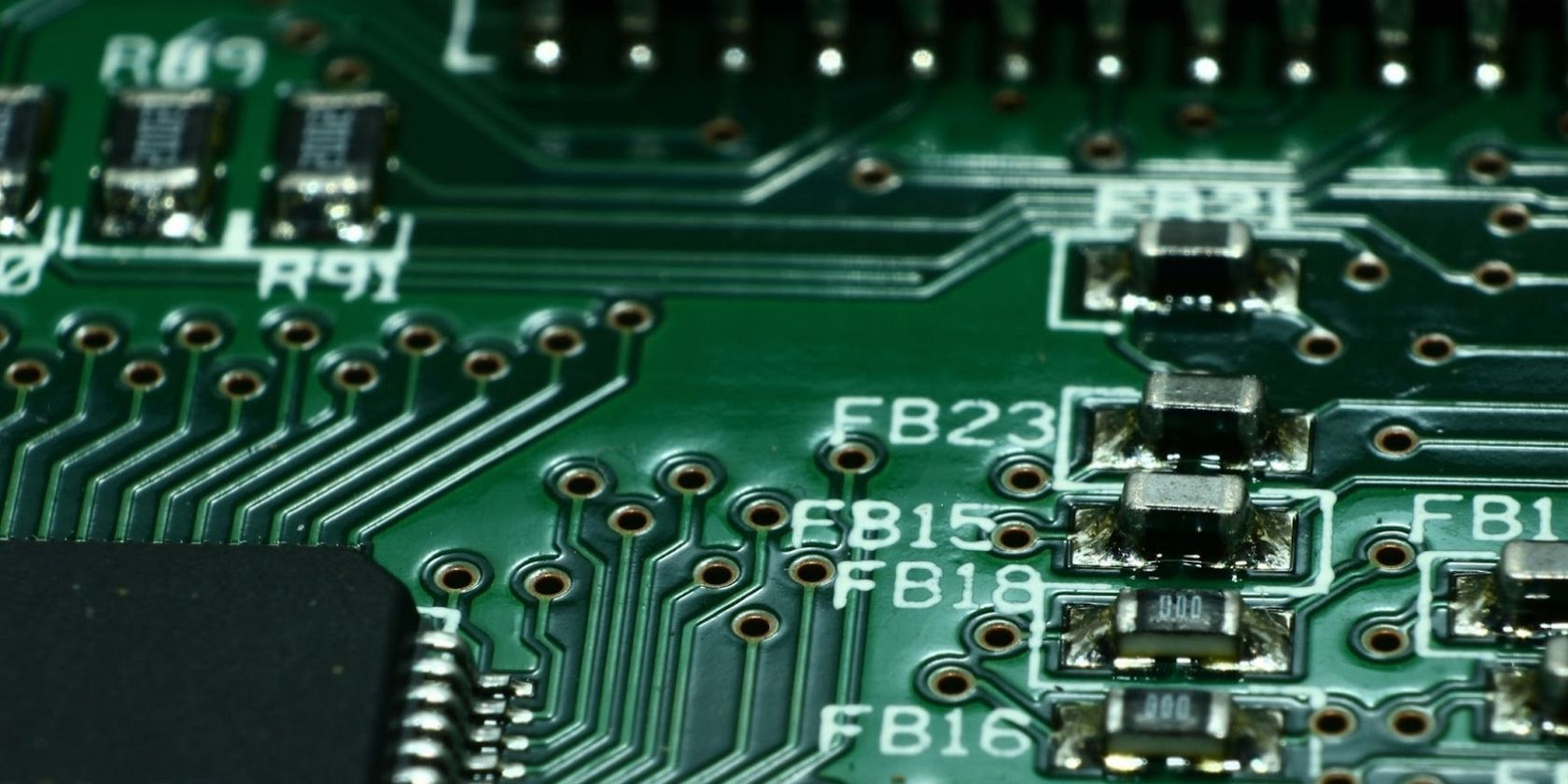

سخت افزار هوش مصنوعی به سخت افزار کامپیوتری تخصصی اشاره دارد که برای انجام وظایف مرتبط با هوش مصنوعی به طور موثر طراحی شده است. این شامل تراشههای خاص و مدارهای مجتمع میشود که پردازش سریعتر و قابلیتهای صرفهجویی در انرژی را ارائه میکنند. علاوه بر این، آنها زیرساخت های لازم را برای اجرای موثر الگوریتم ها و مدل های هوش مصنوعی فراهم می کنند.

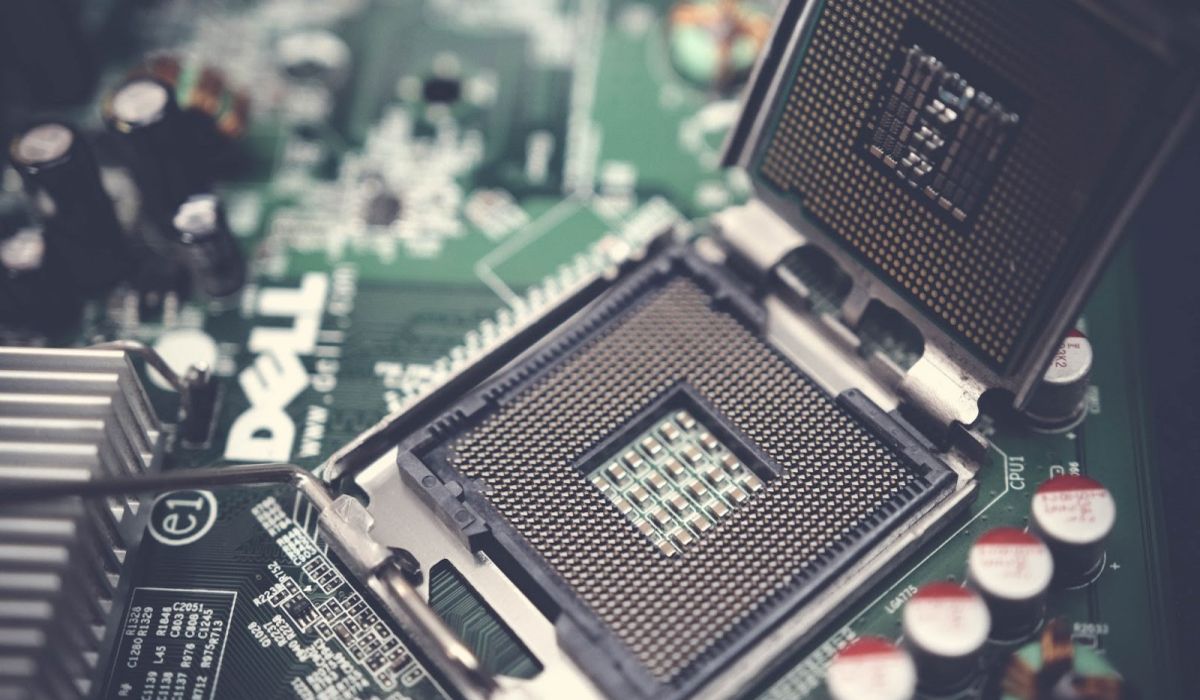

نقش سختافزار هوش مصنوعی در یادگیری ماشین بسیار مهم است زیرا به اجرای برنامههای پیچیده برای مدلهای یادگیری عمیق کمک میکند. علاوه بر این، در مقایسه با سختافزار رایانهای معمولی مانند واحدهای پردازش مرکزی (CPU)، سختافزار هوش مصنوعی میتواند فرآیندهای متعددی را تسریع کند و زمان و هزینه مورد نیاز برای آموزش و اجرای الگوریتم را به میزان قابل توجهی کاهش دهد.

علاوه بر این، با محبوبیت روزافزون مدلهای هوش مصنوعی و یادگیری ماشین، تقاضا برای راهحلهای شتاب افزایش یافته است. در نتیجه، شرکت هایی مانند Nvidia، تولید کننده پیشرو GPU در جهان، شاهد رشد قابل توجهی بوده اند. در ژوئن 2023، واشنگتن پست گزارش داد که ارزش بازار انویدیا از 1 تریلیون دلار فراتر رفت و از ارزش تسلا و متا پیشی گرفت. موفقیت انویدیا اهمیت سخت افزار هوش مصنوعی را در چشم انداز فناوری امروز برجسته می کند.

1. تراشه های محاسباتی لبه

اگر با چیستی محاسبات لبه آشنایی دارید، احتمالاً درک درستی از تراشههای محاسبات لبه دارید. این پردازنده های تخصصی به طور خاص برای اجرای مدل های هوش مصنوعی در لبه شبکه طراحی شده اند. با استفاده از تراشههای محاسباتی لبه، کاربران میتوانند دادهها را پردازش کرده و عملیات تحلیلی حیاتی را مستقیماً در منبع داده انجام دهند و نیازی به انتقال داده به سیستمهای متمرکز را از بین ببرند.

کاربردهای تراشههای محاسباتی لبهای متنوع و گسترده هستند. آنها در خودروهای خودران، سیستمهای تشخیص چهره، دوربینهای هوشمند، پهپادها، دستگاههای پزشکی قابل حمل و دیگر سناریوهای تصمیمگیری در زمان واقعی کاربرد دارند.

مزایای تراشه های محاسباتی لبه قابل توجه است. اولا، آنها با پردازش داده ها در نزدیکی منبع آن، تأخیر را تا حد زیادی کاهش می دهند و عملکرد کلی اکوسیستم های هوش مصنوعی را افزایش می دهند. علاوه بر این، محاسبات لبه با به حداقل رساندن مقدار داده هایی که باید به ابر منتقل شود، امنیت را افزایش می دهد.

در اینجا برخی از تولید کنندگان پیشرو سخت افزار هوش مصنوعی در زمینه تراشه های محاسباتی لبه آورده شده است:

- جتسون خاویر NX

- AMD EPYC™ Embedded 3000 Series

- جتسون نانو

- ARM Cortex-M55

- ARM Ethos-U55

2. سخت افزار کوانتومی

برخی ممکن است تعجب کنند، “محاسبات کوانتومی چیست و آیا حتی واقعی است؟” محاسبات کوانتومی در واقع یک سیستم محاسباتی واقعی و پیشرفته است که بر اساس اصول مکانیک کوانتومی عمل می کند. در حالی که کامپیوترهای کلاسیک از بیت ها استفاده می کنند، محاسبات کوانتومی از بیت های کوانتومی (کیوبیت) برای انجام محاسبات استفاده می کند. این کیوبیتها سیستمهای محاسباتی کوانتومی را قادر میسازند تا مجموعه دادههای بزرگ را با کارآمدتر پردازش کنند و آنها را برای مدلهای هوش مصنوعی، یادگیری ماشین و یادگیری عمیق بسیار مناسب میسازد.

کاربردهای سخت افزار کوانتومی این پتانسیل را دارند که الگوریتم های هوش مصنوعی را متحول کنند. به عنوان مثال، در کشف دارو، سخت افزار کوانتومی می تواند رفتار مولکول ها را شبیه سازی کند و به محققان در شناسایی دقیق داروهای جدید کمک کند. به طور مشابه، در علم مواد، می تواند به پیش بینی تغییرات آب و هوا کمک کند. بخش مالی می تواند با توسعه ابزارهای پیش بینی قیمت از سخت افزار کوانتومی بهره مند شود.

در زیر مزایای قابل توجه محاسبات کوانتومی برای هوش مصنوعی آورده شده است:

- سرعت: رایانههای کوانتومی بسیار سریعتر از رایانههای سنتی هستند و میتوانند مسائل پیچیدهای را که میلیاردها سال طول میکشد را در چند ثانیه حل کنند.

- دقت: محاسبات کوانتومی به مدلهای هوش مصنوعی اجازه میدهد تا با مقادیر زیادی داده در زمان کوتاهتری آموزش داده شوند که منجر به دقت بالاتر در پیشبینیها و تجزیه و تحلیل میشود.

- نوآوری: سختافزار محاسبات کوانتومی فرصتهایی را برای پیشرفتها و پیشرفتهای جدید در بازار باز میکند و قدرت محاسباتی را که قبلاً دست نیافتنی بود، باز میکند.

3. مدارهای مجتمع خاص برنامه (ASIC)

مدارهای مجتمع ویژه برنامه (ASIC) برای کارهای هدفمندی مانند پردازش تصویر و تشخیص گفتار طراحی شده اند (اگرچه ممکن است در مورد ASIC ها از طریق استخراج ارز دیجیتال شنیده باشید). هدف آنها تسریع رویههای هوش مصنوعی برای برآوردن نیازهای خاص کسبوکار شما، ارائه زیرساخت کارآمدی است که سرعت کلی را در اکوسیستم افزایش میدهد.

ASICها در مقایسه با واحدهای پردازش مرکزی سنتی (CPU) یا واحدهای پردازش گرافیکی (GPU) مقرون به صرفه هستند. این به دلیل بهره وری انرژی و عملکرد برتر آنها است که از CPU و GPU پیشی گرفته است. در نتیجه، ASIC ها الگوریتم های هوش مصنوعی را در برنامه های مختلف تسهیل می کنند.

این مدارهای یکپارچه می توانند حجم قابل توجهی از داده ها را مدیریت کنند و آنها را در آموزش مدل های هوش مصنوعی مفید می کند. کاربردهای آنها در زمینه های مختلف، از جمله پردازش زبان طبیعی متون و داده های گفتاری گسترش می یابد. علاوه بر این، آنها استقرار مکانیسم های پیچیده یادگیری ماشینی را ساده می کنند.

4. سخت افزار نورومورفیک

سخت افزار نورومورفیک نشان دهنده پیشرفت قابل توجهی در فناوری سخت افزار کامپیوتر است که هدف آن شبیه سازی عملکرد مغز انسان است. این سخت افزار نوآورانه سیستم عصبی انسان را تقلید می کند و زیرساخت شبکه عصبی را اتخاذ می کند که با رویکرد پایین به بالا عمل می کند. این شبکه شامل پردازنده های به هم پیوسته ای است که به آنها نورون ها گفته می شود.

بر خلاف سخت افزار محاسباتی سنتی که داده ها را به صورت متوالی پردازش می کند، سخت افزار نورومورفیک در پردازش موازی برتری دارد. این قابلیت پردازش موازی، شبکه را قادر میسازد تا چندین کار را به طور همزمان انجام دهد و در نتیجه سرعت و کارایی انرژی را بهبود بخشد.

علاوه بر این، سخت افزار نورومورفیک چندین مزیت قانع کننده دیگر را ارائه می دهد. میتوان آن را با مجموعه دادههای گسترده آموزش داد، که آن را برای طیف گستردهای از کاربردها، از جمله تشخیص تصویر، تشخیص گفتار، و پردازش زبان طبیعی مناسب میسازد. علاوه بر این، دقت سخت افزار نورومورفیک قابل توجه است، زیرا به سرعت از مقادیر زیادی داده یاد می گیرد.

در اینجا برخی از قابل توجه ترین برنامه های محاسباتی نورومورفیک آورده شده است:

- وسایل نقلیه خودران می توانند از سخت افزار محاسباتی نورومورفیک برای افزایش توانایی خود در درک و تفسیر محیط اطراف خود استفاده کنند.

- در تشخیص پزشکی، سخت افزار نورومورفیک می تواند به ویژگی های تشخیص تصویر کمک کند و به شناسایی بیماری ها کمک کند.

- دستگاههای مختلف اینترنت اشیا (اینترنت اشیا) میتوانند از سختافزار نورومورفیک برای جمعآوری و تجزیه و تحلیل دادهها استفاده کنند که پردازش و تصمیمگیری کارآمد داده را ممکن میسازد.

5. آرایه دروازه قابل برنامه ریزی میدانی (FPGA)

Field Programmable Gate Array (FPGA) یک مدار مجتمع پیشرفته است که مزایای ارزشمندی را برای پیاده سازی نرم افزار هوش مصنوعی ارائه می دهد. این تراشههای تخصصی را میتوان برای برآوردن نیازهای خاص اکوسیستم هوش مصنوعی سفارشیسازی و برنامهریزی کرد و نام «قابل برنامهریزی در میدان» را برای آنها به ارمغان آورد.

FPGA ها از بلوک های منطقی قابل تنظیم (CLB) تشکیل شده اند که به هم متصل و قابل برنامه ریزی هستند. این انعطاف پذیری ذاتی اجازه می دهد تا طیف گسترده ای از برنامه های کاربردی در زمینه هوش مصنوعی. علاوه بر این، این تراشهها را میتوان برای مدیریت عملیاتهایی با سطوح پیچیدگی مختلف، برنامهریزی کرد که با نیازهای خاص سیستم سازگار شود.

FPGA که مانند یک تراشه حافظه فقط خواندنی کار می کند، اما با ظرفیت گیت بالاتر، مزیت برنامه ریزی مجدد را ارائه می دهد. این بدان معنی است که آنها می توانند چندین بار برنامه ریزی شوند، که امکان تنظیمات و مقیاس پذیری بر اساس نیازهای در حال تحول را فراهم می کند. علاوه بر این، FPGA ها کارآمدتر از سخت افزارهای محاسباتی سنتی هستند و معماری قوی و مقرون به صرفه ای را برای برنامه های هوش مصنوعی ارائه می دهند.

علاوه بر مزیت های سفارشی سازی و عملکرد، FPGA ها اقدامات امنیتی پیشرفته ای را نیز ارائه می دهند. معماری کامل آنها محافظت قوی را تضمین می کند و آنها را برای اجرای ایمن هوش مصنوعی قابل اعتماد می کند.

آینده سخت افزار هوش مصنوعی چیست؟

سخت افزار هوش مصنوعی در آستانه پیشرفت های متحول کننده است. برنامه های کاربردی هوش مصنوعی در حال تکامل، سیستم های تخصصی را برای برآوردن نیازهای محاسباتی می طلبد. نوآوریها در پردازندهها، شتابدهندهها و تراشههای نورومورفیک، کارایی، سرعت، صرفهجویی در انرژی و محاسبات موازی را در اولویت قرار میدهند. ادغام سختافزار هوش مصنوعی در دستگاههای لبه و اینترنت اشیا، پردازش روی دستگاه، کاهش تأخیر و افزایش حریم خصوصی را ممکن میسازد. همگرایی با محاسبات کوانتومی و مهندسی نورومورفیک، پتانسیل قدرت نمایی و یادگیری شبیه انسان را باز می کند.

آینده سختافزار هوش مصنوعی نوید سیستمهای محاسباتی قدرتمند، کارآمد و تخصصی را میدهد که صنعت را متحول کرده و تعاملات ما با فناوریهای هوشمند را تغییر میدهد.