چه از ChatGPT یا ربات چت دیگر استفاده کنید، باید از تهدیدات احتمالی که حریم خصوصی داده های شما را زیر سوال می برد آگاه باشید.

چتباتها سالهاست که وجود دارند، اما ظهور مدلهای زبانی بزرگ، مانند ChatGPT و Google Bard، جان تازهای به صنعت چتباتها بخشیده است.

اکنون میلیونها نفر در سراسر جهان از چترباتهای هوش مصنوعی استفاده میکنند، اما اگر میخواهید یکی از این ابزارها را امتحان کنید، خطرات و نگرانیهای مهم حفظ حریم خصوصی وجود دارد که باید به خاطر داشته باشید.

1. جمع آوری داده ها

اکثر مردم از چت بات ها فقط برای سلام کردن استفاده نمی کنند. چت رباتهای مدرن برای پردازش و پاسخگویی به سؤالات و درخواستهای پیچیده طراحی شدهاند و کاربران اغلب اطلاعات زیادی را در درخواستهای خود گنجاندهاند. حتی اگر فقط یک سوال ساده بپرسید، واقعاً نمی خواهید آن را فراتر از مکالمه شما بکنید.

با توجه به بخش پشتیبانی OpenAI، میتوانید گزارشهای چت ChatGPT را هر زمان که بخواهید حذف کنید و آن لاگها پس از 30 روز برای همیشه از سیستمهای OpenAI حذف میشوند. با این حال، اگر گزارشهای چت خاصی به دلیل محتوای مضر یا نامناسب پرچمگذاری شده باشند، شرکت حفظ و بررسی میکند.

یکی دیگر از چتباتهای محبوب هوش مصنوعی، کلود، مکالمات قبلی شما را نیز پیگیری میکند. مرکز پشتیبانی آنتروپیک بیان میکند که کلود «اعلانها و خروجیهای شما را در محصول ردیابی میکند تا در طول زمان، مطابق با کنترلهای شما، تجربه محصول ثابتی را در اختیار شما قرار دهد». میتوانید مکالمات خود را با کلود حذف کنید، بنابراین آنچه را که در مورد آن صحبت کردهاید فراموش میکند، اما این بدان معنا نیست که Anthropic فوراً گزارشهای شما را از سیستمهای خود حذف میکند.

البته این سوال پیش میآید: آیا دادههای من نگهداری میشوند یا خیر؟ آیا ChatGPT یا سایر ربات های چت از داده های من استفاده می کنند؟

اما نگرانی ها به اینجا ختم نمی شود.

ChatGPT چگونه یاد می گیرد؟

به منظور ارائه اطلاعات، مدل های زبان بزرگ با حجم عظیمی از داده ها آموزش داده می شوند. بر اساس گزارش Science Focus، ChatGPT-4 به تنهایی در طول دوره آموزشی خود 300 میلیارد کلمه اطلاعات را تغذیه کرد. این مستقیماً از چند دایره المعارف گرفته نشده است. در عوض، توسعه دهندگان چت بات از انبوه اطلاعات از اینترنت برای آموزش مدل های خود استفاده می کنند. این می تواند شامل داده های کتاب ها، فیلم ها، مقالات، مدخل های ویکی پدیا، پست های وبلاگ، نظرات و حتی سایت های بررسی باشد.

به خاطر داشته باشید که بسته به خط مشی حفظ حریم خصوصی توسعه دهندگان چت بات، برخی از منابع ذکر شده ممکن است در آموزش استفاده نشوند.

بسیاری از ChatGPT انتقاد کرده اند و ادعا می کنند که از نظر حریم خصوصی چیزی شبیه یک کابوس است که نمی توان به ChatGPT اعتماد کرد. بنابراین، چرا این مورد است؟

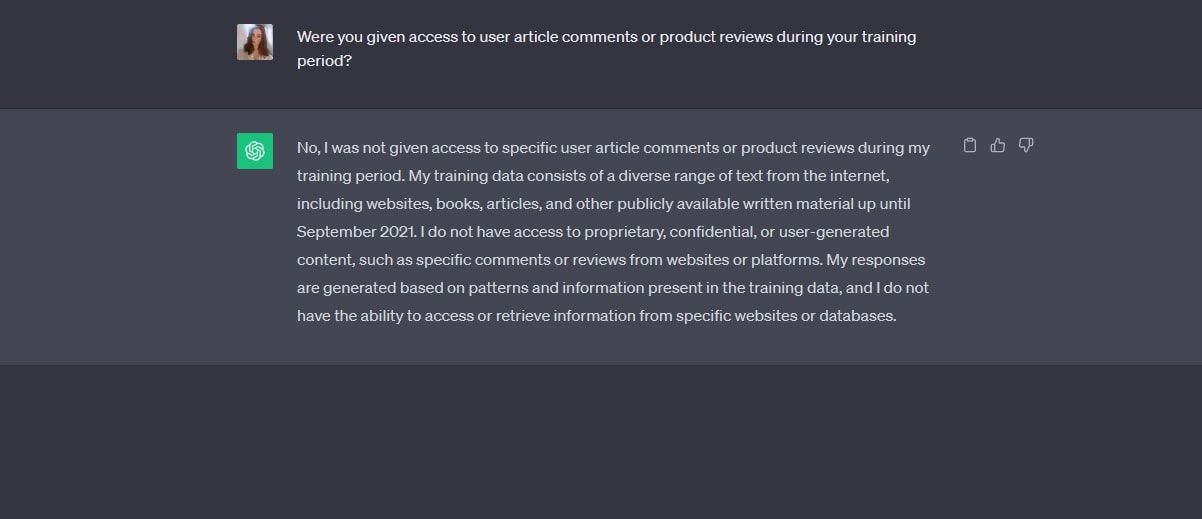

اینجاست که همه چیز کمی تار می شود. اگر مستقیماً از ChatGPT-3.5 بپرسید که آیا به بررسی های محصول یا نظرات مقاله دسترسی دارد، یک منفی قطعی دریافت خواهید کرد. همانطور که در اسکرین شات زیر می بینید، GPT-3.5 بیان می کند که در آموزش خود به نظرات مقاله کاربر یا بررسی محصول دسترسی نداشته است.

بلکه با استفاده از “متن متنوعی از اینترنت، از جمله وبسایتها، کتابها، مقالات و سایر مطالب مکتوب در دسترس عموم تا سپتامبر 2021” آموزش داده شد.

اما آیا در مورد GPT-4 هم همینطور است؟

وقتی از GPT-4 پرسیدیم، به ما گفته شد که «OpenAI از بررسیهای کاربر خاص، دادههای شخصی یا نظرات مقاله» در دوره آموزشی ربات چت استفاده نکرده است. علاوه بر این، GPT-4 به ما گفت که پاسخهایش از «الگوهایی در دادههایی که [آن] آموزش داده شده است، که عمدتاً شامل کتابها، مقالهها و متنهای دیگر از اینترنت است، تولید میشود».

وقتی بیشتر بررسی کردیم، GPT-4 ادعا کرد که محتوای رسانه های اجتماعی خاصی ممکن است در واقع در داده های آموزشی آن گنجانده شود، اما سازندگان همیشه ناشناس خواهند ماند. GPT-4 به طور خاص بیان کرد که «حتی اگر محتوای پلتفرمهایی مانند Reddit بخشی از دادههای آموزشی باشد، [آن] به نظرات، پستها یا هر دادهای که میتواند به یک کاربر جداگانه پیوند داده شود، دسترسی ندارد».

بخش قابل توجه دیگری از پاسخ GPT-4 به شرح زیر است: “OpenAI به صراحت تمام منابع داده استفاده شده را فهرست نکرده است.” البته، فهرست کردن منابعی به ارزش 300 میلیارد کلمه برای OpenAI دشوار خواهد بود، اما این امر فضایی را برای حدس و گمان باقی می گذارد.

در یک مقاله Ars Technica، بیان شد که ChatGPT “اطلاعات شخصی به دست آمده بدون رضایت” را جمع آوری می کند. در همان مقاله، یکپارچگی زمینهای ذکر شد، مفهومی که تنها به استفاده از اطلاعات شخصی در زمینهای که در ابتدا استفاده میشد اشاره دارد. اگر ChatGPT این یکپارچگی متنی را نقض کند، دادههای افراد ممکن است در خطر باشد.

نکته نگران کننده دیگر در اینجا، انطباق OpenAI با مقررات عمومی حفاظت از داده ها (GDPR) است. این مقرراتی است که توسط اتحادیه اروپا به منظور محافظت از داده های شهروندان اجرا می شود. کشورهای مختلف اروپایی، از جمله ایتالیا و لهستان، تحقیقاتی را در مورد ChatGPT به دلیل نگرانی در مورد رعایت GDPR آغاز کرده اند. حتی برای مدت کوتاهی ChatGPT در ایتالیا به دلیل نگرانی از حفظ حریم خصوصی ممنوع شد.

OpenAI در گذشته به دلیل قوانین هوش مصنوعی برنامه ریزی شده تهدید کرده بود که از اتحادیه اروپا خارج می شود، اما از آن زمان پس گرفته شد.

ChatGPT ممکن است بزرگترین چت ربات هوش مصنوعی امروزی باشد، اما مسائل مربوط به حریم خصوصی ربات چت با این ارائه دهنده شروع و ختم نمی شود. اگر از یک ربات چت سایه دار با خط مشی رازداری ضعیف استفاده می کنید، ممکن است از مکالمات شما سوء استفاده شود یا اطلاعات بسیار حساس در داده های آموزشی آن استفاده شود.

2. سرقت اطلاعات

مانند هر ابزار یا پلتفرم آنلاین، چت بات ها در برابر جرایم سایبری آسیب پذیر هستند. حتی اگر یک چت بات تمام تلاش خود را برای محافظت از کاربران و داده های آنها انجام دهد، همیشه این احتمال وجود دارد که یک هکر زرنگ بتواند به سیستم های داخلی آن نفوذ کند.

اگر یک سرویس چت بات داده شده اطلاعات حساس شما را ذخیره می کرد، مانند جزئیات پرداخت برای اشتراک پریمیوم، داده های تماس یا موارد مشابه، در صورت وقوع حمله سایبری، ممکن است به سرقت رفته و مورد سوء استفاده قرار گیرد.

این امر به ویژه اگر از یک ربات چت با امنیت کمتر استفاده می کنید که توسعه دهندگان آن روی حفاظت امنیتی کافی سرمایه گذاری نکرده اند، صادق است. نه تنها سیستمهای داخلی شرکت هک میشوند، بلکه اگر اکانت شما دارای هشدارهای ورود یا لایه احراز هویت نباشد، این احتمال وجود دارد که در معرض خطر قرار گیرد.

اکنون که چت رباتهای هوش مصنوعی بسیار محبوب شدهاند، مجرمان سایبری طبیعتاً به استفاده از این صنعت برای کلاهبرداریهای خود روی آوردهاند. وب سایت ها و پلاگین های جعلی ChatGPT از زمانی که چت ربات OpenAI در اواخر سال 2022 وارد جریان اصلی شد، با افرادی که به کلاهبرداری می افتند و اطلاعات شخصی را به بهانه مشروعیت و اعتماد ارائه می دهند، یک مشکل بزرگ بوده اند.

در مارس 2023، MUO در مورد یک افزونه جعلی ChatGPT Chrome گزارش داد که لاگین فیس بوک را سرقت می کند. این افزونه می تواند از یک درب پشتی فیس بوک برای هک کردن حساب های کاربری با مشخصات بالا و سرقت کوکی های کاربران سوء استفاده کند. این فقط یک نمونه از چندین سرویس ChatGPT ساختگی است که برای فریب دادن قربانیان ناآگاه طراحی شده است.

3. عفونت بدافزار

اگر بدون اینکه متوجه شوید از یک چت ربات سایه دار استفاده می کنید، ممکن است ربات چت را پیدا کنید که لینک هایی به وب سایت های مخرب در اختیار شما قرار می دهد. شاید ربات چت شما را از یک هدیه وسوسه انگیز آگاه کرده باشد یا منبعی برای یکی از اظهارات خود ارائه کرده باشد. اگر اپراتورهای سرویس نیت غیرقانونی داشته باشند، تمام هدف پلتفرم ممکن است گسترش بدافزار و کلاهبرداری از طریق پیوندهای مخرب باشد.

از طرف دیگر، هکرها ممکن است یک سرویس چت بات قانونی را به خطر بیاندازند و از آن برای انتشار بدافزار استفاده کنند. اگر این ربات چت خیلی مردم باشد، هزاران یا حتی میلیون ها کاربر در معرض این بدافزار قرار خواهند گرفت. برنامه های جعلی ChatGPT حتی در اپ استور اپل نیز وجود داشته است، بنابراین بهتر است با دقت قدم بردارید.

به طور کلی، هرگز نباید روی پیوندهایی که یک چت بات ارائه می کند، قبل از اجرای آن از طریق یک وب سایت بررسی پیوند، کلیک کنید. این ممکن است آزاردهنده به نظر برسد، اما همیشه بهتر است مطمئن شوید که سایتی که به آن هدایت میشوید طراحی مخربی ندارد.

علاوه بر این، هرگز نباید افزونهها و افزونههای چت بات را بدون تأیید مشروعیت آنها نصب کنید. کمی در اطراف برنامه تحقیق کنید تا ببینید آیا به خوبی بررسی شده است یا خیر، و همچنین توسعه دهنده برنامه را جستجو کنید تا ببینید آیا چیزی مبهم پیدا کرده اید یا خیر.

چت بات ها در برابر مسائل حریم خصوصی غیرقابل نفوذ نیستند

مانند بسیاری از ابزارهای آنلاین امروزی، چت بات ها به دلیل مشکلات احتمالی امنیتی و حریم خصوصی خود بارها مورد انتقاد قرار گرفته اند. خواه ارائهدهنده ربات چت در مورد ایمنی کاربر، یا خطرات مداوم حملات سایبری و کلاهبرداریها، گوشهها را کاهش میدهد، بسیار مهم است که بدانید سرویس چت بات شما چه چیزی را از شما جمعآوری میکند و آیا از اقدامات امنیتی کافی استفاده میکند یا خیر.