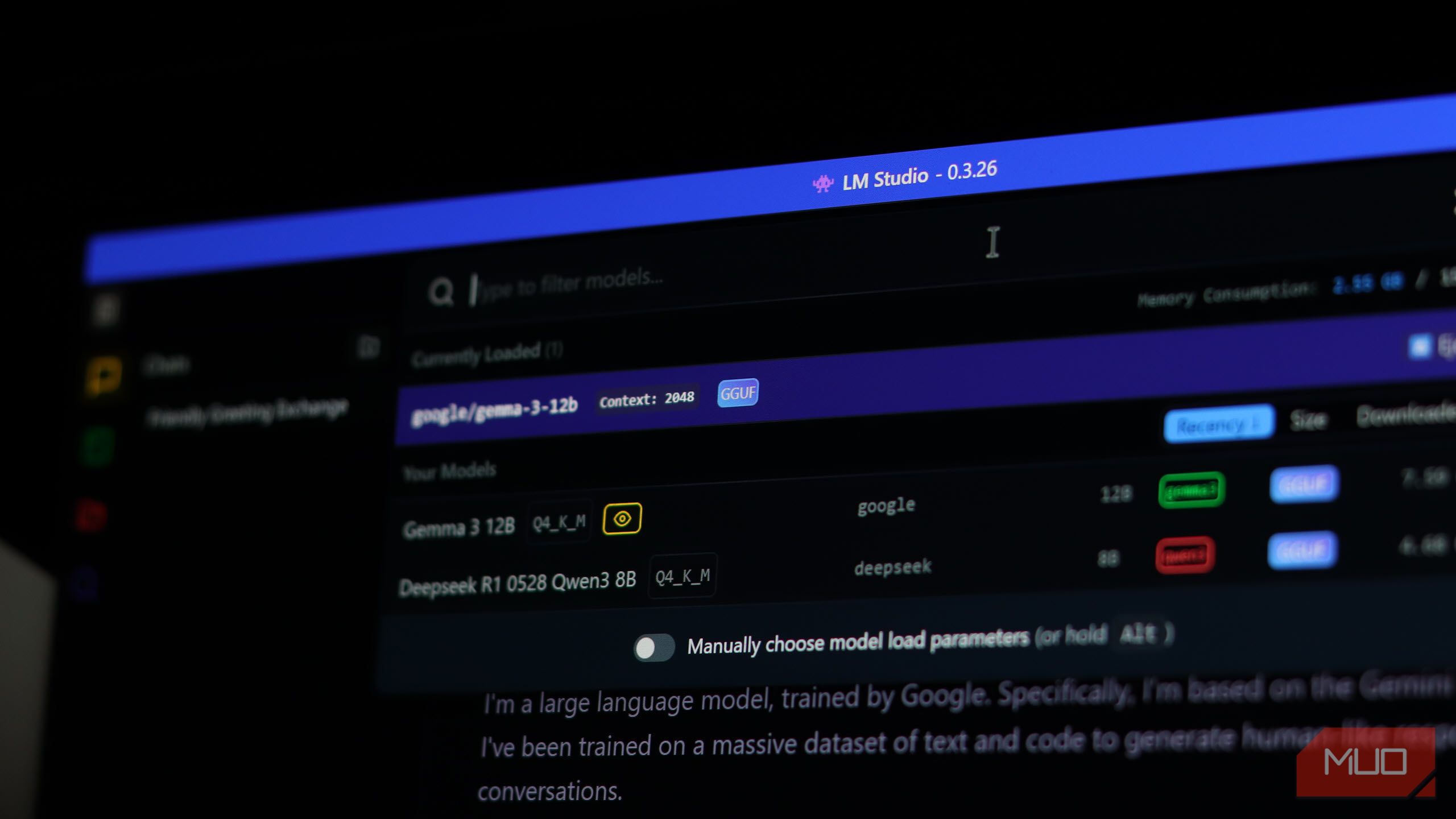

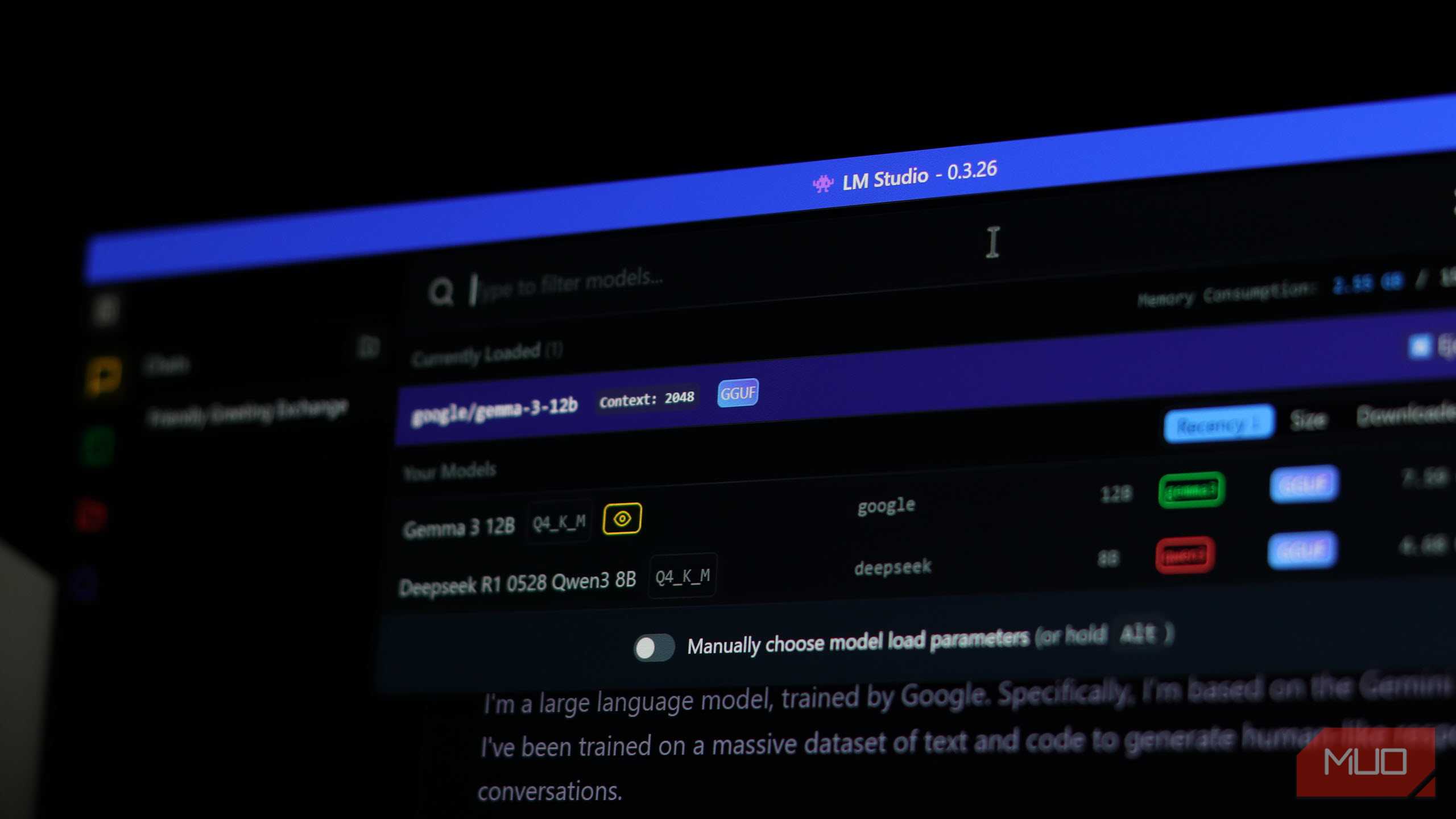

اگر شما یک مدل زبانی محلی (LLM) را از طریق Ollama یا LM Studio اجرا میکنید، قبلاً از جذابیت آن میدانید—حریم خصوصی، صفر هزینه API و کنترل کامل بر روی پشتهٔ هوش مصنوعی خود. اما یک LLM محلی به تنهایی در یک پنجرهٔ ترمینال محبوس است. میتواند متن تولید کند و هر دادهای که فراهم میکنید را تجزیه و تحلیل کند، اما نمیتواند کاری در دنیای واقعی انجام دهد.

اگر مدل بزرگ زبانی (LLM) محلی را از طریق Ollama یا LM Studio اجرا میکنید، جذابیت آن را میدانید—حریم خصوصی، هزینهٔ صفر API و کنترل کامل بر روی ساختار هوش مصنوعی خود. اما یک LLM محلی به تنهایی در یک پنجرهٔ ترمینال گرفتار است. میتواند متن تولید کند و دادههای ارائهشده را تحلیل کند، اما نمیتواند در دنیای واقعی کاری انجام دهد.

MCP ممکن است ترسناک بهنظر برسد، اما دقیقاً در همین جا بهدرد میخورد. این یک پروتکل استاندارد ساده است که به مدل شما امکان میدهد با پایگاههای داده، سیستمهای فایل، وباسکرپرها و حتی دستگاههای خانهٔ هوشمند صحبت کند. راههای جالب بسیاری وجود دارد که میتوانید از آن برای انجام انواع کارها با مدلهای محلی خود استفاده کنید.

سوالات پایگاه داده خود را مانند یک انسان بپرسید

پرسوجو در SQL، لاگها و APIها بدون نیاز به زبان پرسوجو

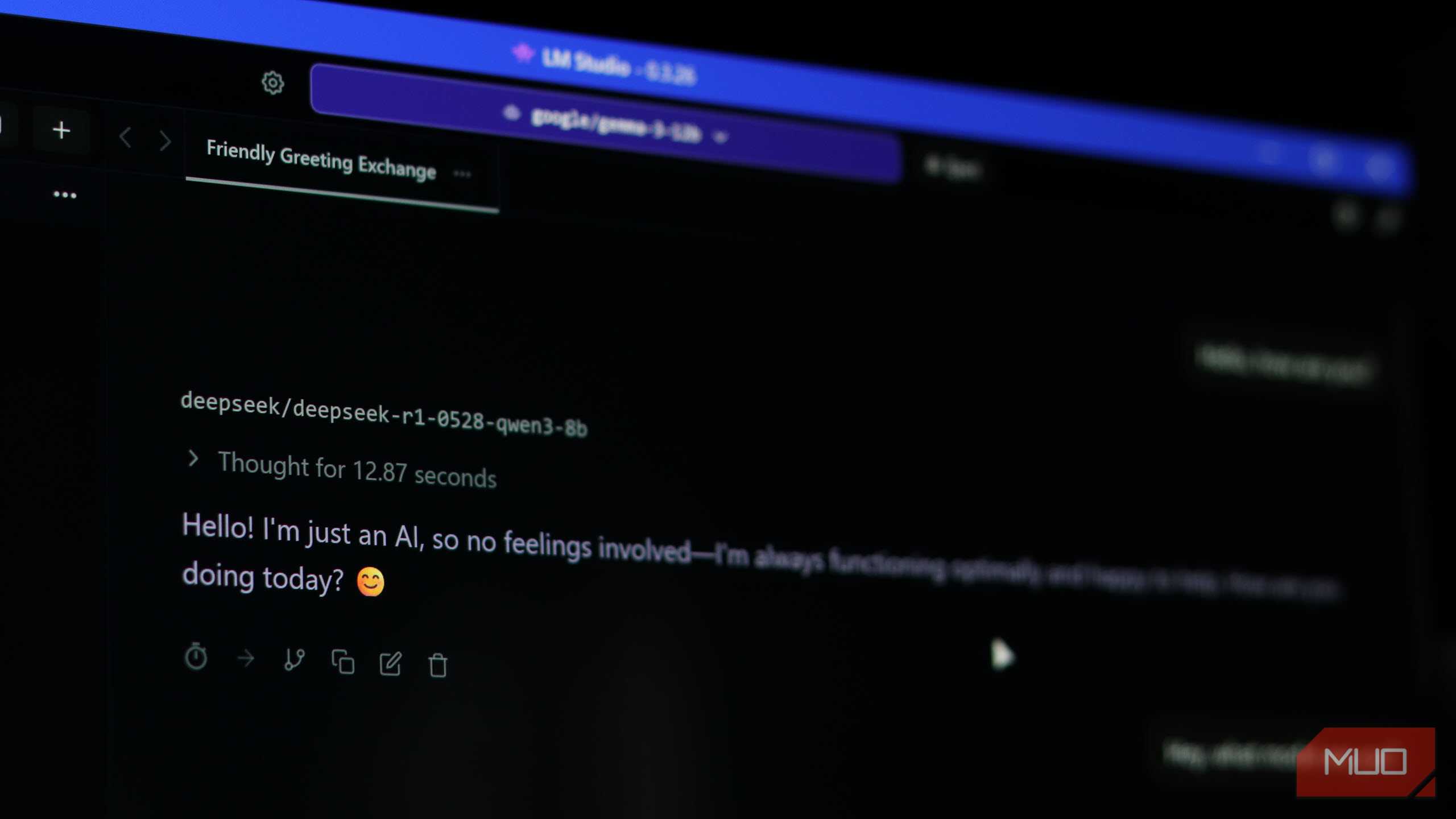

یکی از کاربردهای عملی بلافصل که میتوانید با استفاده از ابزارهای MCP یک LLM محلی داشته باشید، صحبت کردن با پایگاههای داده به جای ارسال پرسوجوهای پیچیده است. با یک سرور سادهٔ MCP برای SQLite، PostgreSQL یا MySQL، LLM محلی شما میتواند بهعنوان رابط پایگاه داده به زبان طبیعی عمل کند.

میتوانید چیزی شبیه به «تمام ورودیهای ایجاد شده در ۱۰ روز گذشته را نشان بده» تایپ کنید، و بهجای نوشتن دستی SQL، مدل پرسوجو را از طریق ابزار MCP مینویسد و اجرا میکند، سپس دادهها را به شکل قابلخواندن نمایش میدهد.

بسته به سرور MCP که استفاده میکنید، ممکن است به ابزارهایی مانند execute_sql_query، list_tables و insert_data دسترسی داشته باشید، بنابراین LLM میتواند ساختار دیتابیس شما را کاوش کند، روابط را درک کند و پرسوجوهای دقیق بسازد. برای توسعهدهندگان و افراد داده که پایگاههای داده محلی را مدیریت میکنند، این صرفهجویی زیادی در زمان است. و چون همه چیز روی ماشین شما اجرا میشود، دادههای مالکی را به هیچیک از سرویسهای ابری ارسال نمیکنید.

یک هوش مصنوعی محلی بسازید که تحقیقات واقعی انجام دهد

اجازه دهید LLM محلی شما منابع را بخواند، مقایسه کند و خلاصه کند

میتوانید LLM محلی خود را به یک سرور MCP متصل کنید که ابزار جستجو و اسکرپ وب مثل SearXNG MCP یا Firecrawl MCP را در بر میگیرد و ویژگیهای تحقیق عمیقی که در ابزارهایی مثل ChatGPT و Perplexity میبینید، بازتولید کند. وقتی یک پرسش تحقیقاتی میفرستید، مدل جستجوهای متعدد را سازماندهی، تجزیه و تحلیل میکند و نتایج را قبل از ارائهٔ گزارش نهایی با استنادات بررسی میکند.

میتوانید از ابزارهایی مانند CrewAI برای ارکستراسیون چندعامله با Ollama که DeepSeek-R1 را بهصورت محلی سرو میکند، و یک ابزار جستجوی وب MCP مثل Linkup یا Brave Search استفاده کنید که جستجوهای اینترنی را مدیریت میکند. خط لوله تحقیق به یک عامل جستجوگر، یک عامل تحلیلگر و یک عامل نویسنده تقسیم میشود که هرکدام بهعنوان نیاز از ابزارهای مختلف MCP فراخوانی میکنند.

ممکن است بهسرعت یک راهحل ابری نباشد، اما رایگان، خصوصی است و به LLM محلی شما اجازه میدهد تا Perplexity یا ChatGPT را برای تحقیقات عمیق جایگزین کند. حتی میتوانید آن را به فورومها یا سایتهای مستندات خاصی که موتورهای جستجوی سنتی معمولاً نادیده میگیرند، ارجاع دهید.

یادداشتهای نامنظم را به یک ویکی شخصی هوشمند تبدیل کنید

جستجوی ایدهها، لینکها و افکار با استفاده از معنا، نه کلیدواژهها

میتوانید مدل محلی خود را به Obsidian متصل کنید با MCP و یک رابط جستجوی زبان طبیعی برای تمام یادداشتها و پایگاه دانش شخصی خود دریافت کنید. سرور MCP Obsidian به مدل شما اجازه میدهد که یادداشتها را بخواند، جستجو کند، بنویسد و مدیریت کند در تمام مخزن شما. میتوانید از آن بخواهید یادداشتهای شما در یک موضوع را خلاصه کند، ارتباطات بین ایدهها را پیدا کند، یا حتی یادداشتهای جدیدی بر پایه مطالب موجود بنویسد.

سود واقعی این است که سیستم فایل مخزن شما عملاً تبدیل به حافظهٔ هوش مصنوعی میشود. نیازی به پایگاه دادهٔ برداری نیست چون ساختار دایرکتوری زمینهٔ سازماندهی را فراهم میکند، در حالی که ابزارهای MCP عملیات واقعی فایل را بر عهده میگیرند. حتی میتوانید آن را با Git برای کنترل نسخه ترکیب کنید—بهطوری که هوش مصنوعی بتواند با اطمینان یادداشتهای شما را ویرایش کند، در حالی که شما میتوانید هر زمان بهسرعت به حالت قبلی برگردید.

خانهٔ هوشمند خود را بهصورت کامل آفلاین اجرا کنید

دستگاهها را بهصورت محلی کنترل کنید بدون ارسال داده به ابر

اجرای یک LLM محلی بهعنوان مغز خانهٔ هوشمند یکی از پرچالشترین موارد استفاده است، اما در حال حاضر امکانپذیر است. Home Assistant یک یکپارچهسازی سرور MCP رسمی دارد که دستگاهها، موجودیتها و خودکارسازیهای شما را به هر کلاینت سازگار با MCP در دسترس میگذارد. یک نمونهٔ LLM محلی را وصل کنید و میتوانید چراغها، ترموستاتها و حسگرها را با زبان طبیعی، بهصورت کامل آفلاین کنترل کنید.

حتی میتوانید از دستگاههای ARM کوچک مانند Raspberry Pi برای ساخت این تنظیمات استفاده کنید، بهشرط اینکه مدلی کمینهشده داشته باشید که میتواند روی سختافزار کمقدرت اجرا شود. چون همه چیز در شبکهٔ محلی شما رخ میدهد، نیازی به نگرانی در مورد ارسال ضبطهای صوتی به شرکتهای بزرگ یا وابستگی به اتصال اینترنت ندارید. این باعث میشود کنترل مؤثر خانهٔ هوشمند برای علاقهمندان به حریم خصوصی عملی باشد.

به کامپیوتر خود بگویید چگونه فایلها را مدیریت کند

پوشهها را با زبان ساده مرتب، تغییر نام و تمیز کنید

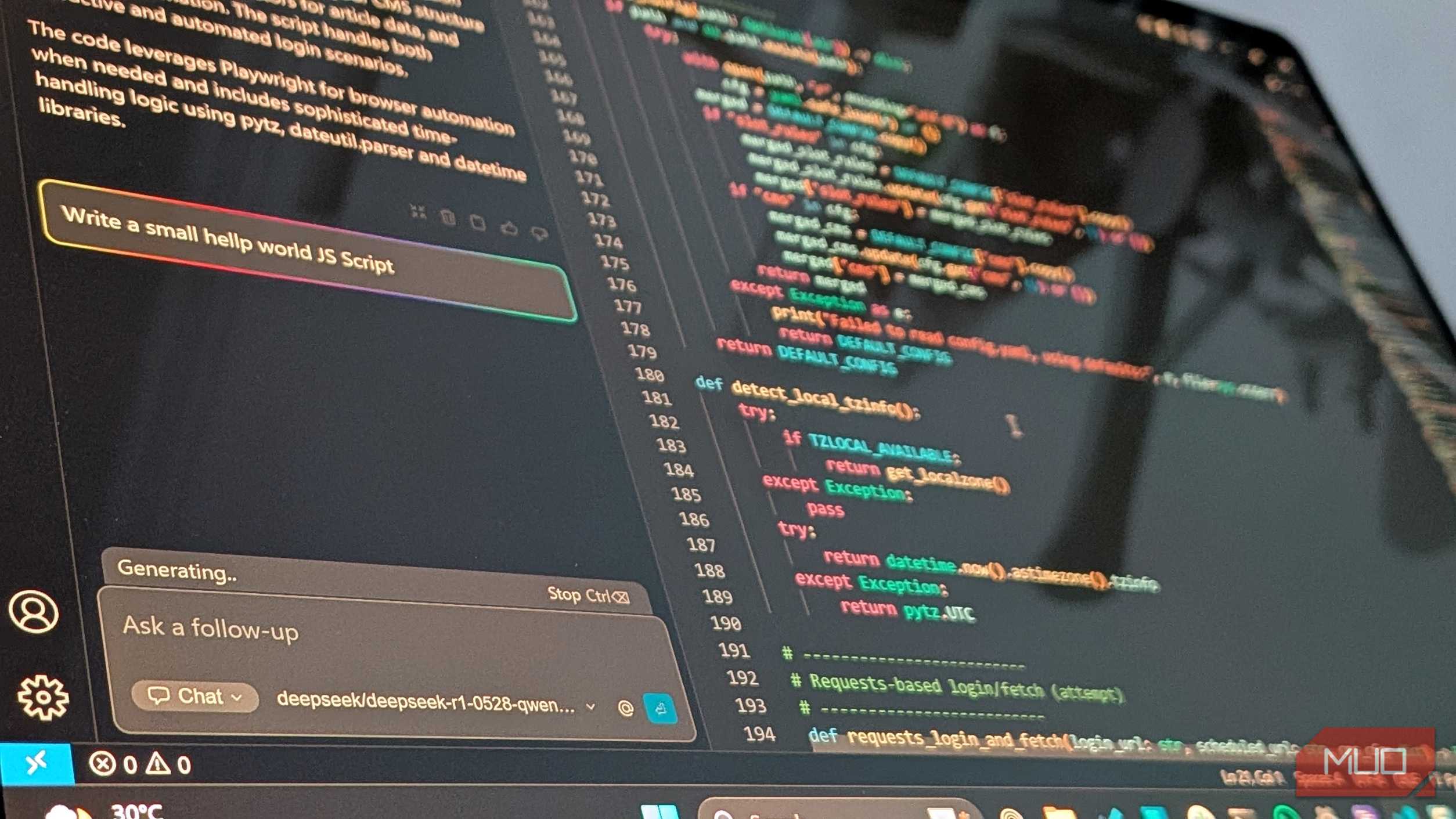

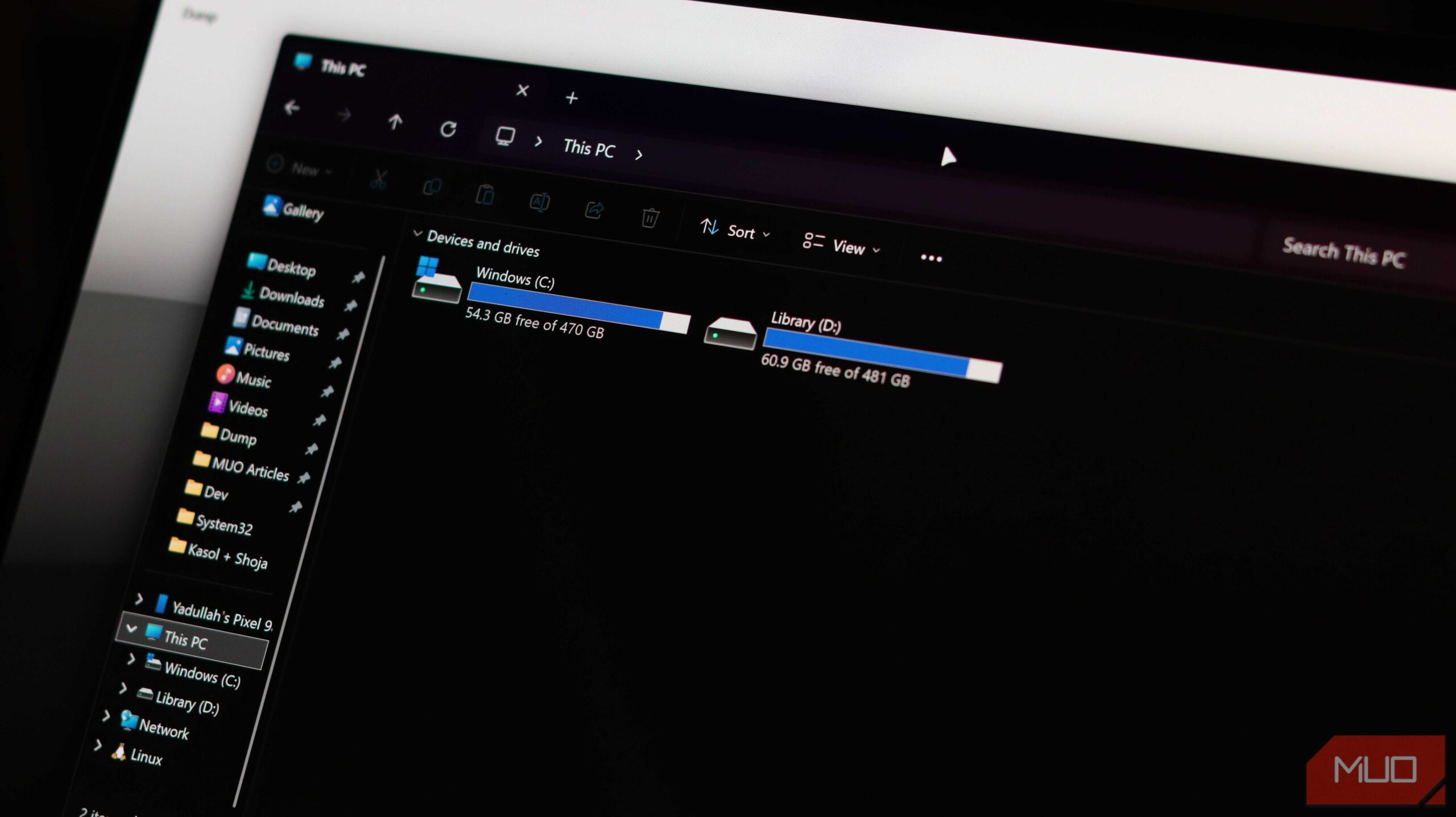

مدیریت فایلها یکی از کارهای خستهکنندهٔ هر سیستم عاملی است. میتوانید از سرور MCP فایلسیستم که یکی از سادهترین ابزارهای این اکوسیستم است، استفاده کنید؛ این ابزار به LLM محلی شما امکان میدهد فایلها را در یک دایرکتوری پروژهٔ ایزوله بخواند، بنویسد، ویرایش کند، منتقل و حذف کند. میتوانید آنچه میخواهید بهصورت زبان ساده توصیف کنید، مانند تغییر نام تمام فایلهای jpeg در یک پوشه یا یافتن تمام فایلهای Python که pandas را وارد میکنند، و مدل آن را به عملیات واقعی فایل تبدیل میکند.

گزارش MUO: مشترک شوید و هرگز موارد مهم را از دست ندهید

این برای عملیاتهای دستهای که در غیر این صورت نیاز به نوشتن اسکریپت کوتاهی دارند، بهویژه مفید است. ویژگی ایمنی کلیدی، ایزولهسازی است: سرور MCP تمام عملیات را به یک دایرکتوری مشخص محدود میکند، بنابراین حتی اگر مدل فرمان مخرب تولید کند، آسیب بهصورت محدود میماند.

با ترکیب این ابزار با یک مدل کدگذاری قدرتمند مثل Qwen 2.5 Coder، ترمینال شما به یک دستیار مؤثر مدیریت فایل تبدیل میشود. این بهویژه برای کاربران لینوکس مفید است، چرا که میتوانید لایهٔ زبان طبیعی را بر روی دستورات معمولی mv، cp و find داشته باشید بدون این که کنترل را از دست بدهید.

MCP قدرت واقعی LLMهای محلی را آزاد میکند

چیزی که این موارد استفاده را جذاب میکند، فقط موارد فردی نیست—بلکه این است که MCP به شما اجازه میدهد آنها را ترکیب کنید. همان LLM محلی میتواند دیتابیس شما را پرسوجو کند، در وب جستجو کند، یادداشتهای شما را سازماندهی کند و فایلهایتان را مدیریت کند، همه اینها از طریق یک پروتکل استاندارد واحد.

هوش مصنوعی نیازی به هزینهٔ هزاران تومان ندارد—مدلهای محلی سریع، خصوصی و سرانجام شایستهٔ انتقال هستند.

اکوسیستم سرورهای MCP ساختهشده توسط جامعه به سرعت در حال رشد است، بنابراین احتمالاً هر ابزاری یا سرویسایی که میخواهید به آن وصل شوید، قبلاً سروری برای آن ساخته شده است. و اگر هنوز ساخته نشده باشد، ساخت یک سرور MCP خودتان یک پروژهٔ آخر هفتهای بهسوی پیشبینیپذیر است.