چت های AI مبتنی بر ابر مانند Chatgpt و Gemini راحت هستند ، اما آنها با تجارت همراه هستند. اجرای یک LLM محلی – فناوری پشت AI Chatbot – شما را کنترل می کند ، دسترسی آفلاین و حریم خصوصی داده های قوی تر را ارائه می دهد. و گرچه ممکن است به نظر فنی باشد ، برنامه های مناسب شروع به کار برای هر کسی آسان می کنند.

چت های AI مبتنی بر ابر مانند Chatgpt و Gemini راحت هستند ، اما آنها با تجارت همراه هستند. اجرای یک LLM محلی – فناوری پشت AI Chatbot – شما را کنترل می کند ، دسترسی آفلاین و حریم خصوصی داده های قوی تر را ارائه می دهد. و گرچه ممکن است به نظر فنی باشد ، برنامه های مناسب شروع به کار برای هر کسی آسان می کنند.

5

اولاما

Ollama یک برنامه کاربر پسند است که برای کمک به افراد به طور مؤثر LLM های محلی بدون نیاز به تخصص فنی کمک می کند. این امکان را به شما می دهد تا مدل های قدرتمند AI را روی سخت افزار درجه مصرف مانند لپ تاپ اجرا کنید. اولاما از سادگی و دسترسی خود متمایز است و نیازی به راه اندازی پیچیده ندارد.

این مدل ها از مدل های متنوعی پشتیبانی می کند و یک برنامه دسک تاپ در MacOS ، Windows و Linux موجود است ، بنابراین هر کدام از سکوهایی که استفاده می کنید ، تحت پوشش قرار می گیرید. فرآیند تنظیم ساده است و در هیچ زمان ، شما آماده اجرای LLMS در دستگاه خود خواهید بود.

برای راه اندازی یک مدل ، شما از فرمان Ollama Run [شناسه مدل] استفاده می کنید. در پایان می توانید یکی از LLM های پشتیبانی شده را مشخص کنید. به عنوان مثال ، برای اجرای مدل PHI 4 مایکروسافت ، فقط دستور زیر را وارد کنید:

ollama run phi4

برای Llama 4 ، Run:

ollama run llama4

مدل مشخص شده بارگیری و شروع به کار می کند. سپس می توانید با آن مستقیماً از خط فرمان گپ بزنید. به عنوان مثال ، می توانید با استفاده از Ollama ، Deepseek را به صورت محلی روی لپ تاپ اجرا کنید.

4

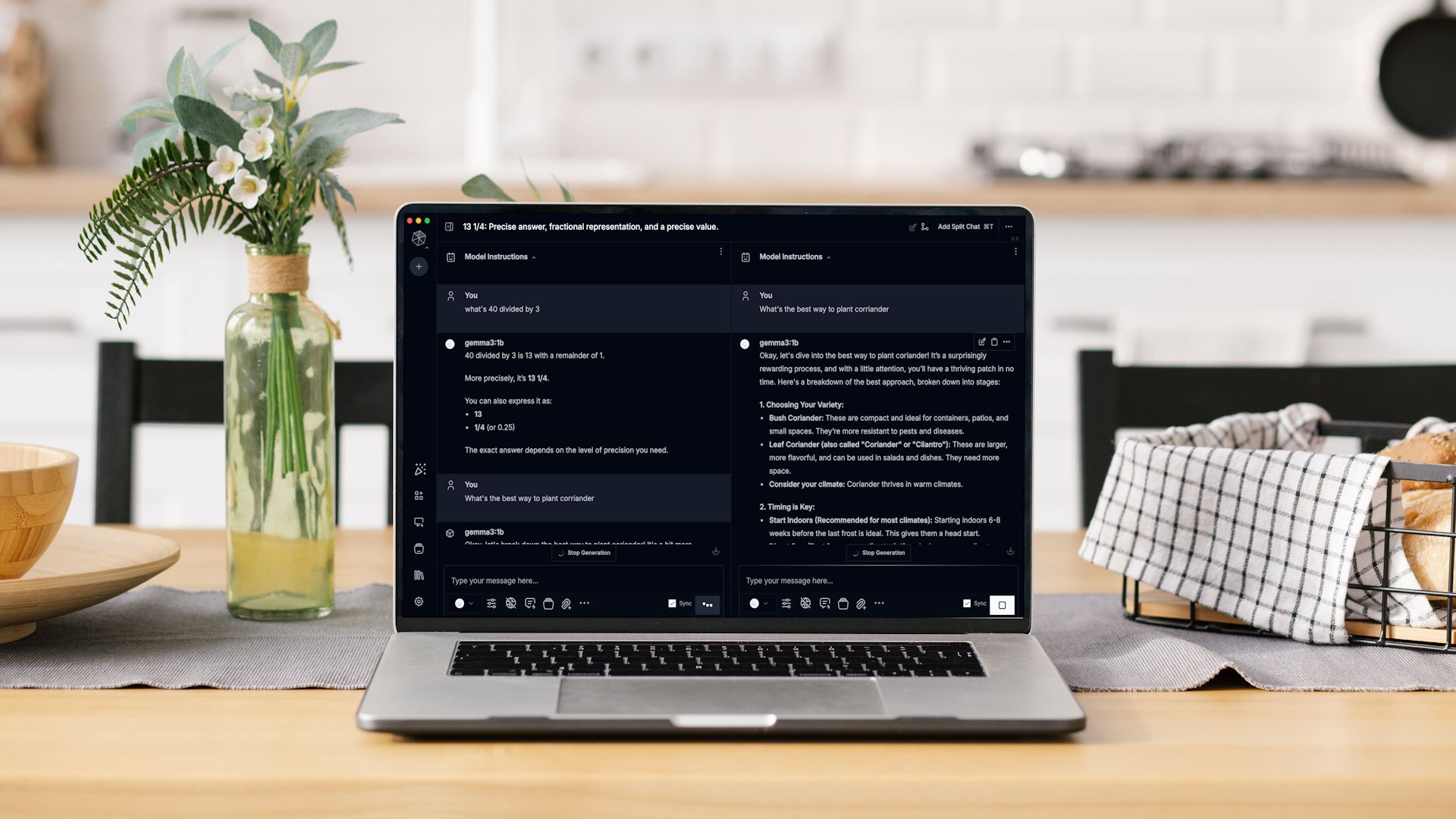

مگس

مشابه Ollama ، MSTY یک برنامه کاربر پسند است که اجرای LLM های محلی را ساده می کند. MSTY در دسترس برای ویندوز ، MACOS و LINUX ، پیچیدگی هایی را که اغلب با اجرای LLMS به صورت محلی مرتبط است ، مانند تنظیمات Docker یا رابط های خط فرمان ، از بین می برد.

این مدل ها را با گزینه های محبوب مانند Llama ، Deepseek ، Mistral و Gemma می توانید بر روی دستگاه خود اجرا کنید. همچنین می توانید برای کشف چت های جدید AI ، مدل های مستقیم را در بغل کردن Face ، سایت من جستجو کنید. پس از نصب ، برنامه به طور خودکار یک مدل پیش فرض را برای دستگاه شما بارگیری می کند.

پس از آن ، می توانید هر مدلی را که دوست دارید از کتابخانه بارگیری کنید. اگر ترجیح می دهید به هر قیمتی از خط فرمان خودداری کنید ، MSTY برنامه مناسبی برای شماست. رابط کاربری آسان آن باعث می شود تجربه احساس حق بیمه کند.

این برنامه همچنین شامل کتابخانه ای از اعلان ها با چندین گزینه از پیش ساخته شده است که می توانید برای هدایت مدل های LLM و اصلاح پاسخ ها از آنها استفاده کنید. همچنین شامل فضای کاری برای سازماندهی چت ها و وظایف شما است.

3

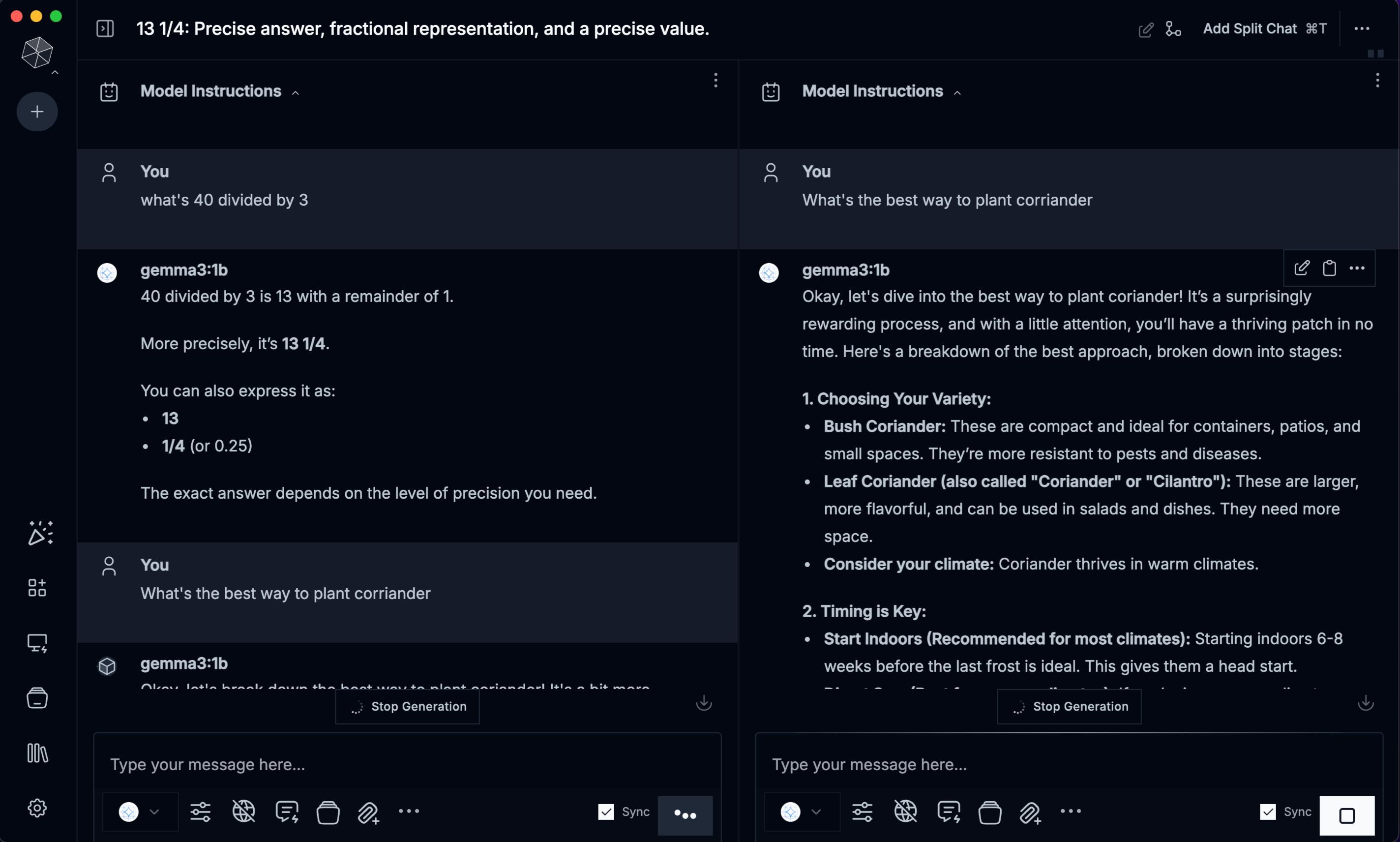

هر چیزی

هر چیزی یک برنامه دسک تاپ مفید است که برای کاربرانی که می خواهند LLM ها را به صورت محلی و بدون تنظیم پیچیده اجرا کنند ، طراحی شده است. از نصب تا اولین سریع خود ، این روند صاف و بصری است. احساس می کنید از LLM مبتنی بر ابر استفاده می کنید.

در حین تنظیم ، می توانید مدل های مورد نظر خود را بارگیری کنید. برخی از بهترین LLM های آفلاین ، از جمله Deepseek R1 ، Llama 4 ، Microsoft Phi 4 ، Phi 4 Mini و Mistral ، برای بارگیری در دسترس هستند.

مانند اکثر برنامه های موجود در این لیست ، هر چیزی کاملاً منبع باز است. این شامل ارائه دهنده LLM خاص خود است و همچنین از چندین منبع شخص ثالث ، از جمله Ollama ، LM Studio و AI محلی پشتیبانی می کند و به شما امکان می دهد مدل های این منابع را بارگیری و اجرا کنید. به همین دلیل ، به شما امکان می دهد صدها ، اگر نه هزاران مدل LLM موجود در وب را اجرا کنید.

2

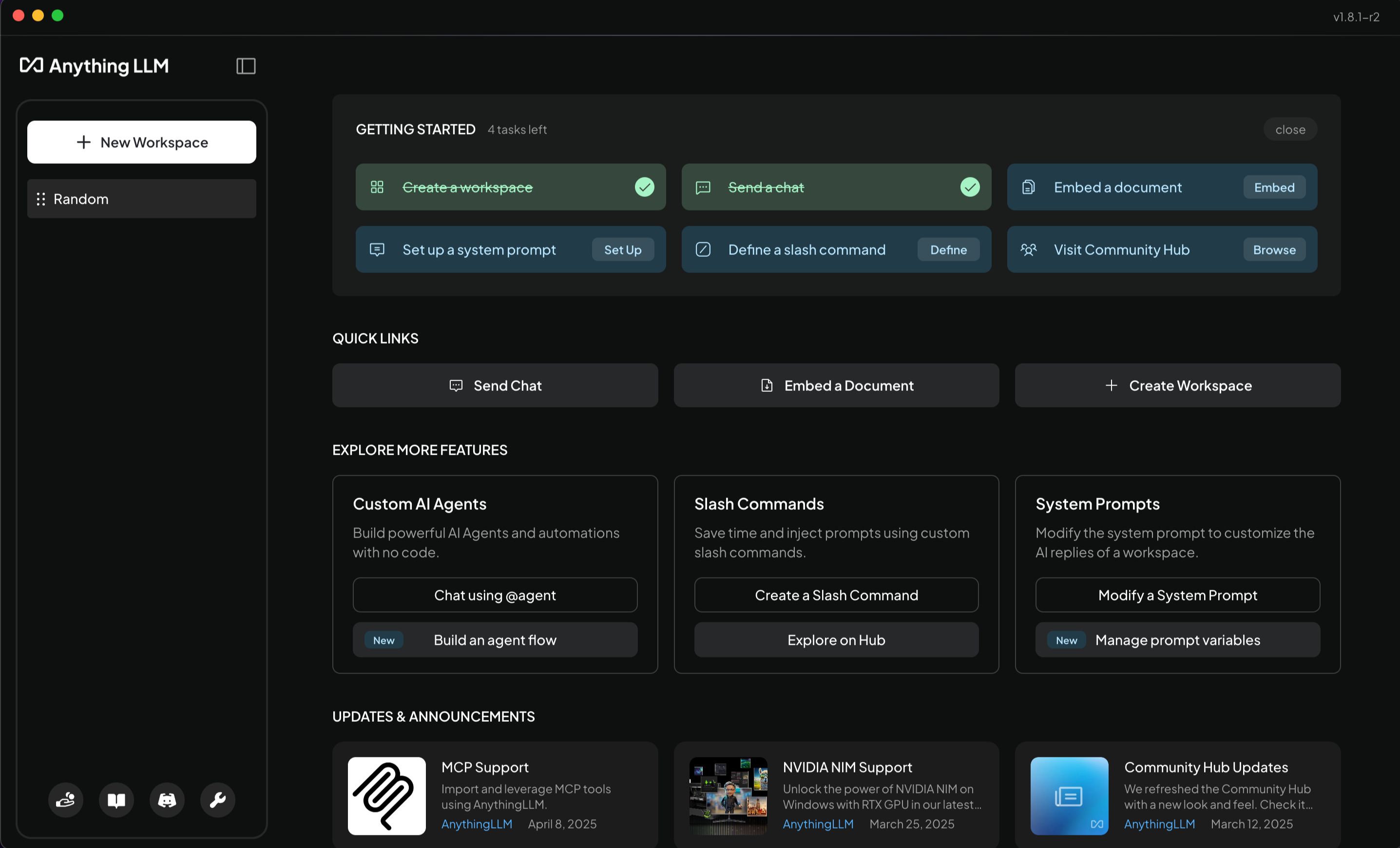

ژانویه

جان خود را به عنوان یک گزینه جایگزین چتپپ به بازار عرضه می کند که به صورت آفلاین اجرا می شود. این یک برنامه دسک تاپ براق برای اجرای مدل های مختلف LLM به صورت محلی در دستگاه شما فراهم می کند. شروع کار با جان آسان است. پس از نصب برنامه (موجود در ویندوز ، MacOS و Linux) ، چندین مدل LLM برای بارگیری در اختیار شما قرار می دهد.

فقط تعداد انگشت شماری از مدل ها به طور پیش فرض نشان داده می شوند ، اما اگر نمی بینید که به دنبال چه چیزی هستید ، می توانید URL صورت بغل را جستجو یا وارد کنید. همچنین می توانید یک فایل مدل (با فرمت GGUF) را در صورتی که در حال حاضر محلی دارید وارد کنید. واقعاً آسانتر از این نیست. این برنامه شامل LLM های مبتنی بر ابر در لیست های خود است ، بنابراین حتماً فیلتر مناسب را برای حذف آنها اعمال کنید.

استفاده از یک مدل زبان بزرگ محلی برای همه نیست ، اما دلایل خوبی وجود دارد که ممکن است بخواهید امتحان کنید.

1

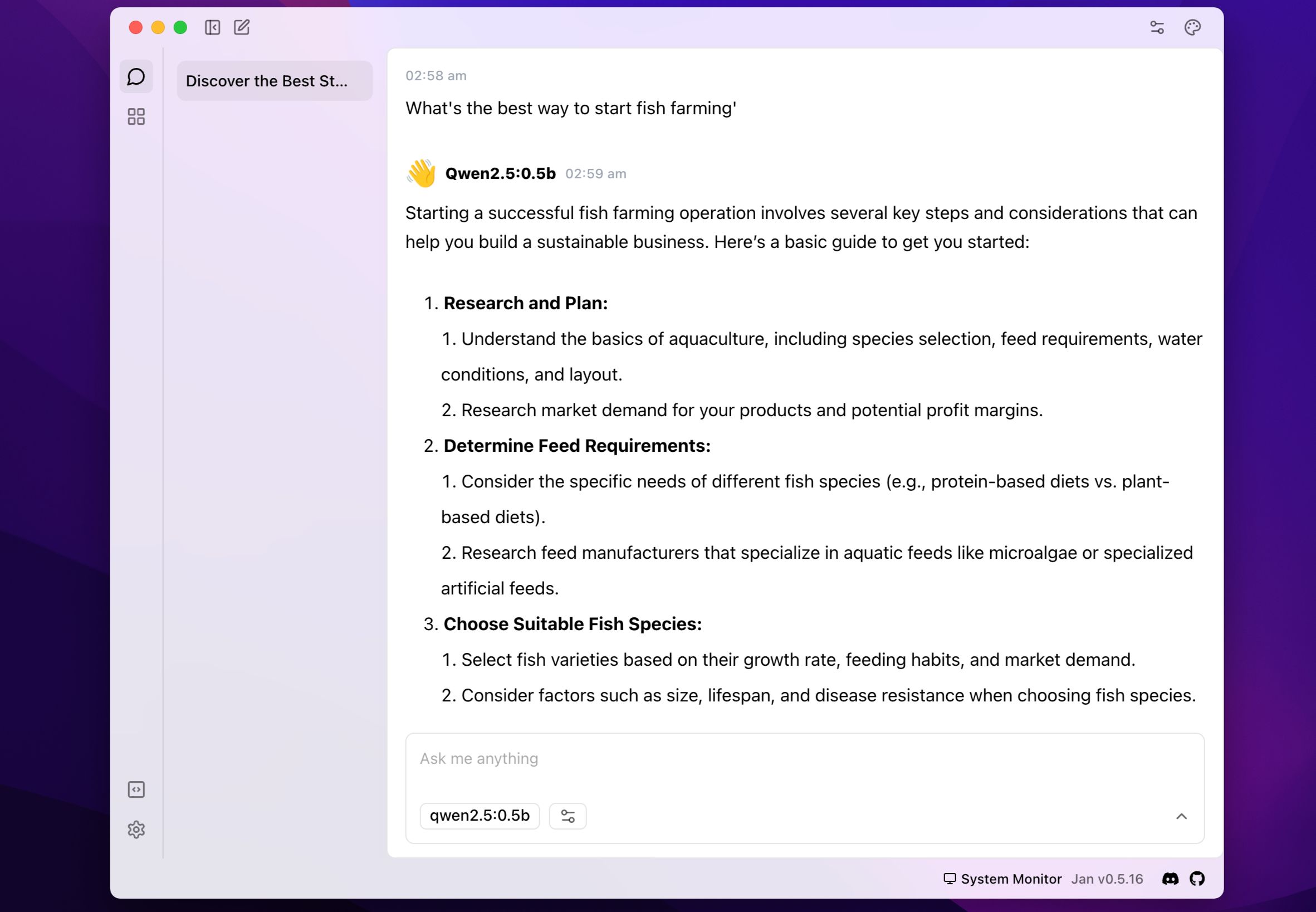

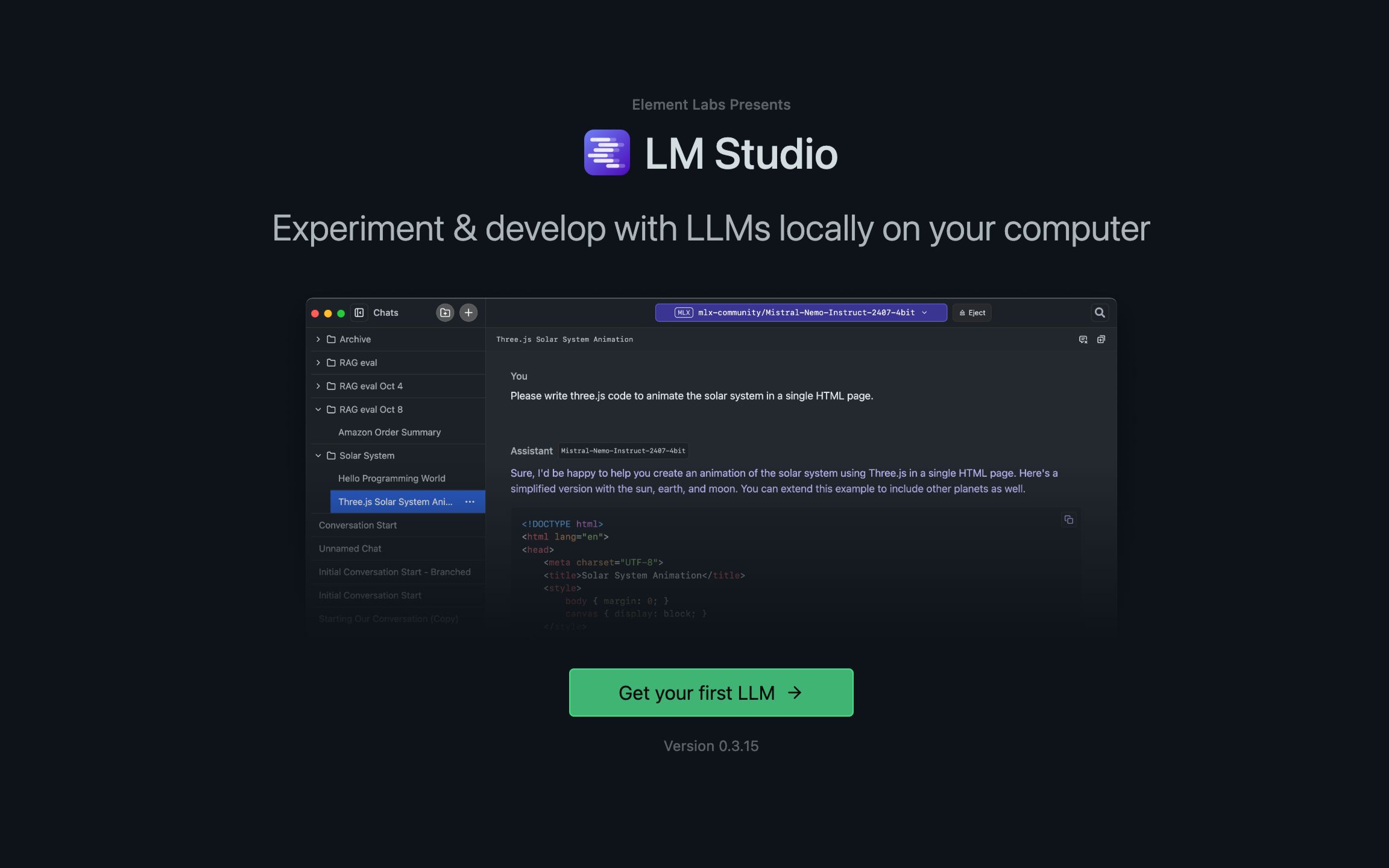

استودیوی LM

LM Studio برنامه دیگری است که یکی از در دسترس ترین راه ها برای اجرای LLM های محلی در دستگاه شما را فراهم می کند. این یک برنامه دسک تاپ (در دسترس در MacOS ، Windows و Linux) به شما می دهد که به شما امکان می دهد LLMS را به راحتی در دستگاه خود اجرا کنید.

بعد از راه اندازی ، می توانید مدل های محبوب مانند Llama ، Mistral ، Gemma ، Deepseek ، Phi و Qwen را مستقیماً از بغل کردن چهره با تنها چند کلیک مرور و بارگذاری کنید. پس از بارگیری ، همه چیز به صورت آفلاین اجرا می شود ، و اطمینان می دهد که درخواست ها و مکالمات شما در دستگاه شما خصوصی باقی می مانند.

این برنامه دارای یک رابط کاربری بصری است که احساس آشنایی می کند ، بنابراین اگر از LLM های مبتنی بر ابر مانند کلود استفاده کرده اید ، در خانه احساس می کنید.

روش های زیادی برای اجرای LLM در Linux ، Windows ، MacOS یا هر سیستم استفاده شده وجود دارد. با این حال ، برنامه های ذکر شده در اینجا برخی از ساده ترین و راحت ترین راه های انجام این کار را ارائه می دهند. برخی از آنها ارتباط کمی با خط فرمان دارند ، در حالی که برخی دیگر ، مانند هر چیزی و جان ، به شما امکان می دهند همه چیز را از رابط کاربری گرافیکی (GUI) انجام دهید.

بسته به سطح راحتی فنی خود ، چند مورد را امتحان کنید و با یکی از مواردی که متناسب با نیازهای شما باشد ، بچسبید.