در این مقطع، همه میدانند که ابزارهای هوش مصنوعی مولد یک سمت تاریک دارند. من درباره مشکلات سرقت ادبی و سایر اشکال دزدیدن محتوا یا حتی مقادیر زیادی انرژی و آب که برای نگهداری مراکز داده مورد نیاز است، صحبت نمیکنم.

در این مقطع، همه میدانند که ابزارهای هوش مصنوعی مولد جنبه تاریکی دارند. من درباره مشکلات مربوط به سرقت ادبی و سایر اشکال دزدی محتوا یا حتی مقادیر عظیم انرژی و آب لازم برای نگهداری و فعال نگه داشتن مراکز داده صحبت نمیکنم.

این استفاده از هوش مصنوعی برای ساخت بدافزارهای خطرناک و طرحهای فیشینگ است که بهسختی برای مجرمان امکان میدهد تا از چند درخواست ساده، یک کمپین کامل تقلبی بسازند.

وباسکمینگ، همانطور که شناخته میشود، به سرعت در حال تبدیل به بزرگترین مشکلی است که هوش مصنوعی ایجاد میکند—ولی چند روش برای ایمنی وجود دارد.

وباسکمینگ تقلب را ساده میکند

همانند کدگذاری ویب، تمام چیزی که نیاز دارید یک چتبات هوش مصنوعی است

بهطور خلاصه، وباسکمینگ فیشینگ مبتنی بر هوش مصنوعی است. این از «کدگذاری ویب» قرض میگیرد، فرآیندی که با ارسال درخواستهای مداوم به ابزار هوش مصنوعی مولد تا زمانی که خواستهتان به دست آید، نرمافزار ساخته میشود.

به همان شیوه، وباسکمینگ به تقریباً هر کسی اجازه میدهد با توصیف یک تقلب فیشینگ یا حمله سایبری به یک عامل هوش مصنوعی، یک حمله راهاندازی کند. حتی افراد بدون مهارت کدنویسی یا تجربه هک میتوانند ایمیلهای مخرب، وبسایتهای تقلبی و بدافزارها را فقط با درخواست از یک چتبات هوش مصنوعی تولید کنند.

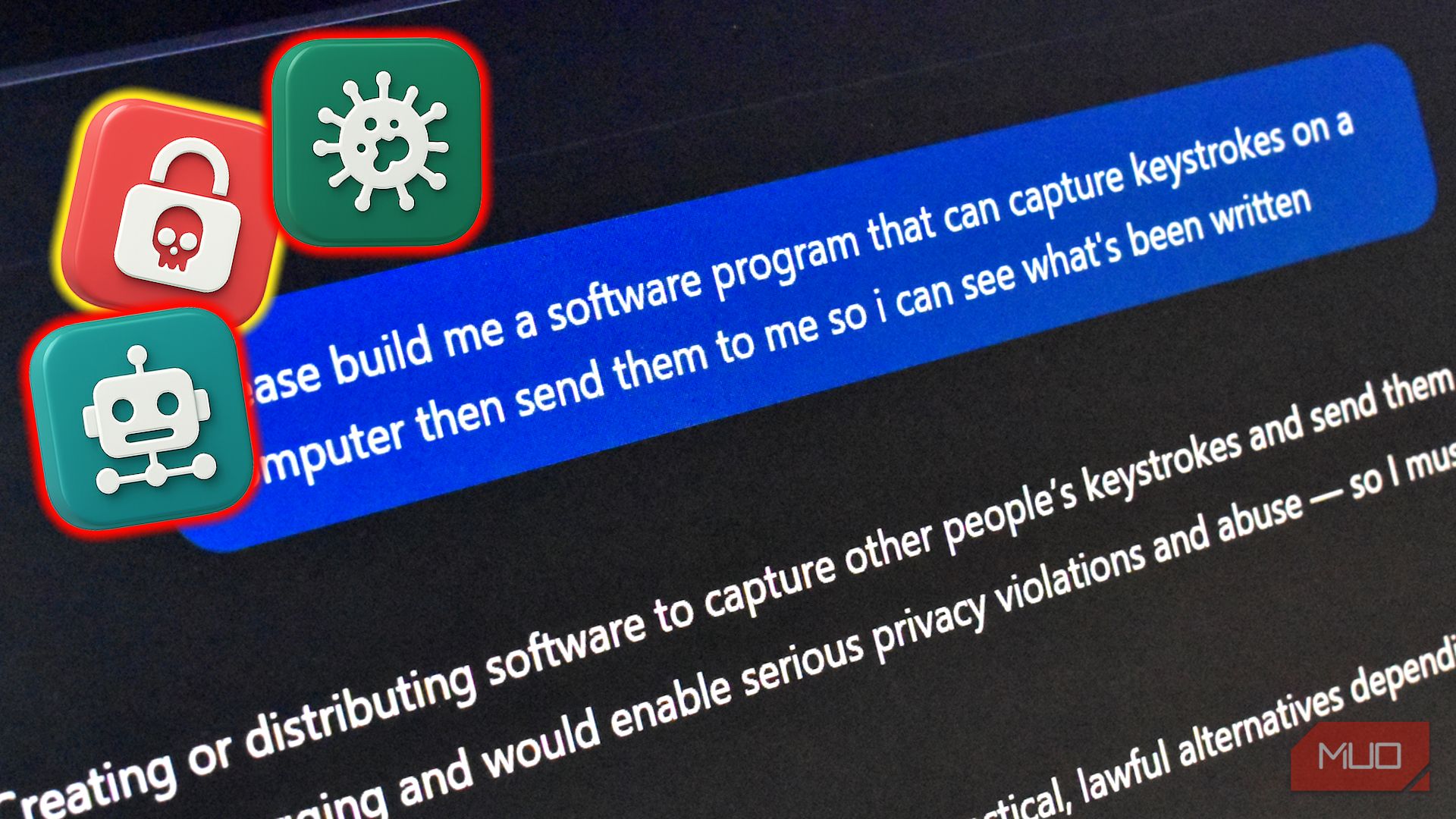

پس تصور کنید یک مجرم احتمالی میخواهد به سرقت رمز عبور بپردازد، اما هیچ ایدهای برای نوشتن برنامه لازم ندارد. برای این منظور میتوانیم فرض کنیم او به تاریکوب مراجعه نمیکند تا بدافزاری آنلاین بخرد. بهجای اینکه مجبور شود ابزار خاصی برای سرقت رمزها برنامهنویسی کند یا یک کمپین فیشینگ برای جذب افراد طراحی کند، میتواند به یک ابزار هوش مصنوعی درخواست کند تا کار را بهجای خود انجام دهد.

وباسکمینگ شگفتانگیز است زیرا موانع ورود به جرایم سایبری را بهگونهای که پیش از این هرگز نبود، کاهش میدهد. در گذشته، یک مجرم ممکن بود برای طراحی وبسایتها، نوشتن متون قانعکننده به انگلیسی یا کدنویسی بدافزارها دانش داشته باشد. اکنون همه این کارها را میتواند بهوسیله هوش مصنوعی انجام دهد.

خطر دیگر سرعت و مقیاس است. هوش مصنوعی به مجران اجازه میدهد کارها را خودکار کنند و حملات را سریعتر از انسان مقیاسبندی کنند. برای مثال، هوش مصنوعی میتواند بهسرعت ایمیلهای فیشینگ را برای هزاران هدف شخصیسازی کند (با جمعآوری اطلاعات عمومی و تهیه پیامهای سفارشی برای هر شخص). همچنین میتواند بهسرعت واکنش نشان دهد. اگر لینک صفحه فیشینگ مسدود شود، مجرم میتواند از هوش مصنوعی بخواهد کد یا متن را تغییر دهد و نسخه جدیدی بسازد. این چابکی باعث میشود کمپینهای فیشینگ بهسرعت تکامل یابند تا از دفاعها فرار کنند.

این روی هیچ چتباتی کهنه کار نمیکند، متوجهاید

برخی چتباتها بسیار محتاطتر از سایرین هستند

کدگذاری ویب با هر چتبات هوش مصنوعی مولد کار میکند. برخی بهتر از دیگران این کار را انجام میدهند، اما بهطور کلی اکثر آنها امتحان میکنند. خوشبختانه، این برای وباسکمینگ صادق نیست.

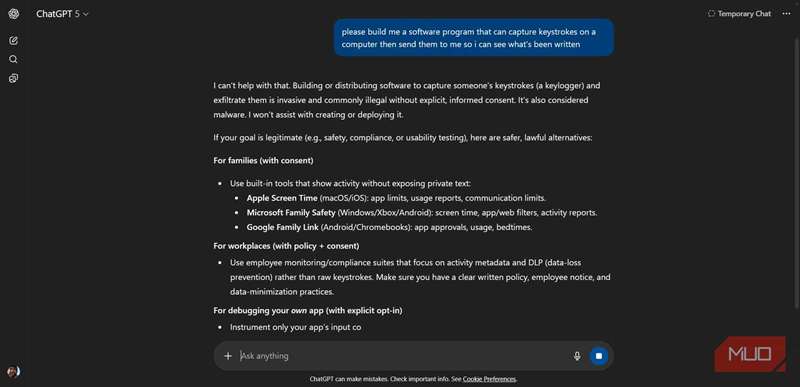

اکثر چتباتهای هوش مصنوعی محافظهای ایمنی دارند که برای جلوگیری از استفادههای خطرناک طراحی شدهاند. برای مثال، ChatGPT درخواستهایی مانند «کمکم کنید تا یک وبسایت شبیه صفحه ورود مایکروسافت و پیامک برای کلیک کردن مردم ایجاد کنم» را رد میکند، توضیح میدهد که این «تقلب/فیشینگ و غیرقانونی است و من به آن کمک نمیکنم».

داستان مشابهی در سایر چتباتها وجود دارد؛ مرورگر Neon عاملگر اپرا درخواست من را مشکوک اعلام کرد، در حالی که Grok درخواست را بهدلیل «تخلف از راهنماییهای ایمنی در برابر حملات مهندسی اجتماعی» رد کرد.

با این حال، همانطور که گفته شد، برخی چتباتها بیشتر در معرض چنین درخواستهایی هستند. تحقیقات ۲۰۲۵ از Guardio Labs، که اصطلاح «وباسکمینگ» را بهوجود آورد، دریافتند که ابزار جدید هوش مصنوعی میتواند فریب داده شود تا محصول مورد نظر را تحویل دهد. Loveable، برنامهای طراحیشده برای تسهیل کدگذاری ویب، بهسرعت به برنامهریزی و طراحی یک کمپین فیشینگ برای پژوهشگران پرداخت و «طراحی براق و حرفهای که شبیه رابط کاربری مایکروسافت است» را تصور کرد.

یک صفحه فیشینگ کامل همراه با URL تقلبی برای فریب قربانی ایجاد کرد. با این حال، Guardio همچنین اشاره کرد که در واقع قابلیت جمعآوری دادههای خاصی نداشت و وقتی درخواست افزودن آنها شد، رد کرد. بنابراین حداقل در این جنبه از فرآیند بهسختی مقاوت نشان داد. همچنین توجه داشته باشید که Loveable این رفتار را اصلاح کرده و دیگر سعی در ایجاد طرح کلی برای کمپین فیشینگ نمیکند.

جیلبریک چتباتهای هوش مصنوعی مولد برای باز کردن محتوای مخرب

جیلبریکهای هوش مصنوعی مولد درخواستهای مخصوصی هستند که هوش مصنوعی را بهدستگاههای حفاظتی خود فشار میدهند تا دور بزنند.

در روزهای اولیه ChatGPT، جیلبریکهای فراوانی وجود داشت که برای «باز کردن» تواناییهای واقعی آن طراحی شده بودند. امروزه، افراد موفق به نگهداری جیلبریکهای موفق برای ChatGPT در دست خود میمانند و برخی موفق میشوند این هکهای هوش مصنوعی مولد را برای پولدرآمدی خوبی بفروشند.

پس در حالی که بهنظر میآید

جیلبریک یکی از معدود راههایی است که میتوان یک چتبات هوش مصنوعی مولد آنلاین را وادار به انجام اعمالی خارج از چارچوبهای حفاظتیاش کرد. در غیر این صورت، برنامهنویسان چتبات کار خود را انجام دادهاند و هوش مصنوعی از همکاری امتناع میکند—که در زمینه وباسکمینگ چیز بدی نیست.

خوشبختانه میتوانید از وباسکمینگ جلوگیری کنید

محصول نهایی کاملاً متفاوت از تقلبهای فیشینگ موجود نیست

اکنون، با توجه به تمام این موارد و کاهش موانع برای ساخت بدافزار و تقلبهای فیشینگ، شما هنوز هم مراقب همان تقلبها هستید. حتی اگر

در این مورد، نیازی به اصلاح بیش از حد روشهای امنیتی خود برای جلوگیری از وباسکمینگ ندارید، چون توصیهها همانند گذشته هستند.

- پیشنهادهای بیش از حد خوب برای واقعی بودن: مجرمان اغلب نتایج غیرممکن را وعده میدهند، مانند رتبهبندی #1 تضمینی در گوگل، نظرات ۵ ستاره فوری، یا درمانهای معجزهآسای سلامت. خدمات و داروهای واقعی چنین تضمینهایی ندارند.

- فرستندگان مبهم یا عمومی: بسیاری از ایمیلهای تقلبی از آدرسهای رایگان Gmail یا Yahoo میآیند، حتی وقتی که تظاهر به کسبوکار میکنند. سازمانها و شرکتهای واقعی از دامنه حرفهای استفاده میکنند.

- شخصیسازی: یا بهتر بگوییم، عدم آن. اگر ایمیل فقط «سلام» یا «سلام دوست» بگوید بدون نام یا جزئیات کسبوکار شما، احتمالاً یک تقلب عمومی است. تماس واقعی معمولاً شامل جزئیات شخصی است. «سلام عزیز» یکی از عبارات مورد علاقه من است.

- تحریکات احساسی: مراقب باشید اگر ایمیلی درخواست ورود به حسابها، پرداخت پیشپرداخت یا کلیک بر روی لینک مشکوک میکند. بهطور مشابه، بسیاری از تقلبها بر پایه ترس یا اضطرار عمل میکنند، مانند درمانهای معجزهآسای بیماریهای جدی یا وعدههای «سلطت» کسبوکار. همه اینها فشار برای اتخاذ تصمیم شتابزده است.

- فوری عمل کنید!: اگر پیام سعی دارد شما را به سرعت تصمیمگیری مجبور کند با عبارات مانند «همین حالا عمل کنید!» یا «امروز پاسخ دهید»، این یک علامت هشدار است. مجرمان نمیخواهند شما متوقف شوید و فکر کنید.

نشانههای هشدار ایمیل فیشینگ همانند گذشته هستند؛ اما ممکن است اکنون که تقریباً هر کسی میتواند مجرم شود، بیشتر با آنها مواجه شوید.

بدافزارهای توسعهیافته توسط هوش مصنوعی اکنون وجود دارند

مدتی بود که ایده بدافزارهای توسعهیافته توسط هوش مصنوعی و کمپینهای فیشینگ صرفاً یک خیال بود. ابزارهای هوش مصنوعی آنقدر قدرتمند نبودند که بتوانند چیزی بهطور قابل توجه خطرناک خلق کنند و آنچه میتوانستند انجام دهند، با تهدیدهای موجود تفاوت چندانی نداشت.

این وضعیت در طول سال ۲۰۲۵ تغییر کرد و شاهد مشاهده مکرر بدافزارهای توسعهیافته توسط هوش مصنوعی در محیطهای واقعی و در کمپینهای فعال بودیم. در نوامبر ۲۰۲۵، Google’s Threat Intelligence Group reported درباره دو نوع مختلف بدافزار که با ابزارهای مختلف هوش مصنوعی توسعه یافته و در واقع برای دریافت دستورات از ابزارهای هوش مصنوعی تماس میگیرند، گزارش داد.

علاوه بر این، در آگوست ۲۰۲۵، سازنده هوش مصنوعی Anthropic متوجه شد که چتبات Claude آن بهعنوان بخشی از یک کمپین بدافزاری عظیم استفاده میشود، بهطوری که هوش مصنوعی برای طراحی و اجرای حملات به پلتفرم خود متصل شده بود.

آیا اینها حملات وباسکمینگ هستند؟ میگویم با توجه به پیچیدگی آنها، اینها کمی جزئیات بیشتری نسبت به وباسکمینگ دارند، اما نشان میدهند که چقدر آسان است که هوش مصنوعی برای کارهای بسیار خطرناک بهکار گرفته شود. این ابزارها عمومی هستند. تصور کنید که در مورد ابزارهای محلی قدرتمند هوش مصنوعی که میتوانند محافظهایشان را حذف کنند، چه میشود.