اگر بهتازگی در هوش مصنوعی محلی آزمایش میکنید، در واقع دیگر نیازی به کارت گرافیک RTX ضخیم برای کار با هوش مصنوعی ندارید—و آرزو میکنم کسی زودتر این را به من گفته بود. مدتها فکر میکردم اجرای مدلهای هوش مصنوعی محلی به یک GPU قدرتمند، اعتبارهای ابری یا هر دوی آنها نیاز دارد.

اگر به هوش مصنوعی محلی سر زدهاید، در واقع دیگر نیازی به کارت RTX حجیم برای بازی با هوش مصنوعی ندارید—و کاش کسی زودتر این را به من میگفت.

هر کسی میتواند از مزایای یک LLM محلی با برنامههای رایگان بهرهمند شود، اما مدلها مفهوم کاملاً دیگری هستند. سپس مدلهای کوانتیزهشده را کشف کردم و ناگهان لپتاپ گیمینگ من برای اجرای دستیارهای شگفتانگیز بهطور محلی کافی شد، بدون اشتراکهای هزینهبر و بدون خروج دادهها از دستگاه.

آیا واقعاً برای اجرای هوش مصنوعی به یک GPU قدرتمند نیاز دارید؟

تفاوت بین آموزش و استنتاج

اکثریت ما این روایت را جذب کردهایم: اگر میخواهید مدلهای هوش مصنوعی مدرن را اجرا کنید، یا هزینهای برای دسترسی به ابر میپردازید یا پول قابل توجهی برای یک GPU با قابلیت بالا هزینه میکنید. این ایده کاملاً تصادفی نیست—مدلهای بزرگ با دقت کامل به مقدار زیادی VRAM نیاز دارند—اما برای بیشتر موارد عملی قدیمی شده است.

آنچه تغییر کرده این است که مدلها کوچکتر و کارآمدتر شدهاند بدون اینکه به اسباببازی بیفایده تبدیل شوند، و نرمافزارهای مرتبط نیز پیشرفت کردهاند. اکنون میتوانید مدلهای واقعاً مفید در بازه ۱ تا ۹ میلیارد پارامتر که برای لپتاپها و دسکتاپها طراحی شدهاند، نه برای سختافزارهای دیتاسنتر، به دست آورید.

کوانتیزیشن این را حتی بیشتر پیش میبرد با کاهش حافظه این مدلها با تأثیر شگفتانگیزی کم بر کیفیت برای کارهای روزمره مانند نوشتن پیشنویس، کمک به کدنویسی و یادداشتبرداری. وقتی معماری کوچکتر و هوشمندانه را با کوانتیزیشن خوب ترکیب میکنید، مانع ورود از یک ایستگاه کاری گیمینگ به یک CPU مناسب و RAM کافی کاهش مییابد. دستگاهی که از قبل دارید بهطور ناگهانی تبدیل به یک جعبه هوش مصنوعی کاملاً کارا میشود.

|

مدل |

اندازه (پارامترها) |

مناسب برای |

حافظه RAM معمولی با کوانتیزیشن 4‑بیتی |

یادداشتها |

|---|---|---|---|---|

|

Phi‑3.5 Mini / Phi‑4 Mini |

~3.8B–4B |

چت عمومی، استدلال، قطعات کد |

حدود ۴ تا ۶ گیگابایت برای استفاده روان |

خط مدل کوچک مایکروسافت، طراحیشده برای سختافزارهای محدود و سناریوهای آفلاین. |

|

Llama 3.2 1B / 3B Instruct |

1B / 3B |

دستیارهای سبک، لپتاپهای با RAM کم |

حدود ۳ تا ۴ گیگابایت برای مدل 3B با 4‑بیت |

نسخههای قابل اجرا در هر جای متا، که بهطور گسترده بر روی لپتاپها با Ollama و GPT4All نمایش داده شدهاند. |

|

Qwen2.5‑7B Instruct |

7B |

دستیار عمومی، وظایف ساختاریافته، تحلیل سبک |

حدود ۵ تا ۸ گیگابایت در 4‑بیت |

اغلب بهعنوان مدل پیشفرض محلی برای کارهای روزانه توصیه میشود. |

|

GLM‑4‑9B |

9B |

استدلال قوی و وظایف چندزبانه |

حدود ۸ تا ۱۰ گیگابایت در 4‑بیت |

بهعنوان یک مدل کوچک‑اما جدی متعادل برای لپتاپها برجسته شده است. |

|

Gemma‑style 2B–4B models |

2B–4B |

چت، یادداشتبرداری، کمک ساده به کدنویسی |

حدود ۳ تا ۶ گیگابایت در 4‑بیت |

مدلهای کوچک پشتیبانیشده توسط گوگل که به راحتی بر روی دستگاههای مصرفکننده اجرا میشوند. |

بهخاطر داشته باشید این اعداد محدودیتهای سخت نیستند. اگر RAM کافی (۱۶ گیگابایت یا بیشتر) داشته باشید، یک مدل ۳ تا ۷ میلیارد پارامتر در ۴‑بیت کاملاً قابل استفاده است. حافظه ۳۲ گیگابایت یا بیشتر، درب ورود به مدلهای ۷ تا ۹ میلیارد پارامتر را بدون مشکل باز میکند.

کوانتیزیشن دقیقاً چه کاری انجام میدهد

کاهش اندازه مدل بدون خراب کردن آن

در پشت صحنه، یک مدل زبانی فقط یک انبار عظیم از اعداد به نام وزنها است. بهصورت سنتی، این اعداد در قالبهای نقطه شناور ۱۶ یا ۳۲ بیتی ذخیره میشوند که برای دقت عالی است اما مصرف حافظهاش فجیع است. اگر هر وزن عددی با دقت بالایی باشد و شما میلیاردها آن داشته باشید، فایلهای مدل به چندین گیگابایت میرسند و نیاز به VRAM یا RAM حجیم دارند.

کوانتیزیشن بر پایه یک سؤال ساده است: آیا واقعاً برای هر وزن به اینقدر دقت نیاز دارید؟ بهجای ذخیره هر عدد با ۱۶ بیت، میتوانید آن را با ۸ بیت یا حتی ۴ بیت ذخیره کنید. این کار بهتنهایی میتواند اندازه مدل را تا نصف یا حتی ۷۵٪ کاهش دهد نسبت به قالبهای با دقت بالاتر.

نکته هوشمند این است که روشهای مدرن کوانتیزیشن فقط بهصورت ساده همه چیز را گرد نمیکنند؛ آنها ترفندهایی مثل دقت ترکیبی، مقیاسبندی کانال‑به‑کانال و کالیبراسیون دقیق را ترکیب میکنند تا مدل بیشتر رفتار اصلی خود را حفظ کند. در بنچمارکها و ارزیابیها، نسخههای خوب تنظیمشدهٔ ۴‑بیتی و ۸‑بیتی اغلب بهطور شگفتآوری به مدلهای دقیق‑تمام نزدیک میمانند، در حالی که بهمراتب سبکتر برای اجرا هستند.

بهصورت عملی، این به این معناست که مدل کوانتیزهشدهٔ شما هنوز میتواند نظرات کد خوب بنویسد، مفاهیم را توضیح دهد و ایمیلها را پیشنویس کند، ولی اکنون بهراحتی روی دیسک و در حافظه قرار میگیرد. بهجای نیاز به GPU با VRAM بزرگ، میتواند در RAM سیستم یک دسکتاپ یا لپتاپ معمولی قرار گیرد و با سرعت تعاملی پاسخ دهد.

بله، میتوانید این مدلها را روی CPU اجرا کنید

وجود GPU خوب است، اما الزامی نیست

اگر انتظارات شما معقول باشد، حتی نیازی به GPU ندارید. با کتابخانهها و بکاندهای استنتاج نسل فعلی، میتوانید مدلهای کوانتیزهشده را کاملاً روی CPU اجرا کنید، بهشرطی که پردازنده چندهستهای مدرن و مقدار معقولی RAM داشته باشید. یک CPU دسکتاپ یا لپتاپ چهار تا هشت هستهای همراه با ۱۶ گیگابایت RAM برای شروع با مدلهای کوچک کافی است. RAM بیشتر، مانند ۳۲ گیگابایت یا بالاتر، فضای بیشتری برای آزمایش مدلهای بزرگتر فراهم میکند.

این ابزارها بهطور قابلتوجهی به بهینهسازیهای سطح پایین وابستهاند. آنها از دستورهای برداری، نگاشت حافظه کارآمد و پردازش چندنخی استفاده میکنند تا بیشترین عملکرد را از CPU شما استخراج کنند. نتیجه این است که یک مدل ۴‑بیتی یا ۸‑بیتی در بازه ۳ تا ۷ میلیارد پارامتر در یک ماشین معمولی بهخوبی قابل استفاده میشود. شاید برای پردازش دستهای بزرگ مناسب نباشد، اما برای پنجرهٔ چت تعاملی، کمکنویس، یا دستیار کدنویسی، زمان پاسخدهی کاملاً قابلقبول است بدون نیاز به GPU اختصاصی.

مدلهای کوانتیزهشده در واقع به چه کاری خوب هستند

نوشتن، خلاصهسازی و کمک به کدنویسی بهصورت محلی

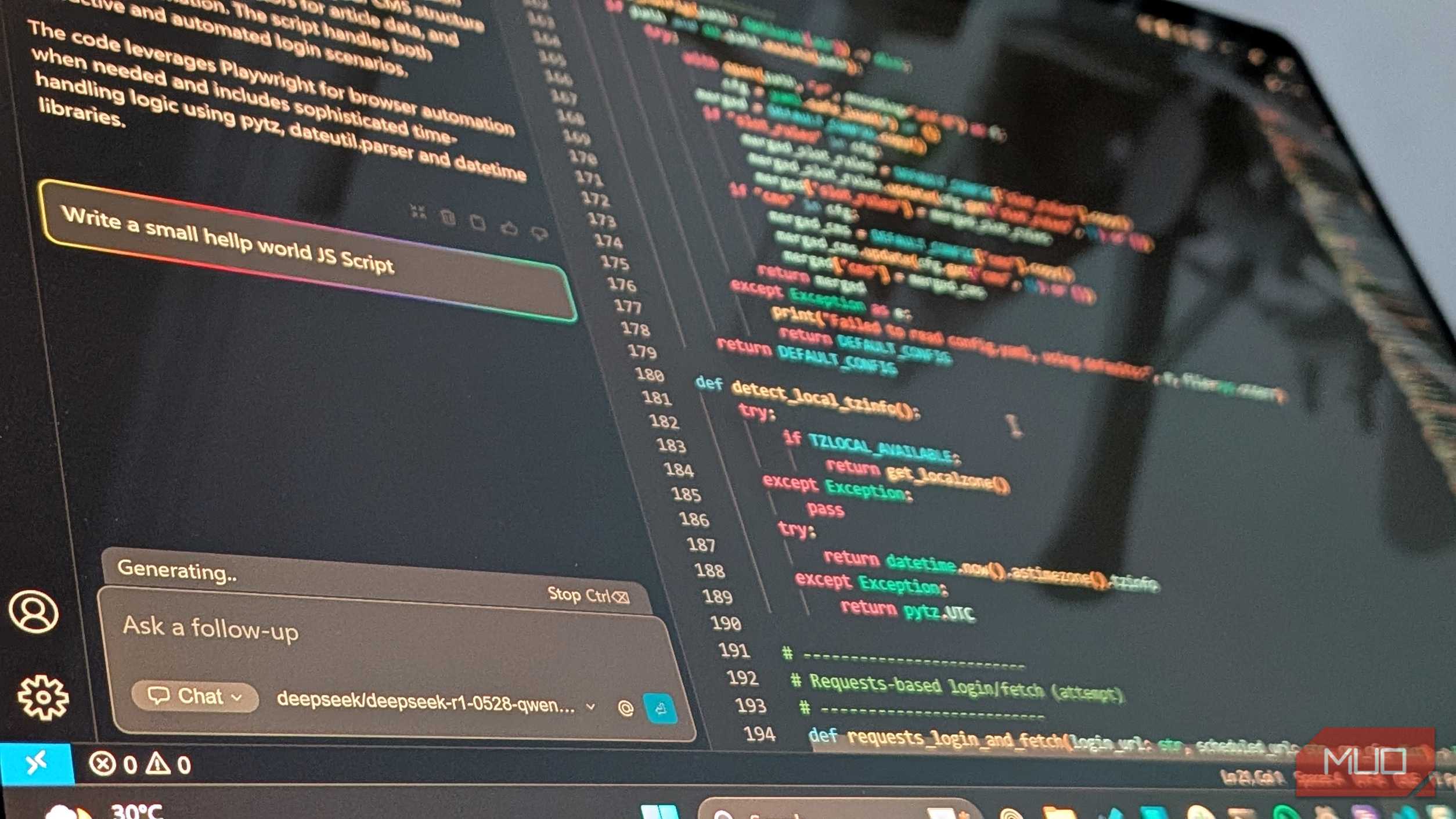

اگر به مدلهای ابری کلاس GPT‑4 عادت دارید، منطقی است بپرسید این مدلهای کوچکتر و کوانتیزهشده میتوانند چه کاری بهطور واقعی انجام دهند. پاسخ: بیش از آنچه انتظار دارید، بهویژه برای کارهای متمرکز و روزمره. در یک ماشین متوسط، هر چیز از نوشتن، کدنویسی تا استدلال عمومی میتواند بهراحتی مدیریت شود. میتواند بلاگها را طرحریزی کند، ایمیلها را پیشنویس کند، پاراگرافهای سنگین را بازنویسی کند و یادداشتها یا اسناد طولانی را خلاصه کند. همچنین میتواند خطاها را توضیح دهد، بازنگری توابع کوچک را پیشنهاد کند و کدها یا تنظیمات پایهای را تولید کند. با روشهای جالب برای استفاده از LLMهای محلی با ابزارهای MCP، آسمان حد و مرز نیست.

برای راهنماییهای عملی هوش مصنوعی محلی، در خبرنامه مشترک شوید

مدلهای کوچک اما هوشمند اخیر مانند Llama 3.2 1B و 3B Instruct مِتا، Phi‑3.5 Mini مایکروسافت، و انواع فشرده Qwen و Gemma بهصورت صریح برای درخشان بودن در این سناریوها طراحی شدهاند. آنها برای کارآمدی آموزشدیدهاند، نه صرفاً بزرگ بودن، بنابراین هنگام کوانتیزه شدن از وزن خود پیشی میگیرند. شاید برای تولید یک گزارش تحقیقاتی کامل با ارجاعهای زنده از آن استفاده نکنید، اما برای کارهای روزانه و طوفان فکری، حس میشود نزدیک به خواهران بزرگترشان هستند.

خب، آیا هنوز به GPU نیاز دارید؟

زمانی که GPU واقعاً منطقی است

اگر مدلهای بزرگ را از صفر آموزش میدهید، تنظیم دقیق معماریهای بزرگ در مقیاس یا سعی در استخراج تمام توان یک مدل پرچمدار دارید، آنگاه بله، یک GPU قدرتمند یا چندتا همچنان مهم هستند. این همان کاری است که GPUها در آن عالیاند. اما اگر هدف شما داشتن یک دستیار نوشتاری هوشمند، یک کمککننده کدنویسی که پروژه شما را درک کند، یا یک مدل چت خصوصی برای طوفان فکری، برنامهریزی و یادگیری باشد، شاید هنوز نیازی به خرید یک GPU پیشرفته نباشد.

نیازی نیست برای سختافزار گرانقیمت هزینه کنید تا هوش مصنوعی را روی کامپیوتر خود اجرا کنید.

یک مدل کوانتیزهشدهٔ بهخوبی انتخابشده که روی دستگاه موجود شما اجرا شود، میتواند بهشکلی شگفتانگیز پیش رود. تغییر ذهنی واقعی این است که بپذیریم هوش مصنوعی نیازی به زندگی در ابر یا در رک GPUها ندارد. با کوانتیزیشن و انتخاب مدل مناسب، تقریباً هر دستگاه نسبتاً مدرن میتواند مدلهای هوش مصنوعی را بهصورت محلی با سرعت معقول اجرا کند.