من مدتی است که با مدلهای بزرگ زبانی محلی (LLM) روی کامپیوترم آزمایش میکنم. همهاش بهعنوان یک سرگرمی شروع شد وقتی DeepSeek‑R1 را بهصورت محلی روی مکام اجرا کردم و اکنون بخش بسیار شگفتانگیزی از جریان کار من شده است.

من مدتی است که با مدلهای زبانی بزرگ محلی روی کامپیوترم سر و کار داشتهام. همهاش از یک سرگرمی شروع شد وقتی I ran DeepSeek-R1 locally on my Mac، و اکنون بخش بسیار شگفتانگیزی از جریان کار من شده است.

من تقریباً تمام برنامههای محبوب استنتاج هوش مصنوعی محلی روی اندروید را امتحان کردهام و عملکرد همیشه بزرگترین نکتهگیر بوده است. شما هماکنونی با محدودیتهای سختافزاری جدی کار میکنید زیرا، واضح است، این یک گوشی است. این باعث میشود که بخش نرمافزاری کاملاً حیاتی باشد. اینجا است که MNN Chat بهطور کامل موفق میشود.

MNN Chat یک برنامه منبع باز برای اندروید است که به شما اجازه میدهد مدلهای زبانی بزرگ را بهصورت کامل آفلاین بر روی گوشی خود اجرا کنید، با تمرکز بر سرعت، کارایی و استنتاج واقعی روی دستگاه.

MNN Chat بهترین برنامه LLM محلی است که تا به حال امتحان کردهام

کاش Ollama بر روی اندروید بود

نکته جالب اول درباره MNN Chat این است که در واقع یک پروژه منبع باز است که توسط Alibaba توسعه یافته است. موتور استنتاج خود بهطور خاص برای اجرای کارآمد LLMها بر روی سختافزارهای موبایلی ساخته شده، بدون حاشیههای پیچیده پردازندههای گرافیکی پیشرفته. حتی اگر این برنامه در Play Store موجود است، میتوانید کد آن را خودتان در صفحه GitHub آنها ببینید.

تا به حال بهترین عملکردی را که من تست کردهام برای اجرای مدلهای محلی روی اندروید دارد. اما پیش از شروع، باید چند نکته را بدانید. ابتدا، نیاز به گوشی نسبتاً قدرتمندی دارید. من تمام مدلهایم را بر روی Samsung Galaxy S24 Ultra با ۱۲ گیگابایت رم اجرا کردهام، که حتماً در رده بالای استانداردهای گوشی قرار میگیرد.

حتی با رباتهای چت مبتنی بر ابر، من همیشه از این دستیار هوش مصنوعی آفلاین که پیدا کردهام استفاده میکنم.

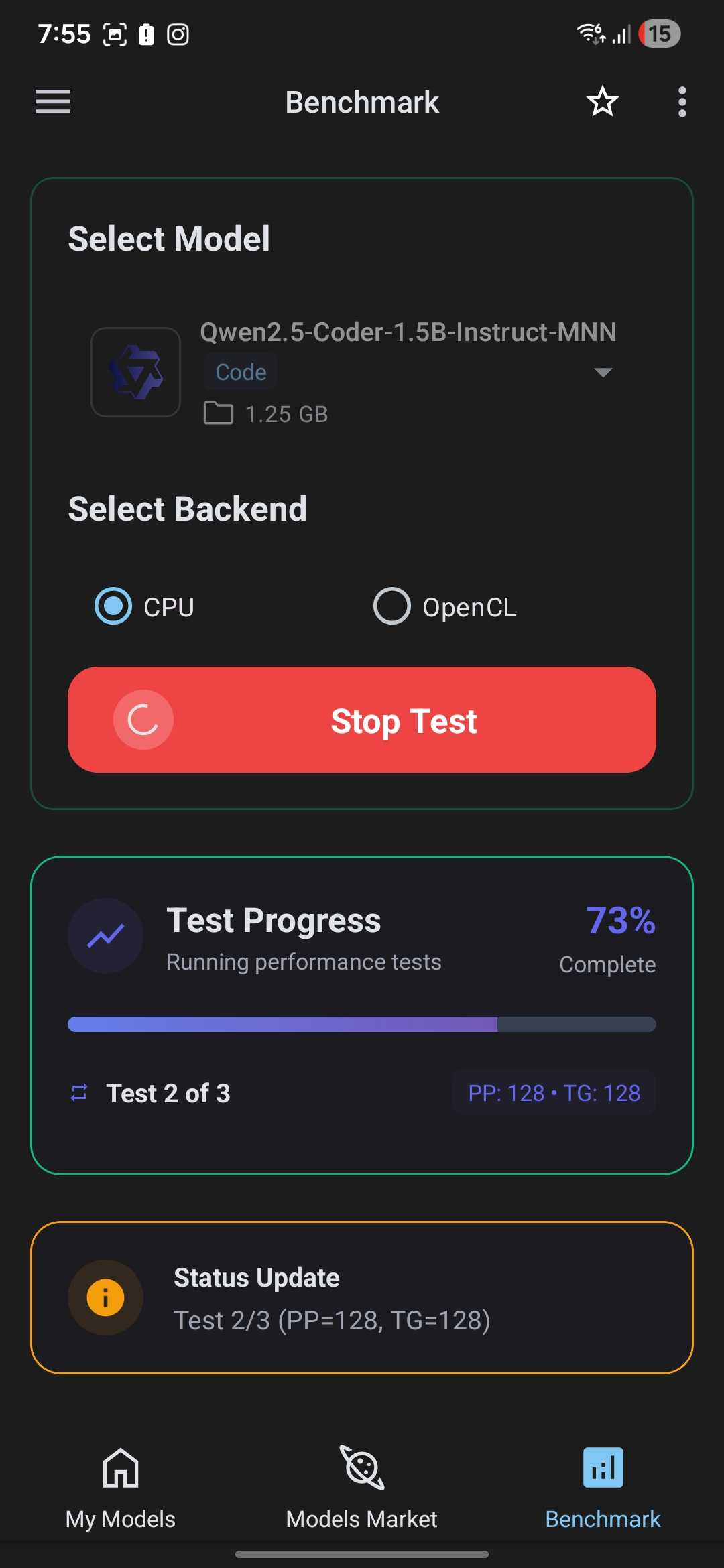

اگرچه، اگر میخواهید محدودیتها را تجربه کنید، هنوز هم توصیه میکنم حداقل ۸ گیگابایت رم آزاد داشته باشید تا تجربه قابل استفادهای با مدلهای کوچکتر داشته باشید. همچنین امکانات مفید دیگری دارد. اگر نمیدانید کدام مدل را اجرا کنید چون نمیدانید کدام یک کارآیی بیشتری دارد، یک حالت بنچمارک داخلی وجود دارد که به شما کمک میکند تصمیم بگیرید.

همچنین نیازی به جستجو در اینترنت برای یافتن مدلهای کارآمد ندارید. MNN Chat شامل یک گالری داخل برنامه است که میتوانید مدلها را بهصورت مستقیم بدون خروج از برنامه دریافت کنید.

شما یک آرسیان کامل از مدلها را دریافت میکنید، آماده استفاده

نیازی به دانلود مدلها بهصورت دستی ندارید

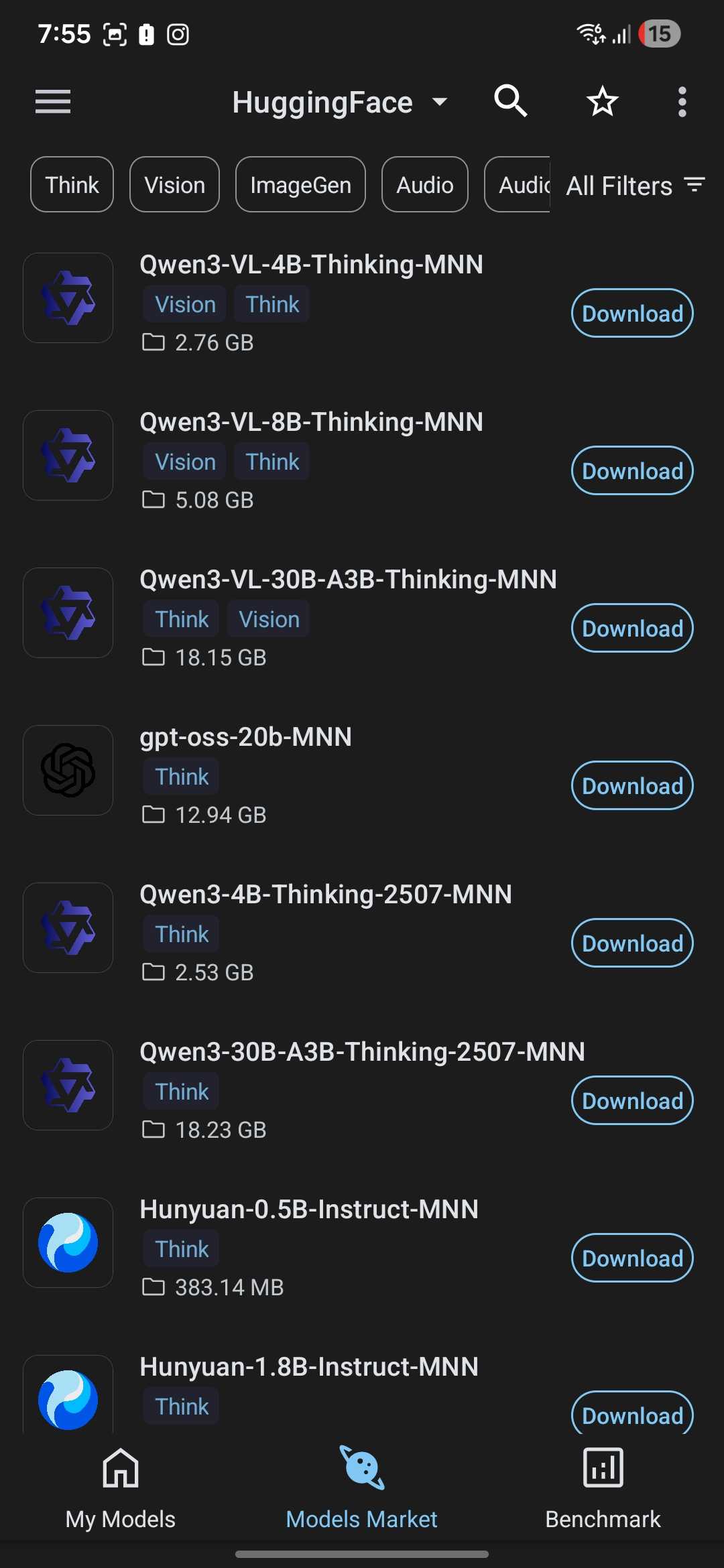

راهاندازی MNN Chat در واقع بسیار آسان است. تمام کاری که نیاز دارید باز کردن برنامه و رفتن به Models Market است. در اینجا، فهرست کاملی از مدلهای موجود را میبینید که میتوانید از طریق Hugging Face دانلود کنید. اگر Hugging Face را نمیشناسید، در واقع یکی از بزرگترین مخازن مدلهای هوش مصنوعی متنباز است.

در اینجا، کافی است روی دکمه دانلود کنار مدلی که میخواهید بزنید و بلافاصله پس از پایان دانلود آماده استفاده باشد. بخش سختتر در واقع تصمیمگیری درباره اینکه کدام را انتخاب کنید، است.

این مدلها میتوانند از چند صد مگابایت تا چند گیگابایت متغیر باشند. ارزش دارد که اطمینان حاصل کنید فضای ذخیرهسازی آزاد کافی دارید، بهویژه اگر قصد دانلود مدلهای بزرگتر یا نگهداری چندین مدل نصبشده را دارید.

در فهرست، نامهای آشنایی مانند Qwen، DeepSeek یا Llama را خواهید دید. یک نکتهای که بهسرعت متوجه میشوید این است که هر نام مدل شامل عددی بههمراه حرف B است، مثل gemma-7b.

حرف B نشاندهنده میلیاردها پارامتر است. بهصورت ساده، هرچه عدد بزرگتر باشد، مدل قدرتمندتر است، اما بههمینطور حافظه بیشتری مصرف میکند و روی گوشی کندتر اجرا میشود. برای اکثر تلفنهای میانرده یا پرچمدار، من پیشنهاد میکنم از مدلهایی با حداکثر ۴ میلیارد پارامتر استفاده کنید، اما این بهطور کامل به گوشی شما بستگی دارد. بر تجربه من، مدلهای Qwen بهطور کلی بهترین بودهاند و حتی چندرسانهای هستند.

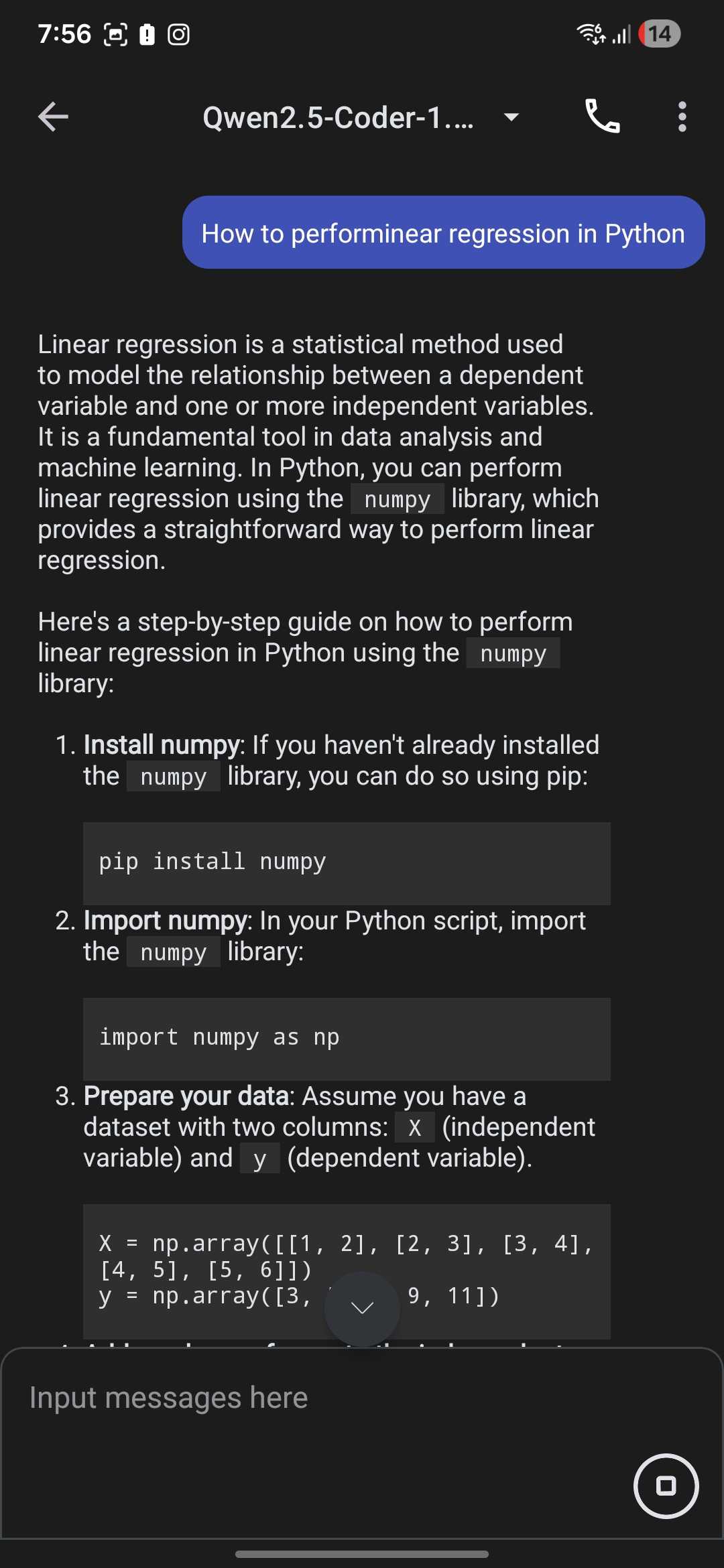

پس از دانلود، میتوانید به سادگی به My Models بروید و شروع به گفتوگو با آن کنید. حتی میتوانید اعلان سیستم را با کلیک روی منوی همبرگری در بالای راست و رفتن به Settings > System Prompt تغییر دهید.

همچنین میتوانید حداکثر تعداد توکنهای جدید را در اینجا تغییر دهید، که بهسادگی طول پاسخهای مدل را قبل از اینکه تولید متن را متوقف کند، تنظیم میکند.

بیش از صرفاً LLMها

تولید متن در سال 2025

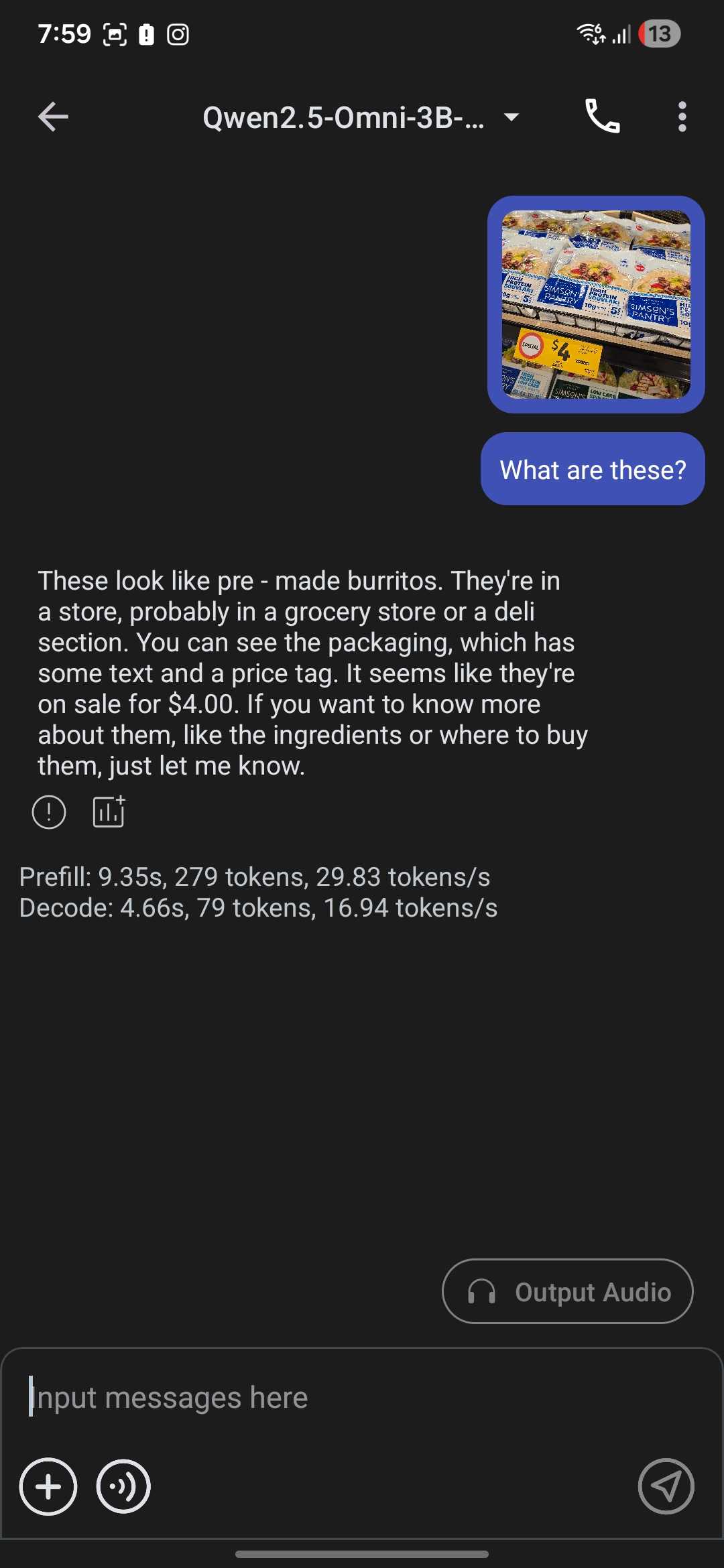

در داخل Models Market ممکن است متوجه شده باشید که چندین دسته برای تولید تصویر، صدا، ویدئو و موارد دیگر وجود دارد. این دقیقاً همان چیزی است که بهنظر میرسد. میتوانید مدلهایی را دانلود و اجرا کنید که بیش از تولید متن عمل میکنند، از جمله مدلهای چندرسانهای که میتوانند با تصاویر نیز کار کنند.

یک نکته خیلی جالبی که میتوانید با این کار انجام دهید این است که انواع مختلفی از مدلها را یکپارچه کنید تا چیزی شبیه به حالت صوتی ChatGPT به دست آورید. هنگام اجرای یک LLM، ممکن است متوجه شوید که یک آیکون تلفن در بالا سمت راست وجود دارد.

گزارش MUO: مشترک شوید و هرگز مهم را از دست ندهید

از اینجا باید یک مدل تبدیل متن به گفتار (TTS) دلخواه خود را دانلود کنید. همچنین به یک مدل ASR نیاز دارید که گفتار شما را به متن تبدیل کند. پس از آن، همه چیز آماده است و میتوانید با LLM محلی خود از طریق صوت صحبت کنید.

فقط بهخاطر داشته باشید که تمام این مدلها بهسرعت فضای زیادی را مصرف میکنند، همانطور که پیشتر اشاره کردیم. اگر میخواهید از مدلی استفاده کنید که در HuggingFace موجود نیست، میتوانید آن را خودتان از طریق ADB وارد کنید.

یادداشتهای من حالا پاسخ میدهند و بهطرز ترسناکی مفید هستند.

باید انتظارات خود را مدیریت کنید

بدون ذکر نیازی، واضح است که نباید کیفیت ChatGPT یا Gemini را انتظار داشته باشید، بهویژه برای چیزهایی مثل تولید تصویر. مزیت اصلی این است که میتوانید این مدلها را بهصورت محلی بدون هیچ اتصال اینترنتی اجرا کنید و دادههای شما روی دستگاه باقی میمانند. همچنین تعداد زیادی برنامهٔ متنباز محلی LLM که میتوانید برای بهتر کردن تجربهتان استفاده کنید نیز وجود دارد.

متأسفانه، اجرا کردن مدلهای عظیم بر روی چیزی بهسختی یک گوشی، امکانپذیر نیست. اما هنوز، میتوانید کارهای زیادی با این فناوری انجام دهید، حتی ساخت یک کلون Perplexity با LLMهای محلی.