استفاده از ابزارهای هوش مصنوعی مبتنی بر ابر میتواند ناراحتکننده باشد. از آنجا که من عمدتاً برای یادداشتبرداری از Obsidian استفاده میکنم، هر زمان که میخواستم از ChatGPT یا NotebookLM درباره موضوعی بپرسم، مجبور بودم یادداشتهایم را به یک پنجره جدا کپی کنم. پایگاه دانش شخصی من حس میکرد که از هوش مصنوعی که میتوانست به من در ترکیب آن کمک کند، قفل شده است. همچنین نگران این بودم که یادداشتهای خصوصیام به سرورهایی که تحت کنترل من نیستند، ارسال شوند. سپس MCP را کشف کردم و همه چیز تغییر کرد.

استفاده از ابزارهای هوش مصنوعی مبتنی بر ابر میتواند ناامیدکننده باشد. از آنجا که من عمدتاً از Obsidian برای یادداشتبرداری استفاده میکنم، هر زمان که میخواستم از ChatGPT یا NotebookLM دربارهٔ چیزی سؤال کنم، مجبور بودم یادداشتهایم را به یک پنجرهٔ جداگانه کپی کنم. پایگاه دانش شخصی من احساس میکرد که از هوش مصنوعی که میتوانست واقعاً به ترکیب آن کمک کند، دور مانده است. همچنین نگران این بودم که یادداشتهای خصوصیام به سرورهایی که تحت کنترل من نیستند ارسال شود. سپس MCP را کشف کردم و همه چیز تغییر کرد.

MCP مخفف Model Context Protocol است. این یک پروتکل عمومی برای اتصال مدلهای هوش مصنوعی به ابزارهای خارجی است، اما آنچه برای من تحولآفرین است این است که چقدر با Obsidian و LM Studio یکپارچه میشود. به جای کپی‑پیست، مدل هوش مصنوعی محلی من حالا میتواند بهصورت خودکار مخزن من را بخواند، جستجو کند و حتی به آن بنویسد. با استفاده از لایهٔ MCP همراه با ابزارهای محلی من، حالا همه چیز کاملاً رایگان است، تمام دادههایم در کامپیوتر من میمانند و هوش مصنوعی به صورت یکپارچه با یادداشتهایم کار میکند؛ چیزی که ابزارهای ابری هرگز نمیتوانند.

اینها کارهایی هستند که میتوانم با تنظیمات محلی Obsidian MCP انجام دهم

یکپارچهسازی مستقیم هوش مصنوعی با مخزن Obsidian

با تنظیمات محلی Obsidian MCP، ابزارهای من بهصورت یکپارچه تعامل میکنند. بهجای این که مخزن من را بهعنوان مجموعهای از فایلهای ایستا در نظر بگیرم، MCP آن را به چیزی تبدیل میکند که دستیار هوش مصنوعی من میتواند بهطور فعال با آن کار کند. این به من مجموعهٔ کامل ابزارهای مختص Obsidian میدهد که به مدل امکان میدهد یادداشتهایم را مستقیماً روی کامپیوتر بخواند، جستجو کند، ویرایش کند و سازماندهی نماید. همچنین، مزایای اجرای مدلهای زبانی آفلاین بر روی دستگاه شما نسبت به استفاده از یک API سرویس هوش مصنوعی پرداختی وجود دارد، مانند حریم خصوصی بهتر و استفادهٔ نامحدود رایگان.

تنظیمات من به من امکان میدهد محتوای هر فایلی را بهصورت آنی دریافت کنم، چه برای ارجاع به یک ایدهٔ قدیمی باشد و چه استخراج جزئیات از یک یادداشت پروژه. اگر بخواهم چندین یادداشت را همزمان جمعآوری کنم، میتوانم کل پوشهها را بهصورت دستهای بخوانم. میتوانم جستجوهای ساده یا پیچیده را هر زمان که نیاز به پیدا کردن چیزی عمیق در مخزن داشته باشم، اجرا کنم. همچنین میتوانم تغییرات اخیر را فهرست کنم، به یادداشتهای دورهای خود دسترسی داشته باشم، یا وقتی به یک نمای کلی از کارهایم نیاز دارم، تمام دایرکتوریها را مرور کنم.

برای کارهای پیچیدهتر مانند نوشتن و ویرایش، میتوانم استدلال مدل را روی High تنظیم کنم، که باید نتایج بهتری برای وظایفی که به درک بهتر زمینه و استدلال نیاز دارند، بهدست دهد. سپس میتوان نتایج را به Obsidian MCP ارسال کرد تا مستقیماً محتوای جدید را به یک یادداشت خاص در مخزن اضافه کند. تمام اینها بهصورت یکپارچه انجام میشود بدون نیاز به تعویض پنجرهها، کپیکردن متن یا مدیریت دستی فایلها. مدل زبان محلی من میتواند بهصورت مستقیم با مخزن تعامل داشته باشد.

در حالی که میتوان از Retrieval‑Augmented Generation (RAG) بهعنوان یک روش سادهتر و سریعتر برای اتصال مخزن Obsidian به مدل زبان محلی شما استفاده کرد، اما این روش تنها به بازیابی دادهها محدود میشود. این کار مفید است اگر فقط نیاز داشته باشید زمینهای به مدل زبان خود از یادداشتها بدهید، اما اگر میخواهید مدلتان بهصورت مستقیم با مخزن Obsidian تعامل داشته باشد، به لایهٔ MCP نیاز خواهید داشت.

راهاندازی آن بهطور شگفتانگیزی ساده بود

فقط چند دقیقه طول کشید!

عبارت MCP ممکن است در ابتدا ترسناک بهنظر برسد، اما فرآیند واقعی راهاندازی آن در واقع بسیار ساده است. فقط نیاز دارید چند ابزار نصب کنید، آنها را بههم وصل کنید و همه چیز بهراحتی کار خواهد کرد.

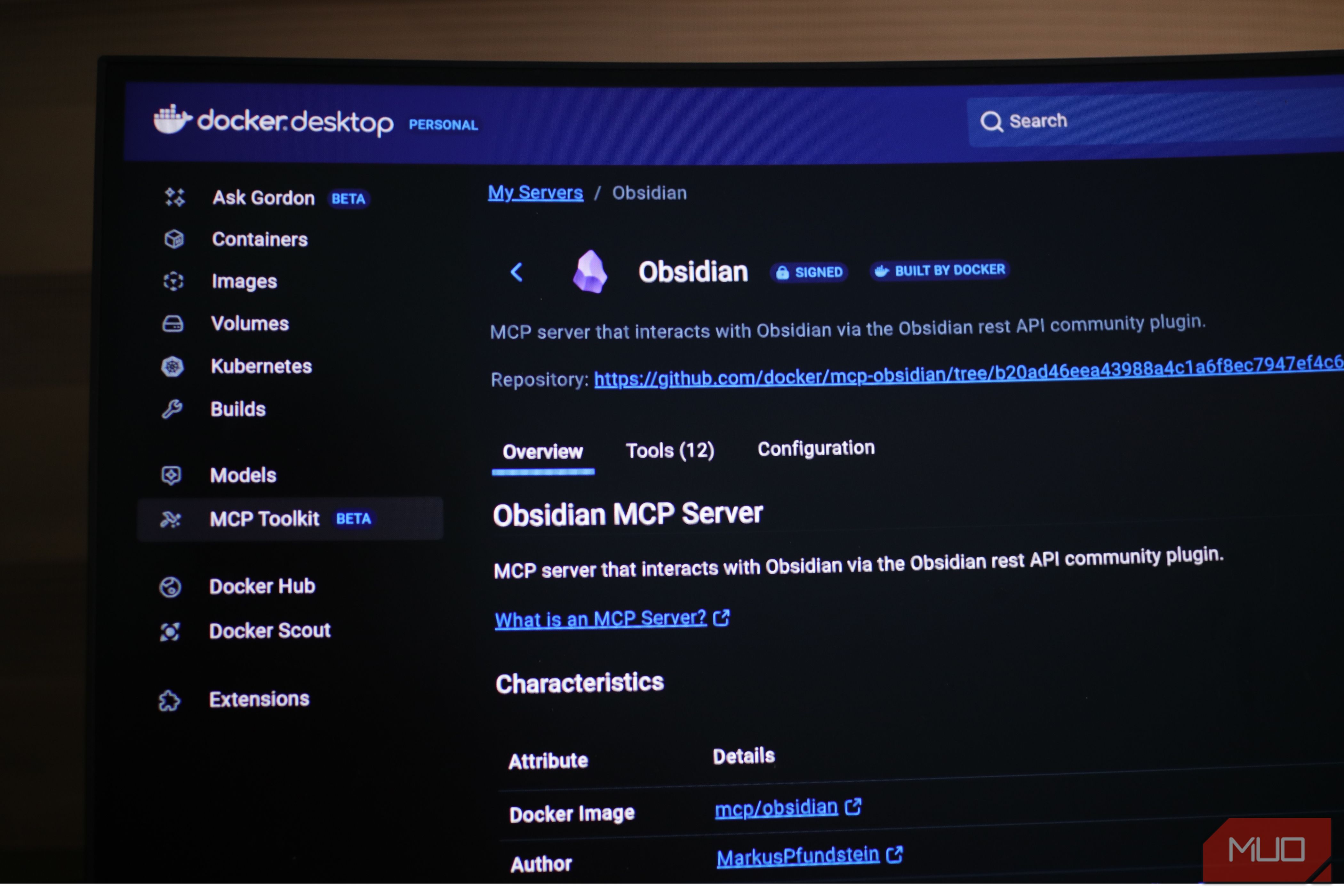

ابتدا Docker Desktop را بر روی رایانهٔ خود از سایت رسمی نصب کنید. Docker زیرساخت پشتیبانی را مدیریت میکند، بنابراین نیازی به مدیریت سرورها یا پیکربندیهای پیچیده ندارید. سپس، سرور Obsidian MCP را داخل Docker از بخش MCP Toolkit نصب کنید.

Obsidian MCP از شما کلید API Obsidian را میخواهد. برای دریافت API، باید Obsidian را باز کنید و افزونهٔ Local REST API را نصب کنید. این افزونه به ابزارهای خارجی اجازه میدهد بهصورت امن با مخزن شما ارتباط برقرار کنند. به Options بروید و کلید API Obsidian را از تنظیمات افزونه بگیرید، آن را در فیلد Obsidian MCP API وارد کنید و روی بررسی (check) کلیک کنید.

حال زمان اتصال مدل زبان محلی به MCP فرا رسیده است. LM Studio را از سایت رسمی دانلود نصب کنید و مدل هوش مصنوعی مورد علاقهتان را از داخل برنامه بارگیری کنید. سپس به MCP Toolkit داخل Docker بازگردید، روی Clients کلیک کنید و LM Studio را دانلود کنید. این کار بهصورت خودکار Obsidian MCP را به LM Studio متصل میکند.

برای شروع استفاده از این تنظیمات، LM Studio را اجرا کنید و یک مدل هوش مصنوعی را در تب Developer میزبانی کنید. پس از راهاندازی، به تب Chat بروید، روی آیکون پلاگ در پایین جعبهٔ درخواست کلیک کنید و mcp/mcp-docker را فعال کنید. اکنون تعاملات چت شما باید مستقیماً به مخزن Obsidian شما متصل شود!

در حالی که اکثر مدلهای چت باید با این تنظیمات کار کنند، من متوجه شدم که مدلهای کوچک 8B قادر به درک ایدهٔ تعامل مستقیم با MCP نیستند و اغلب به جای انجام کار، دستورالعمل میدهند. در آزمایشهای من، مدلهایی با قابلیت استدلال، مانند مدل OpenAI/gpt‑oss‑20b، توانستند از طریق سرور MCP با مخزن Obsidian من تعامل داشته باشند. بنابراین، توصیه میکنم هنگام اولین آزمایش این تنظیمات، از openai/gpt‑oss‑20b استفاده کنید.

امروز آن را امتحان کنید

این را امتحان کنید. اگر قبلاً از Obsidian استفاده میکنید و یک رایانهٔ مناسب دارید، همهٔ آنچه برای شروع نیاز دارید را دارید. فرآیند راهاندازی فقط چند دقیقه طول میکشد و پس از اجرا، بلافاصله متوجه تفاوت حس آن نسبت به ابزارهای هوش مصنوعی ابری میشوید. هوش مصنوعیای که واقعاً مخزن شما را میفهمد چون مستقیماً داخل آن کار میکند؛ حریم خصوصی شما برگردانده میشود و کنترل واقعی بر ابزارهای خود دارید. این ترکیب زمان را صرفهجویی میکند و جریان کاری شما را روانتر و شخصیتر میکند. امروز راهاندازی کنید و ببینید چگونه روش کار با یادداشتهایتان را متحول میکند.