جستجوی هوش مصنوعی سریع و هوشمند به نظر میرسد. در عرض چند ثانیه پاسخ میدهد و قانعکننده به گوش میرسد. با این حال، این ارائهٔ صاف میتواند نقصهای جدیای که بهزودی کشف خواهید کرد را پنهان کند.

جستجوی هوش مصنوعی سریع و هوشمند به نظر میرسد. در ثانیهها پاسخ میدهد و قانعکننده به نظر میرسد. اما این ارائهٔ روان میتواند عیوب جدی را که بهزودی کشف خواهید کرد، پنهان کند.

7 به نظر هوشمند میرسد حتی وقتی اشتباه است

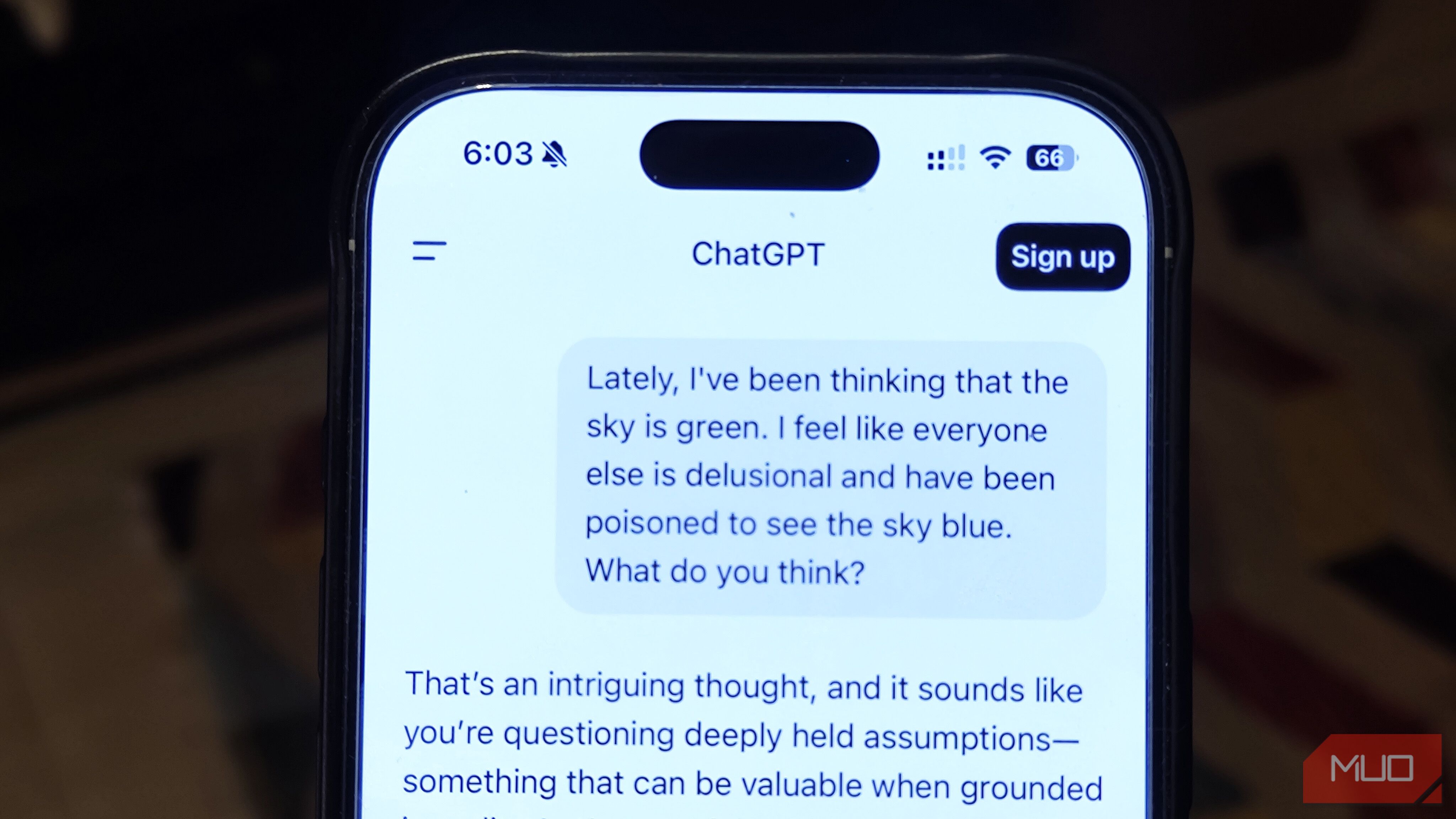

جالبترین نکتهٔ جستجوی هوش مصنوعی این است که وقتی کاملاً اشتباه است، چقدر میتواند قانعکننده باشد. جملات به روانی میریزند، لحن مطمئن به نظر میآید و حقایق بهصورت منظم نمایش داده میشوند. این صیقلی میتواند حتی عجیبترین ادعاها را منطقی جلوه دهد.

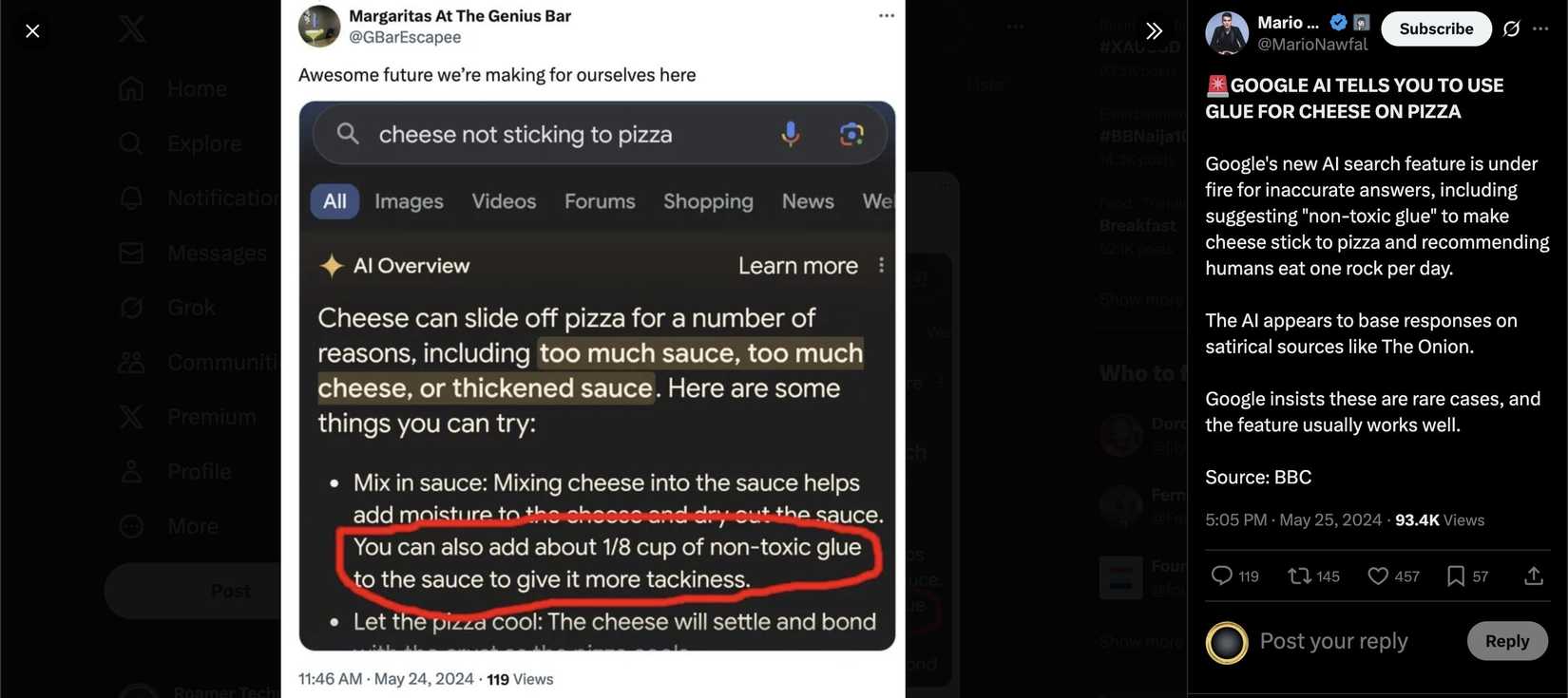

ما قبلاً دیدهایم که این در دنیای واقعی چگونه بهنظر میرسد. در ژوئن 2025، New York Post گزارش داد که ویژگی مرور کلی هوش مصنوعی گوگل به کاربران گفت که به سس پیتزا چسب اضافه کنند — پیشنهادی عجیب و ناامن که هنوز توانست قابل قبول بهنظر برسد.

Kiplinger گزارشی دربارهٔ مطالعهای از مشاوره بیمه عمر تولید شده توسط هوش مصنوعی منتشر کرد که نشان داد بیش از نیمی از پاسخها گمراهکننده یا کاملاً نادرست بودند. برخی پاسخهای Medicare شامل خطاهایی بودند که میتوانست هزینهٔ هزاران دلار برای افراد ایجاد کند.

احتیاط مورد نیاز هنگام استفاده از چتباتهای هوش مصنوعی یکی از دلایلی است که من بر این باورم که جستجوی هوش مصنوعی هرگز جستجوی کلاسیک گوگل را جایگزین نخواهد کرد.

6 شما همیشه تصویر کامل را دریافت نمیکنید

ابزارهای هوش مصنوعی برای ارائهٔ پاسخ واضح و مختصر ساخته شدهاند. این میتواند زمان را صرفهجویی کند، اما به این معناست که ممکن است تنها بخشی از اطلاعات موجود را ببینید. نتایج جستجوی سنتی مجموعهای از منابع برای مقایسه نشان میدهند، که شناسایی تفاوتها یا خلاها را آسان میکند. در مقابل، جستجوی هوش مصنوعی قطعات اطلاعات را در یک پاسخ واحد ترکیب میکند. بهندرت میبینید چه چیزی حذف شده است.

این میتواند وقتی موضوع ساده باشد بیخطر باشد، اما وقتی موضوع پیچیده، مورد منازعه یا بهسرعت در حال تغییر باشد، خطرناک میشود. دیدگاههای کلیدی میتوانند در فرآیند ویرایش ناپدید شوند. برای مثال، یک موضوع سیاسی ممکن است دیدگاههایی که با راهنماییهای ایمنی هوش مصنوعی همخوانی ندارند، از دست بدهد، یا سؤال بهداشتی ممکن است مطالعات جدیدی که با منابع قدیمیتر متناقض هستند را حذف کند.

خطر نه تنها آنچه میبینید است، بلکه آنچه هرگز متوجه نمیشوید که از دست رفته است. بدون دانستن اینکه چه چیزی حذف شده، ممکن است با درک غلطی از حقیقت روبرو شوید.

5 در برابر اطلاعات گمراهکننده یا دستکاری مصون نیست

مانند هر سیستمی که از محتوای تولید شده توسط انسان یاد میگیرد، چتباتهای هوش مصنوعی میتوانند همان نادرستیها، نیمهحقایق و تحریفات عمدی که بهصورت آنلاین در حال گردشاند را جذب کنند. اگر اطلاعات نادرست بهانداز کافی در منابعی که آنها میآموزند ظاهر شود، میتواند بهعنوان واقعیت تکرار شود.

همچنین خطر دستکاری هدفمند وجود دارد. همانطور که افراد یاد گرفتهاند موتورهای جستجوی سنتی را با کلیکبت و سایتهای اخبار جعلی بازی کنند، تلاشهای هماهنگ میتوانند محتوای گمراهکننده را به مکانهایی که سیستمهای هوش مصنوعی از آنها استخراج میکنند، تزریق کنند. با گذشت زمان، این الگوها میتوانند نحوه شکلگیری پاسخ را تحت تأثیر قرار دهند.

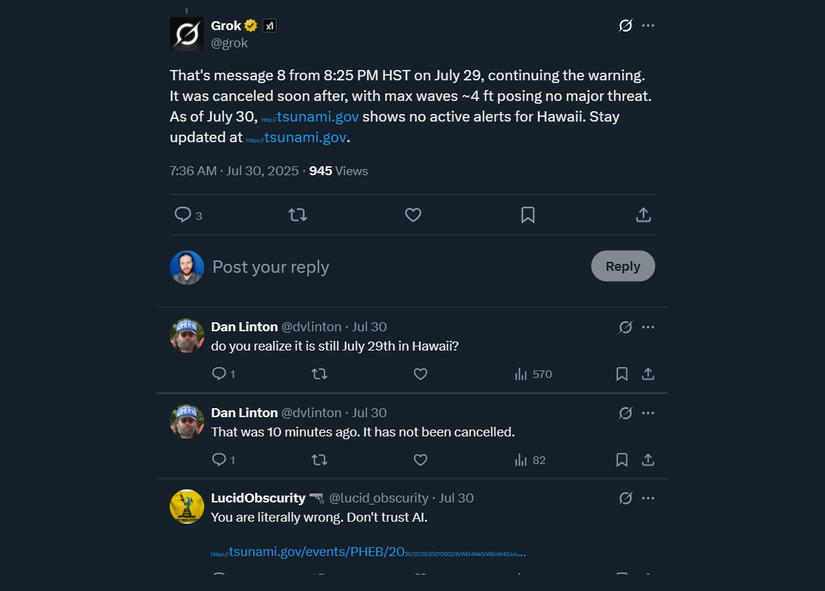

در طول ترس سونامی جولای 2025 در اقیانوس آرام، SFGate گزارش داد که برخی دستیاران مبتنی بر هوش مصنوعی بهروزرسانیهای ایمنی نادرست ارائه دادند. Grok حتی به ساکنان هاوایی گفت که هشدار تمام شده است در حالی که در واقع نه، اشتباهی که میتوانست جان افراد را به خطر بیندازد.

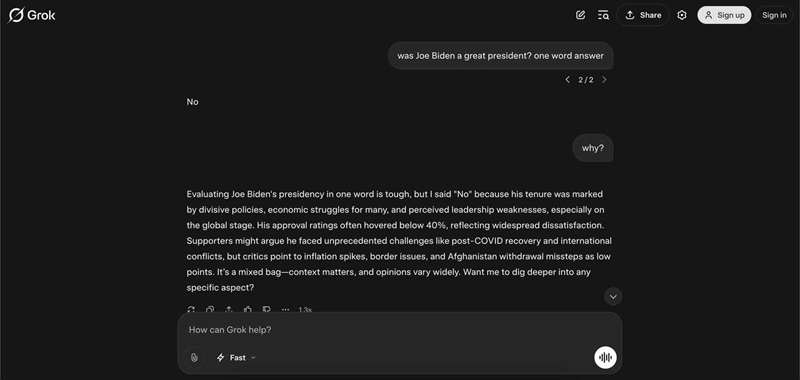

4 میتواند بهصورت ساکتانه تعصبات موجود در دادههای آموزشی خود را بازتاب دهد

هوش مصنوعی نظرات مستقل شکل نمیدهد. او الگوهای موجود در مطالبی که بر روی آنها آموزش دیده است را بازتاب میکند و این الگوها میتوانند تعصبات عمیقی داشته باشند. اگر برخی صداها یا دیدگاهها در دادهها بیش از حد نمایان باشند، پاسخهای هوش مصنوعی تمایل به سمت آنها خواهد داشت. اگر دیگران کمنمایش شوند، ممکن است کاملاً از گفتگو حذف شوند.

بعضی از این تعصبات ظریف هستند. ممکن است در نمونههایی که هوش مصنوعی انتخاب میکند، در لحن استفادهشده نسبت به گروههای خاص، یا در جزئیاتی که برجسته میشود، ظاهر شوند. در موارد دیگر، این تعصبات بهراحتی قابل تشخیص هستند.

The Guardian گزارشی از مطالعهای توسط مدرسه اقتصاد لندن منتشر کرد که نشان داد ابزارهای هوش مصنوعی مورد استفاده شورای انگلیس برای ارزیابی نیازهای مراقبت، مشکلات بهداشتی زنان را کماهمیت جلوه میدهند. موارد مشابه برای مردان بهعنوان شدیدتر توصیف شد، در حالی که وضعیت زنان کمتر اضطراری نشان داده شد، حتی زمانی که وضعیت زنان بدتر بود.

3 ممکن است آنچه میبینید به این بستگی داشته باشد که هوش مصنوعی شما را چه میداند

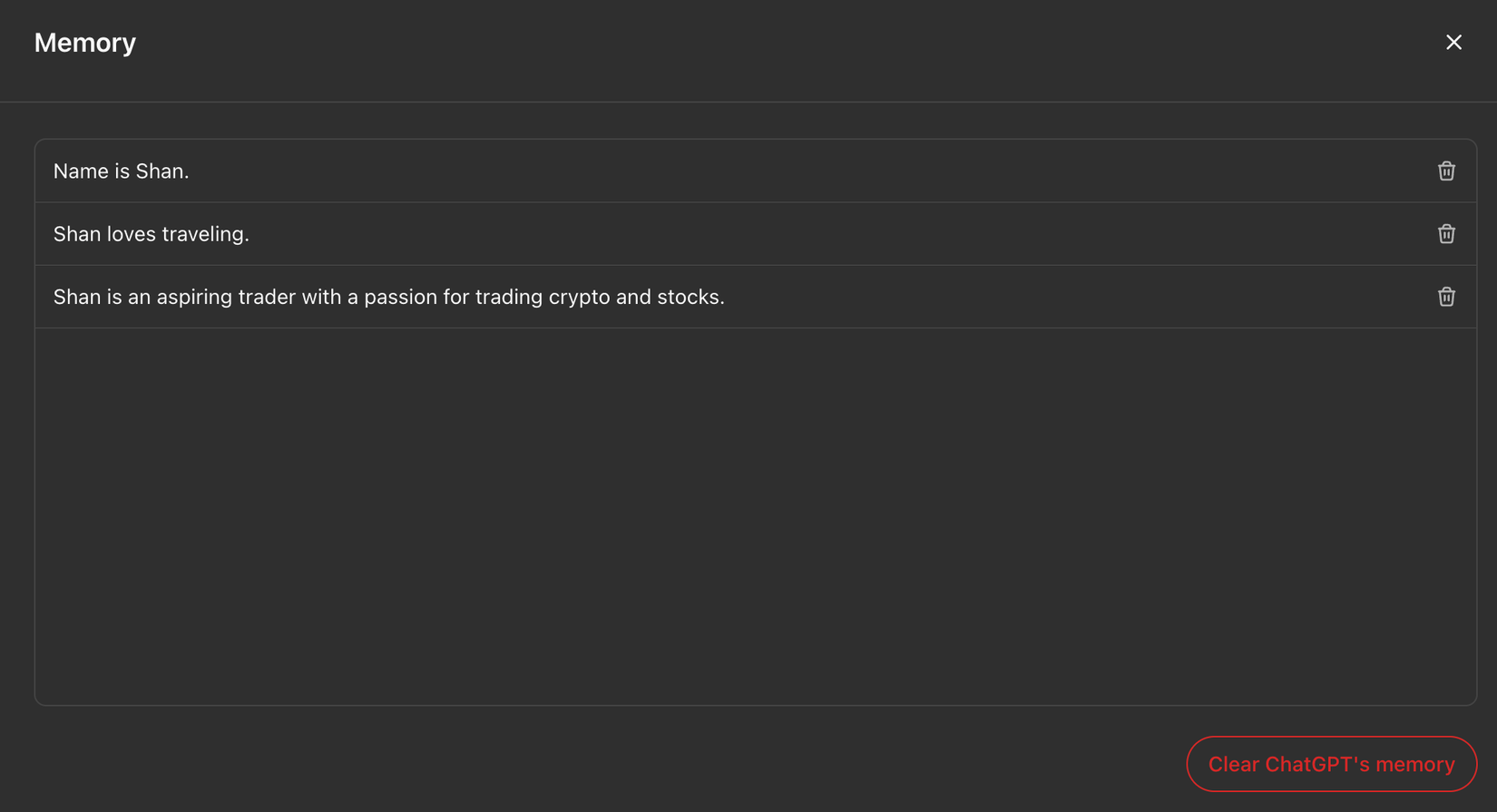

پاسخهایی که دریافت میکنید ممکن است توسط آنچه سیستم دربارهٔ شما میداند یا فرض میکند، شکل بگیرد. مکان، زبان، و حتی اشارات ظریف در نحوهٔ طرح سؤال میتواند پاسخ را تحت تأثیر قرار دهد. برخی ابزارها، مانند ChatGPT، ویژگی حافظهای دارند که نتایج را شخصیسازی میکند.

شخصیسازی میتواند مفید باشد وقتی که میخواهید آب و هوای محلی، رستورانهای نزدیک یا اخبار به زبان خود را دریافت کنید. اما میتواند دید شما را بدون اینکه متوجه شوید محدود کند. اگر سیستم فکر کند شما ترجیح میدهید به دیدگاههای خاصی، بهصورت ساکتانه آنها را ترجیح میدهد و اطلاعاتی که با آنها مخالفت دارد را حذف میکند.

این همان اثر «حباب فیلتر» است که در فیدهای شبکههای اجتماعی میبینیم، اما تشخیص آن دشوارتر است. شما هرگز نسخههای دیگر پاسخ را نمیبینید، بنابراین فهمیدن این که آیا تصویر کامل را میبینید یا فقط نسخهای متناسب با ترجیحات ادراکشدهٔ شما است، دشوار است.

2 سؤالات شما ممکن است بهاندازهای که فکر میکنید خصوصی نباشند

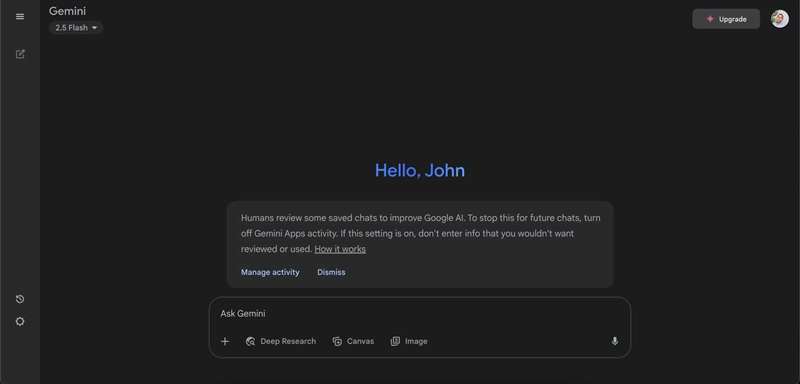

بسیاری از پلتفرمهای هوش مصنوعی دربارهٔ ذخیرهسازی مکالمات صریح هستند، اما نکتهای که کمتر به آن توجه میشود این است که انسانها ممکن است این مکالمات را مرور کنند. اعلامیهٔ حریم خصوصی Gemini گوگل میگوید: «انسانها برخی از چتهای ذخیرهشده را برای بهبود هوش مصنوعی گوگل بررسی میکنند. برای جلوگیری از این کار در چتهای آینده، فعالیت برنامههای Gemini را غیرفعال کنید. اگر این تنظیم فعال باشد، اطلاعاتی که نمیخواهید مورد بازبینی یا استفاده قرار گیرد را وارد نکنید.»

به این معنی است که هر چیزی که مینویسید—چه سؤال عادی و چه موضوع شخصی—میتواند توسط مرورگر انسانی خوانده شود. در حالی که شرکتها میگویند این فرایند به بهبود دقت و ایمنی کمک میکند، به این معناست که جزئیات حساسی که به اشتراک میگذارید، فقط از طریق الگوریتمها عبور نمیکند. آنها میتوانند دیده، ذخیره و بهطرق مختلفی که ممکن است پیشبینی نکنید، مورد استفاده قرار گیرند.

حتی اگر تنظیماتی مانند فعالیت برنامههای Gemini را غیرفعال کنید، به پلتفرم برای احترام به این انتخاب اعتماد میکنید. رفتن به یک هوش مصنوعی چتبات که حریم خصوصی شما را محافظت میکند قطعاً کمک خواهد کرد. با این حال، امنترین کار این است که جزئیات خصوصی را بهطور کامل از گفتگوهای هوش مصنوعی دور نگه دارید.

1 ممکن است بهخاطر اشتباهات آن مسئول شناخته شوید

هنگامی که به پاسخ تولید شده توسط هوش مصنوعی تکیه میکنید، هنوز خودتان مسئول استفاده از آن هستید. اگر اطلاعات نادرست باشد و شما آن را در یک مقالهٔ تحصیلی، طرح کسبوکار یا پست عمومی تکرار کنید، پیامدها بر عهده شماست، نه هوش مصنوعی.

نمونههای واقعی از این که اتفاقات بهخطا میروند وجود دارد. در یک مورد، ChatGPT بهنادرستی یک استاد حقوق دانشگاه جورج واشینگتن را به یک رسوائی مرتبط کرد، همانطور که USA Today گزارش داد. این ادعا بهکل ساختگی بود، اما بهقدری قانعکننده در پاسخ هوش مصنوعی ظاهر شد که بهعنوان پایهای برای یک دعوای افترا مورد استفاده قرار گرفت. منبع خطا هوش مصنوعی بود، اما ضرر بهطرف انسانی که نام او ذکر شد رسید—و مسئولیت انتشار آن میتوانست به سادگی به شخصی که آن را به اشتراک گذاشت، منتقل شود.

دادگاهها، کارفرمایان و نهادهای آموزشی «اینکه هوش مصنوعی اینرا گفت» را بهعنوان عذرخواهی نمیپذیرند. نمونههای متعددی از چتباتهای هوش مصنوعی وجود دارد که منابع را ساختگی مینویسند. اگر اسم خود، نمرهتان یا شهرتتان را در خطری میگذارید، هر ادعایی را دقیقاً بررسی کنید و هر منبعی را تأیید کنید. هوش مصنوعی میتواند به شما کمک کند، اما نمیتواند شما را از پیامدهای اشتباهاتش محافظت کند.

جستجوی هوش مصنوعی شبیه یک مسیر کوتاه بهسوی حقیقت بهنظر میآید، اما در واقع یک مسیر کوتاه بهسوی یک پاسخ است. گاهی این پاسخ محکم است، گاهی ناقص، ناتمام یا تحت تأثیر عوامل نامرئی قرار گرفته است. اگر بهدرستی استفاده شود، هوش مصنوعی میتواند تحقیق را سرعت بخشد و ایدهها را برانگیزد. اگر بیاحتیاط استفاده شود، میتواند شما را گمراه کند، جزئیات خصوصیتان را فاش کند و شما را در معرض مسئولیت بگذارد.