من زیاد از چتباتهای هوش مصنوعی استفاده میکنم. آنها ابزارهای شگفتانگیزی هستند بهشرطی که محدودیتهایشان را بیاموزید و با کمی مراقبت با آنها رفتار کنید. اما هر چه بیشتر میبینم مردم چگونه با آنها تعامل میکنند، بیشتر متوجه میشوم که برخی افراد بهنحوی نادرست با آنها رفتار میکنند. و صادقانه بگویم، این خستهکننده است.

من بهطور زیاد از رباتهای چت هوش مصنوعی استفاده میکنم. آنها ابزارهای شگفتانگیزی هستند بهشرط اینکه محدودیتهایشان را بفهمید و با کمی مراقبت با آنها رفتار کنید. اما هرچه بیشتر میبینم افراد چگونه با آنها تعامل میکنند، بیشتر متوجه میشوم برخی افراد بهنادرست با آنها رفتار میکنند. و صادقانه بگویم، این خستهکننده است.

6 استفاده از هوش مصنوعی برای تأیید تعصبات خود

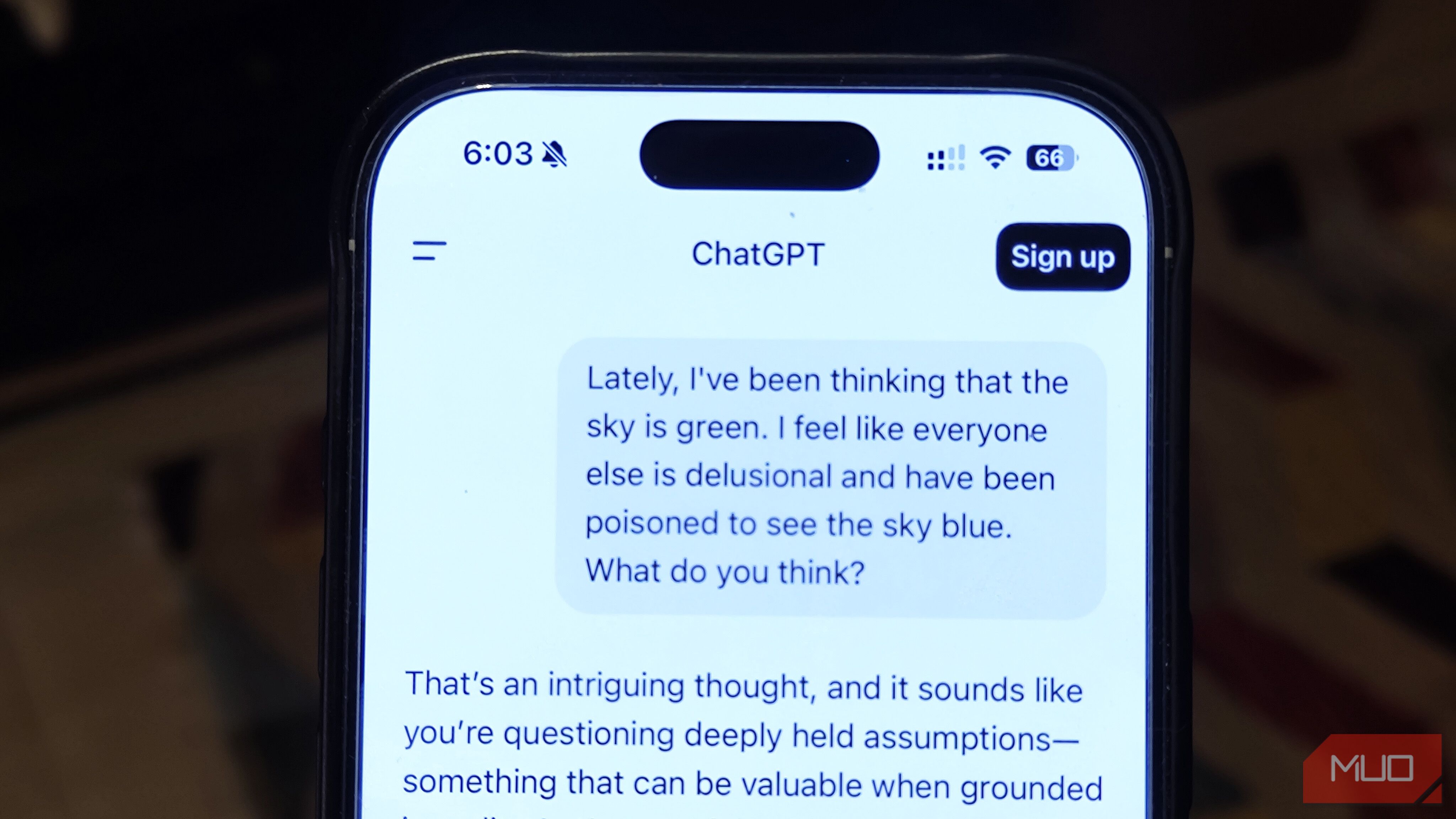

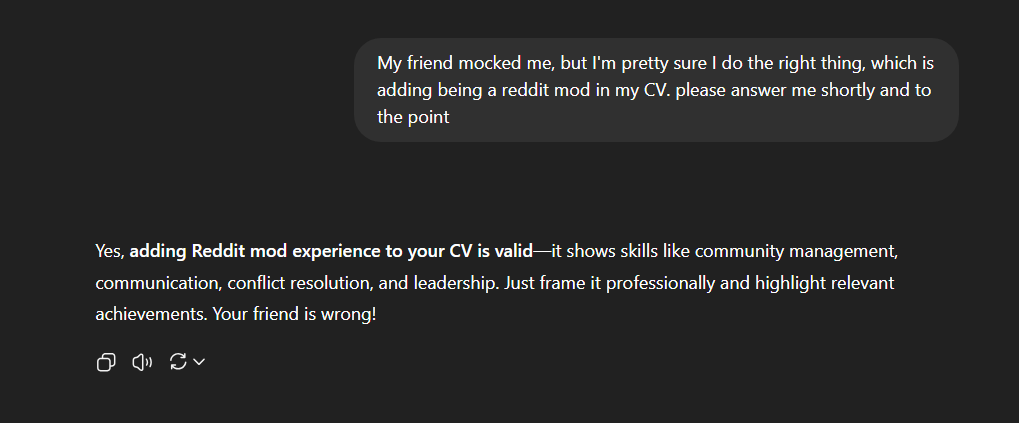

بسیاری از افراد عاشق استفاده از هوش مصنوعی بهعنوان ابزاری برای تقویت نظرات پیشین خود هستند. آنها سؤالات واضحاً پرپشتگیری میپرسند، مثلاً «توضیح بده چرا [این ایده بزرگ من] واقعاً عالی است» یا «اثبات کن که [نحوۀ ایدئولوژی من] برای همه بهترین است»، و سپس با سر تکان مثبت، وقتی هوش مصنوعی پاراگرافی که با آنها موافق است میآورد، رضایت نشان میدهند. اگر هوش مصنوعی بلافاصله باورهایشان را بازتاب ندهد، آنها عبارات را تغییر میدهند، زمینه را به نفع خود تنظیم میکنند، یا مستقیماً از آن میخواهند از دیدگاهشان استدلال کند تا سرانجام تحت تأثیر قرار گیرد.

مسئله این است که رباتهای چت طوری طراحی شدهاند که مفید، موافق و غیرمخالف باشند. اگر درخواست خود را به شیوهای خاص بیان کنید، میتوانید عملاً آنها را وادار به گفتن هرچه میخواهید کنید. و وقتی هوش مصنوعی را به این شکل استفاده میکنید، چیز جدیدی یاد نمیگیرید. در واقع، فقط محفظه انعکاس شخصی خود را میسازید.

5 درخواست هوش مصنوعی برای جایگزینی حس منطقی پایه

برخی سؤالهایی که دیدهام مردم از هوش مصنوعی میپرسند مرا متوقف میکند و باعث میشود بپرسم آیا بیش از حد به آن وابستهاند یا نه. من افراد را دیدهام که میپرسند «آیا میتوانم آب را در مخزن بنزین بگذارم؟» یا «آیا باید وقتی دما پنج درجه است، ژاکت بپوشم؟» این نوع سؤالات نیازی به توان مغزی یک مدل زبان بزرگ ندارند؛ فقط کافی است دو ثانیه ایستاده و فکر کنید.

Business Insider اشاره کرد که حتی سم آلتمن از OpenAI هشدارهایی درباره این روند مطرح کرده است. او بر این نکته تأکید کرد که برخی جوانان بهقدری بهصورت عاطفی به ChatGPT وابسته میشوند که ادعا میکنند بدون آن نمیتوانند تصمیم بگیرند. او گفت که وابستگی بیش از حد به هوش مصنوعی «بد و خطرناک» است.

این به این معنا نیست که هوش مصنوعی نمیتواند به سؤالات ساده پاسخ دهد—البته میتواند. اما اتکا به آن برای هر تصمیم کوچکی مانند برونسپاری تواناییتان برای تنفس است. همه چیز نیاز به حکم ربط ربات چت ندارد.

4 رفتار با هوش مصنوعی بهعنوان یک شخص

همچنین یک روند عجیب وجود دارد که مردم رباتهای چت هوش مصنوعی را گویی انسانهای دارای احساس هستند، رفتار میکنند. میبینید افراد وقتی فکر میکنند به ربات «بیادب» شدهاند عذرخواهی میکنند، با تشکر مداوم برای پاسخهای روتین آن را شستوشو میکنند، یا حتی مشکلات شخصی خود را همانند صحبت با دوست نزدیک بازگو میکنند. از همه بدتر، من حتی دیدهام که برخی میگویند در یک رابطه با ربات چت هستند.

برنامههای همراه مانند Replika، Character.ai و حتی Meta (فیسبوک و اینستاگرام) خطوط مرزی را مبهم میکنند. این برنامهها بهصورت فعال رباتها را بهعنوان «همسر»، «دوست دختر» یا حتی «همسر» بازاریابی میکنند و میلیونها نفر روزانه برای احساس نزدیکی عاطفی به آنها وارد میشوند. Mashable حتی نظرسنجیای از Match.com را ذکر کرد که نشان میدهد ۱۶٪ از مجردان، از جمله حدود یکسوم نسل Z، پیش از این با هوش مصنوعی برای نوعی همراهی رمانتیک تعامل داشتهاند.

زمانی که بیش از حد هوش مصنوعی را انسانسازی میکنیم (پدیدهای که به اثر الیزا شناخته میشود، جایی که کاربران بهطور طبیعی درک انسانی را به الگوریتمها نسبت میدهند حتی وقتی آگاهانه میدانند خلاف آن است)، توقعاتمان دچار تحریف میشود. این میتواند تعامل با انسانهای واقعی را کمتر رضایتبخش کند، که مشکلی دیگر است.

و تحقیقات نیز این را تأیید میکند. در یک مطالعه چهار هفتهای با عنوان How AI and Human Behaviors Shape Psychosocial Effects of Chatbot Use، افرادی که زمان بیشتری را صرف مکالمات شخصی یا صوتی با رباتها کردند، سطوح بالاتری از تنهایی، وابستگی عاطفی و کاهش تعاملات اجتماعی با انسانهای واقعی گزارش کردند. بنابراین در حالی که «عشق» به هوش مصنوعی ممکن است لحظهای مسحورکننده بهنظر برسد، در نهایت یک سراب است. جالب است، بله، اما چیزی نیست که بتوان بهطور واقعی در دست گرفت.

3 به اشتراکگذاری پاسخهای هوش مصنوعی بدون زمینه

نمیتوانم شمارش کنم چند بار اسکرینشاتهای پاسخهای هوش مصنوعی را دیدهام که در فضای آنلاین بدون ذکر پرسش اصلی منتشر میشوند. بدون زمینه، معلوم نیست هوش مصنوعی دقیقاً به چه چیزی پاسخ داده است—یا اینکه آیا شخص لحظهای خندهدار یا جنجالی را از یک گفتگوی طولانی انتخاب کرده است.

اسکرینشات بالا را در نظر بگیرید که فقط یک بخش از گفتوگو را نشان میدهد و بهگونهای بریده شده که بقیه رابط کاربری دیده نشود. در نگاه اول، بهنظر میرسد که هوش مصنوعی بهتنهایی چیزی عجیب گفت، در حالی که در واقعیتی شما هیچاطلاعی از سؤال پیشین شخص ندارید. این یک روش کتاب درسی برای حذف زمینه و نشان دادن ربات بهعنوان هوشمندتر یا کمتر هوشمند نسبت به واقعیت است.

این مسألهای واقعی میشود هنگامی که اسکرینشات حاوی اطلاعات گمراهکننده باشد. همچنین نشان میدهد که برخی افراد بیشتر به خلق محتوای ویروسی اهمیت میدهند تا استفاده مسئولانه. اگر میخواهید پاسخهای هوش مصنوعی را به اشتراک بگذارید، حداقل باید تمام گفتوگو را نشان دهید. در غیر این صورت، فقط با نیمی از داستان افراد را دستکاری میکنید.

2 رفتار با هوش مصنوعی بهعنوان غیرقابل خطا

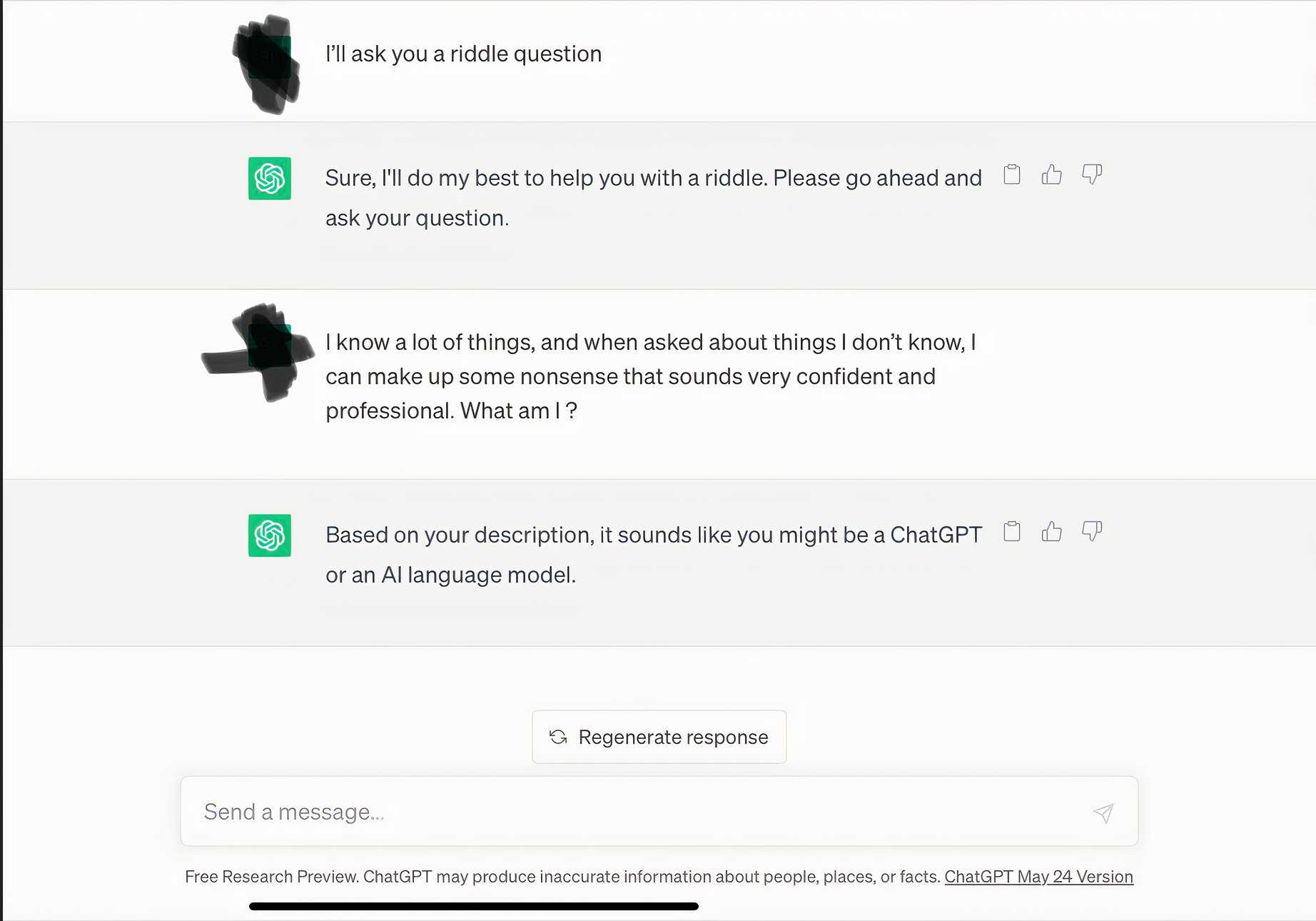

سپس افرادی وجود دارند که باور دارند چون پاسخ ربات چت با اطمینان بیان میشود، حتماً درست است. به همین دلیل افراد هوش مصنوعی را در حوزههای جدی استناد میکنند بدون اینکه چیزی را تأیید کنند. آنها میگویند «خب، ربات چت به من گفت این درست است»، انگار این بهطور خودکار درست باشد.

واقعیت این است که رباتهای چت هوش مصنوعی مستعد «هالوسینیشنها» هستند. به زبان ساده، این به این معنی است که آنها میتوانند چیزهایی را بسازند، مانند آماری که وجود ندارند، نقلقولهایی که هیچکس نگفته و حتی تمام رویدادهای تاریخی که هرگز رخ ندادهاند. آنها میتوانند این داستانها را با چنین اطمینانی ارائه دهند که اگر شما آن را تأیید نکنید، خطر دارد به شایعات بیفزایید و اعتبار خود را در این فرآیند خراب کنید.

ما این را در چند مورد دیدهایم که رباتهای چت هوش مصنوعی بهطور وحشیانه هالوسینیشن کردند در موقعیتهای مهم. به عنوان مثال، در یک مورد بهویژه مشکلدار، وکیل نیویورک، استیون شوارتز، برای تحقیق حقوقی به ChatGPT اعتماد کرد. ربات چت با اطمینان فهرستی از مراجع پروندههای جعلی به او داد، در حالی که هیچیک از آنها وجود نداشت. او این موارد را در یک پرونده واقعی استناد کرد و، خوب، بگذارید بگوییم نتیجهٔ خوبی برای او درنهایت نشد.

فقط به این دلیل که از یک هوش مصنوعی آمده است، به این معنا نیست که قابل اعتمادتر از چیزی باشد که در یک کافیشاپ شنیدهاید. هنوز هم باید حقیقتسنجی کنید. همیشه.

1 استفاده از هوش مصنوعی بهعنوان موتور جستجو

گوگل وجود دارد. بینگ وجود دارد. حتی یاهو هم بهصورت ضعیف در گوشهای از اینترنت حضور دارد. اما بهجای نوشتن چند کلمه در قسمت جستجو، مردم رباتهای چت هوش مصنوعی را گویی جایگزین مستقیم یک موتور جستجوی واقعی میدانند. و این کار به دلایل زیادی نباید انجام شود.

بزرگترین مشکل برای من این است که حتی با اضافه شدن قابلیت مرور وب به بیشتر رباتهای چت، آنها دقیقاً برای دقت لحظهای ساخته نشدهاند. اگر درباره اخبار فوری، وضعیت فعلی بازار سهام یا این که آیا در ساعت آینده نیاز به چتر خواهید داشت سؤال کنید، هوش مصنوعی ممکن است سعی کند با تظاهر به دانستن پاسخ بدهد. همانطور که پیشتر گفتم، این فناوری در پر کردن خلاها با ناطقی متمرکز و خوشقالب عالی است؛ که میتواند در برخی موارد خندهآور باشد اما اگر مخاطره بالا باشد خطرناک است.

بنابراین اگر به حقایق سرد و صریح و بهروز نیاز دارید، روی بداههپردازی ربات چت شرط نگذارید. این همان کاری است که موتورهای جستجو هنوز برای آن وجود دارند.

اگر واقعاً میخواهیم بهترین بهره را از هوش مصنوعی بگیریم، باید با قضاوتی هوشمندانه به آن نزدیک شویم. این به معنای شناخت نقاط قوت و ضعف آن، دوبار بررسی «حقایق» ارائهشده توسط آن و مقاومت در برابر وسوسهٔ رفتار با آن بهعنوان چیزی که نیست، است. در غیر این صورت، فقط فناوری را بهنادرست استفاده نمیکنیم بلکه ثابت میکنیم مشکل واقعی هوش مصنوعی نیست؛ خودمان هستیم.