اجرای یک مدل هوش مصنوعی بدون اتصال به اینترنت شگفتآور به نظر میرسد اما معمولاً به سختافزار قدرتمند و گرانقیمت نیاز دارد. اما همیشه اینطور نیست: مدل R1 شرکت DeepSeek گزینه مفیدی برای دستگاههای کمتوان است—و همچنین بهطور شگفتآوری آسان برای نصب است.

پیوندهای پرش

اجرای یک مدل هوش مصنوعی بدون اتصال به اینترنت بهنظر عالی میآید اما عموماً به سختافزار قدرتمند و گرانقیمت نیاز دارد. با این حال، همیشه اینطور نیست: مدل R1 دپسک DeepSeek گزینهی مفیدی برای دستگاههای کمقدرت است— و همچنین نصب آن بهسختی ساده است.

اجرا کردن یک چتبات هوش مصنوعی محلی به چه معناست؟

زمانی که از چتباتهای هوش مصنوعی آنلاین مانند ChatGP استفاده میکنید، درخواستهای شما روی سرورهای OpenAI پردازش میشود، به این معنی که دستگاه شما کار سنگین را انجام نمیدهد. برای ارتباط با چتباتهای هوش مصنوعی به اتصال اینترنتی ثابت نیاز دارید و هرگز کنترل کامل دادههای خود را ندارید. مدلهای بزرگ زبانی که چتباتهای هوش مصنوعی مانند ChatGPT، Gemini، Claude و غیره را پیشچال میکنند، بهدلیل وابستگی به GPUهای با حافظه VRAM زیاد، بهطور فوقالعادهای پرمصرف هستند. به همین دلیل اکثر مدلهای هوش مصنوعی مبتنی بر ابر هستند.

یک چتبات هوش مصنوعی محلی مستقیماً بر روی دستگاه شما نصب میشود، همانند هر نرمافزار دیگری. این به این معناست که برای استفاده از چتبات هوش مصنوعی به اتصال اینترنتی ثابت نیازی ندارید و میتوانید در هر زمان درخواست کنید. DeepSeek‑R1 یک LLM محلی است که میتواند بر روی بسیاری از دستگاهها نصب شود. مدل ۷B فشردهسازی شده (هفت میلیارد پارامتر) آن نسخه کوچکتر و بهینهسازیشدهای است که بر روی سختافزار میانرده به خوبی کار میکند و به من امکان میدهد پاسخهای هوش مصنوعی را بدون پردازش ابری تولید کنم. بهعبارت ساده، این به معنای پاسخهای سریعتر، حریم خصوصی بهتر و کنترل کامل بر دادههای من است.

چگونه DeepSeek-R1 را بر روی لپتاپ خود نصب کردم

اجرای DeepSeek‑R1 بر روی دستگاه شما نسبتاً ساده است، اما بهخاطر داشته باشید که از نسخهای کمقوتتر نسبت به چتبات وب‑محور DeepSeek استفاده میکنید. چتبات هوش مصنوعی DeepSeek حدود ۶۷۱ میلیارد پارامتر مصرف میکند، در حالی که DeepSeek‑R1 حدود ۷ میلیارد پارامتر دارد.

میتوانید DeepSeek‑R1 را بر روی کامپیوتر خود با پیروی از مراحل زیر دانلود و استفاده کنید:

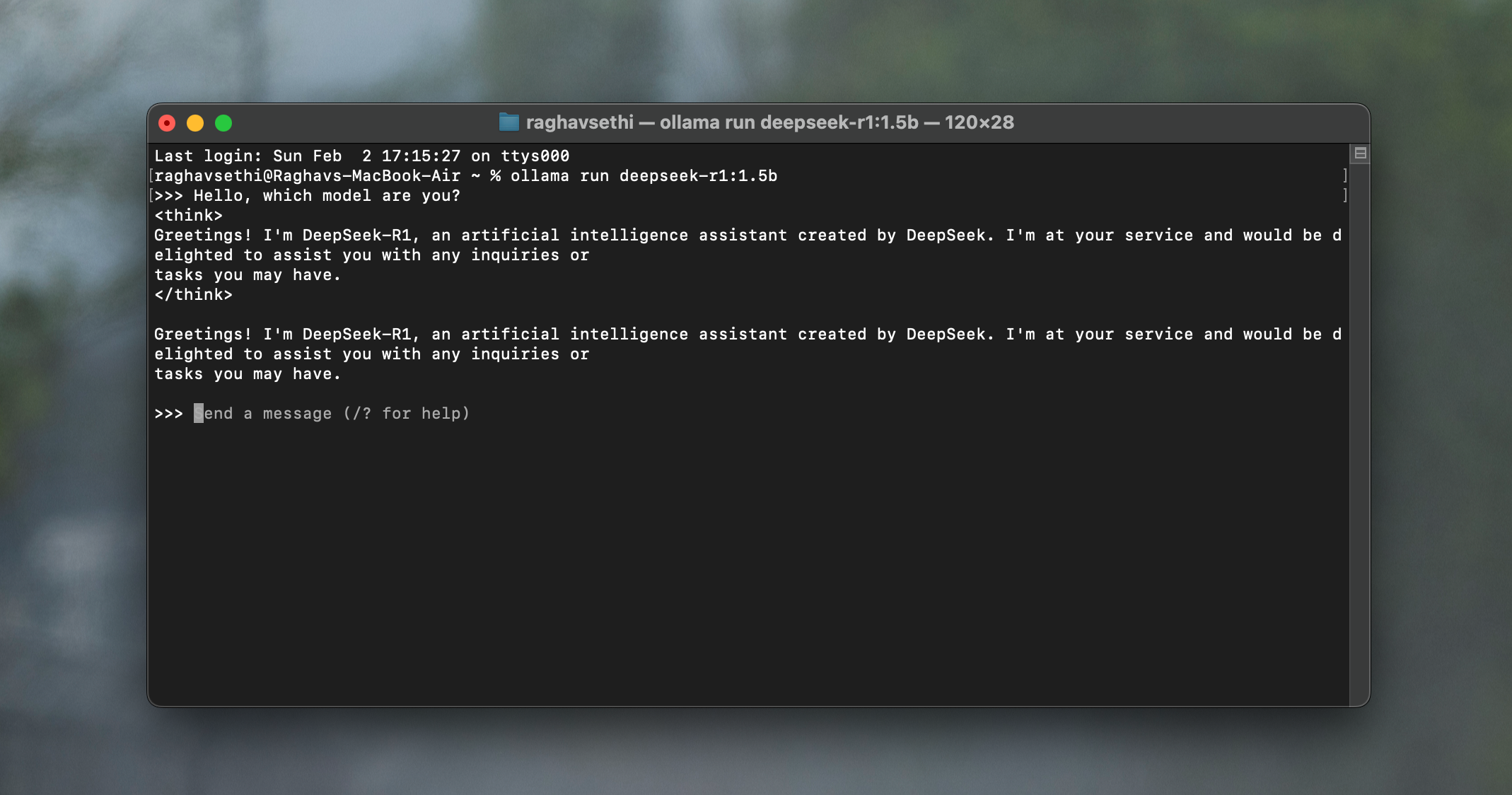

- به وبسایت Ollama بروید و آخرین نسخه را دانلود کنید. سپس، همانند سایر برنامهها آن را بر روی دستگاه خود نصب کنید.

- ترمینال را باز کنید و دستور زیر را تایپ کنید:

ollama run deepseek-r1:7b

ollama run deepseek-r1:7b

این کار مدل ۷B DeepSeek‑R1 را به کامپیوتر شما دانلود میکند و به شما امکان میدهد پرسشها را در ترمینال وارد کنید و پاسخها را دریافت کنید. اگر با مشکلات عملکرد یا کرش مواجه شدید، سعی کنید با جایگزینی ۷b با ۱.۵b در دستور فوق، از مدلی کممصرفتر استفاده کنید.

در حالی که مدل در ترمینال بهخوبی کار میکند، اگر به یک رابط کاربری کامل با قالببندی متن مناسب مانند ChatGPT نیاز دارید، میتوانید از برنامهای مانند Chatbox نیز استفاده کنید.

اجرا کردن DeepSeek بهصورت محلی کامل نیست—اما کار میکند

همانطور که قبلاً ذکر شد، پاسخها بهنظیر (یا بهسرعت) پاسخهای چتبات آنلاین DeepSeek نیستند زیرا از مدل قدرتمندتری استفاده میکنند و همه چیز را در ابر پردازش میشود. اما بیایید ببینیم مدلهای کوچکتر چقدر عملکرد دارند.

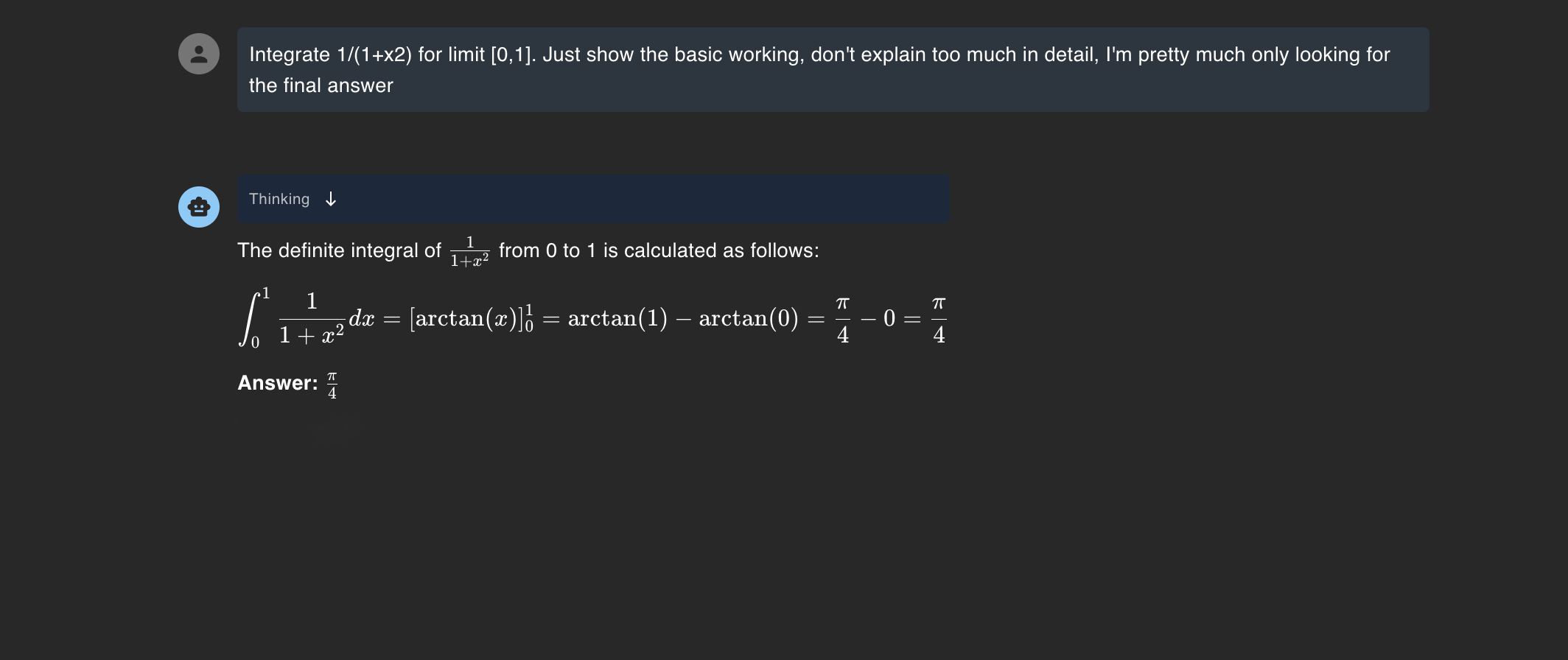

حل مسائل ریاضی

برای آزمایش عملکرد مدل ۷B، معادلهای به آن دادم و از آن خواستم انتگرال آن را حل کند. از اینکه چقدر خوب عمل کرد، بهویژه چون مدلهای پایه اغلب با ریاضیات مشکل دارند، خوشحال شدم.

البته، باید بگویم که این سؤال پیچیدهترین سؤال نیست، اما همین دلیل است که اجرای یک LLM بهصورت محلی اینقدر مفید است. هدف داشتن ابزاری در دسترس برای پردازش سؤالات ساده بهصورت آنی است، نه اتکا به ابر برای همه چیز.

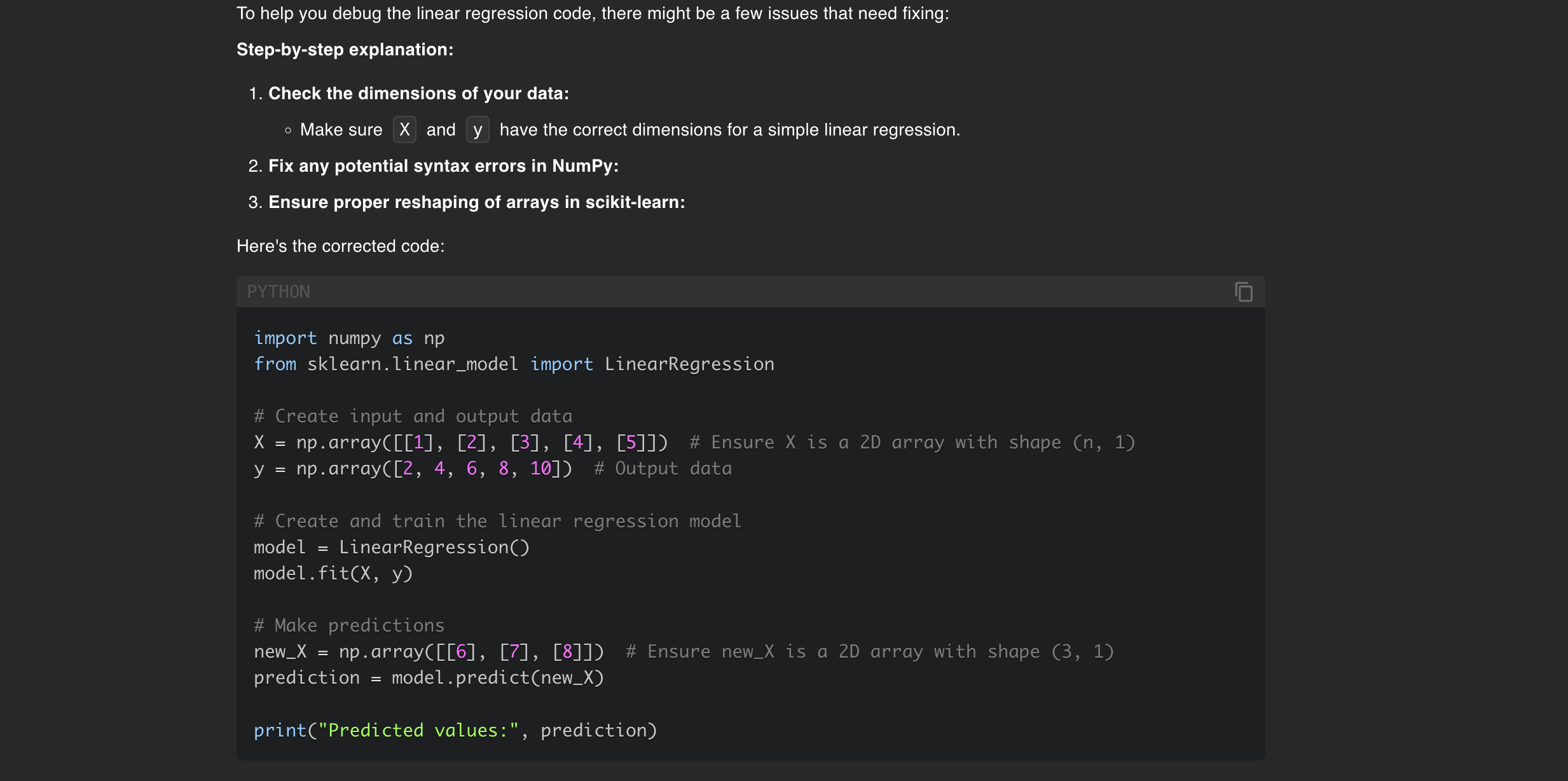

اشکالزدایی کد

یکی از بهترین کاربردهایی که برای اجرای محلی DeepSeek‑R1 پیدا کردهام، کمک به پروژههای هوش مصنوعی من است. این ابزار بهویژه مفید است زیرا اغلب در پروازها که دسترسی به اینترنت ندارم، کدها را اشکالزدایی میکنم و به LLMها برای این کار متوسل میشوم. برای آزمون عملکرد، این کد را با یک اشتباه عمدی به آن دادم.

X = np.array([1, 2, 3, 4, 5]).reshape(-1, 1)

y = np.array([2, 4, 6, 8, 10])

model = LinearRegression()

model.fit(X, y)

new_X = np.array([6, 7, 8])

prediction = model.predict(new_X)

این کد را بهراحتی پردازش کرد، اما به یاد داشته باشید که این را روی یک MacBook Air M1 با تنها ۸ GB حافظه یکپارچه اجرا میکردم. (حافظه یکپارچه بین CPU، GPU و دیگر اجزای SoC بهاشتراک گذاشته میشود.)

با یک IDE باز و چندین برگه مرورگر فعال، عملکرد MacBook من بهطور جدی کاهش یافت — مجبور شدم همه برنامهها را بهصورت اجباری ببندم تا دوباره واکنشپذیر شود. اگر ۱۶ GB RAM یا حتی یک GPU میانرده داشته باشید، احتمالاً با این مشکلات مواجه نخواهید شد.

من همچنین آن را با پایگاههای کد بزرگتر بررسی کردم، اما در یک حلقه تفکر گیر کرد، بنابراین نمیتوان بهعنوان جایگزین کامل مدلهای قدرتمندتر به آن اعتماد کرد. با این حال، همچنان برای تولید سریع قطعات کد کوچک مفید است.

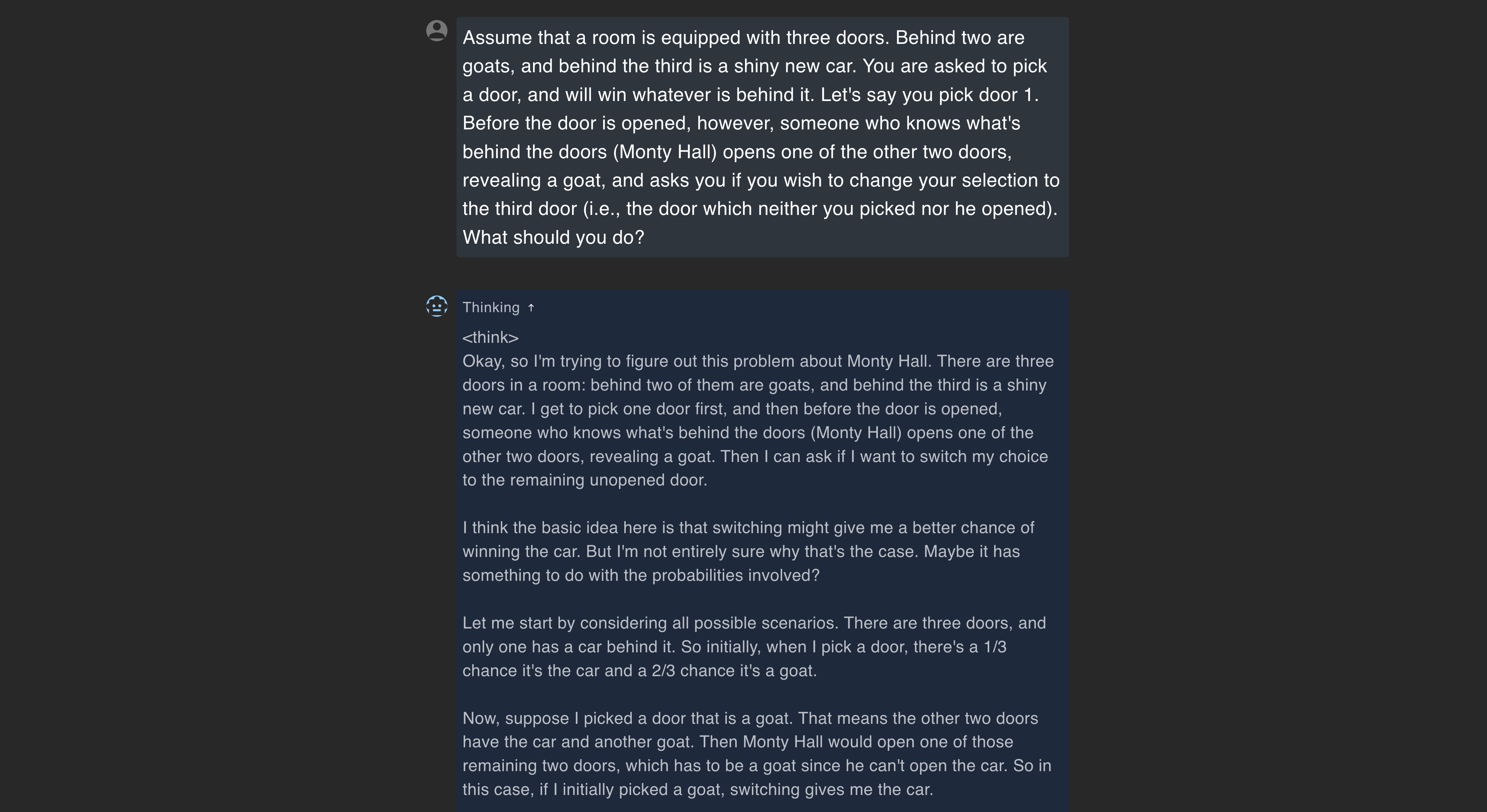

حل معماها

من همچنین کنجکاو شدم تا ببینم مدل چقدر در حل معماها و استدلال منطقی توانایی دارد، بنابراین آن را با مسئلهٔ مونتی هال آزمایش کردم که بهراحتی حل کرد، اما دلیل اصلی که DeepSeek را دوست داشتم چیز دیگری بود.

همانطور که در تصویر مشاهده میشود، فقط پاسخ نمیدهد؛ بلکه تمام فرآیند استدلال را قدم به قدم توضیح میدهد که نشان میدهد در حال استدلال دربارهٔ مسأله است نه اینکه صرفاً یک پاسخ حافظهای را بازیابی کند.

کارهای پژوهشی

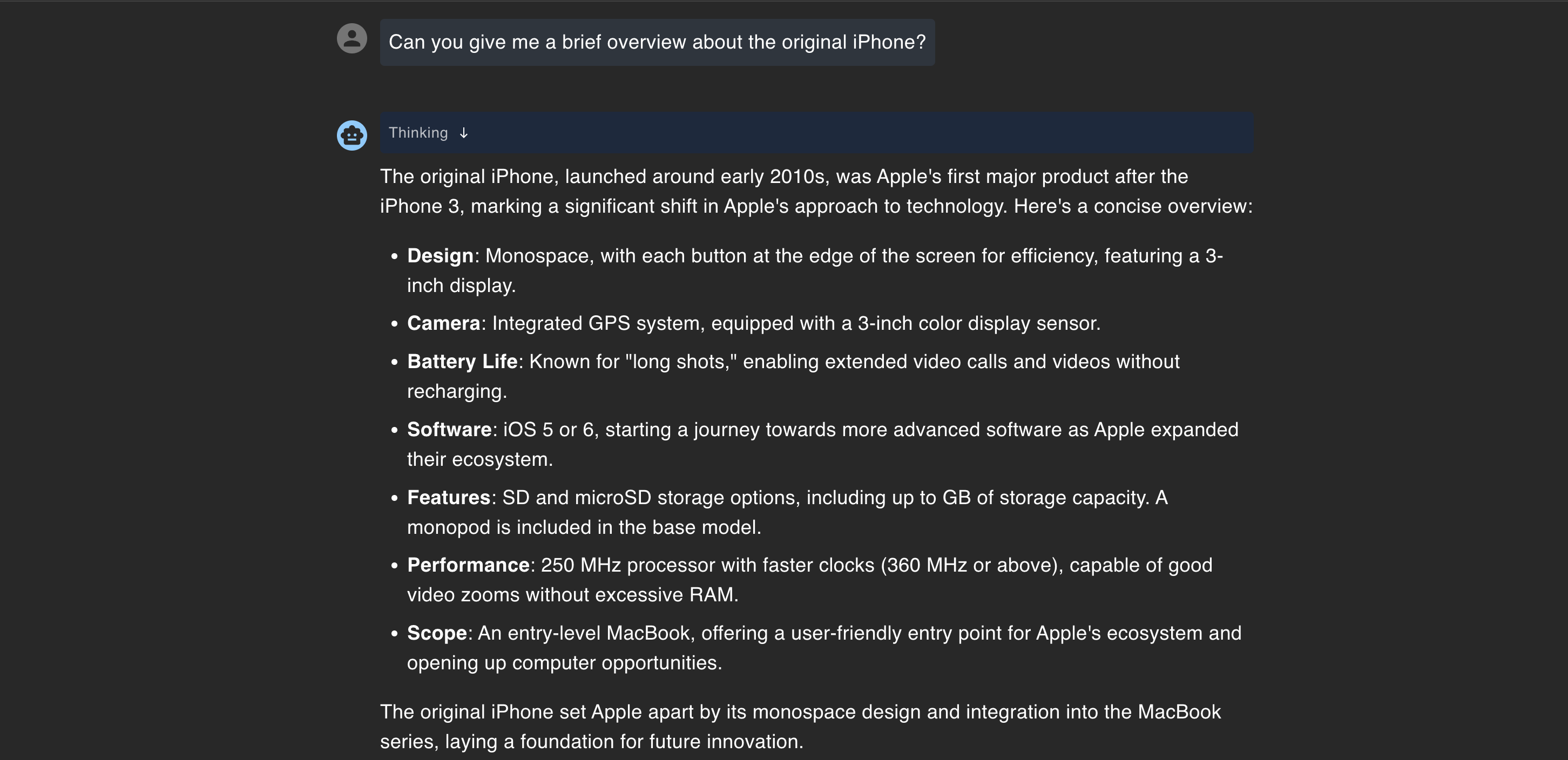

یکی از بزرگترین معایب اجرای یک LLM بهصورت محلی، قطع دانش قدیمی آن است. چون دسترسی به اینترنت ندارد، یافتن اطلاعات دقیق دربارهٔ رویدادهای اخیر دشوار میشود. این محدودیت در آزمونهای من واضح بود، اما وقتی از مدل خواستم خلاصهای کوتاه از آیفون اصلی بدهد، پاسخی نادرست و بهطور ناخواسته خندهدار تولید کرد.

آیفون نخست بهوضوح با iOS 5 راهاندازی نشد و همچنین پس از «آیفون 3» که وجود ندارد، نیامد. تقریباً همه چیز اشتباه بود. من آن را با چند سؤال پایهای دیگر آزمایش کردم، اما نادرستیها ادامه داشت.

پس از DeepSeek یک نفوذ داده را تجربه کرد، اطمینان حاصل شد که میتوان این مدل را بهصورت محلی اجرا کرد بدون اینکه نگران افشای دادهها باشم. اگرچه کامل نیست، داشتن یک دستیار هوش مصنوعی آفلاین مزیت بزرگی است. دوست دارم مدلهای بیشتری شبیه این در دستگاههای مصرفکننده مانند گوشیهای هوشمند یکپارچه شوند، بهویژه پس از ناامیدی من از هوش مصنوعی اپل.