در اوایل آوریل ۲۰۲۵، متا مدل Llama 4 را منتشر کرد، آخرین سری مدلهای هوش مصنوعی خود که برای ارتقاء شرکت به سطح بعدی طراحی شدهاند. هر یک از مدلهای جدید Llama 4 با بهبودهای قابل توجهی نسبت به نسخههای پیشین خود همراه است و اینها ویژگیهای برجسته جدیدی هستند که میتوانید امتحان کنید.

در اوایل آوریل 2025، متا لاما 4 را راهاندازی کرد، آخرین مجموعه مدلهای هوش مصنوعی خود که برای ارتقاء شرکت به سطح بعدی طراحی شدهاند. هر یک از مدلهای جدید لاما 4 دارای بهبودهای قابلتوجه نسبت به قبلیان خود هستند و اینها ویژگیهای برجسته جدیدی هستند که میتوانید امتحان کنید.

3 معماری ترکیبی متخصصان (MoE)

یکی از برجستهترین ویژگیهای مدلهای لاما 4، معماری جدید MoE است که برای اولین بار در سری لاما به کار رفته و رویکردی متفاوت نسبت به مدلهای قبلی اتخاذ میکند. تحت این معماری جدید، تنها بخش کوچکی از پارامترهای مدل برای هر توکن فعال میشود، بر خلاف مدلهای ترانسفورمر متراکم سنتی مانند لاما 3 و نسخههای پیشین که تمام پارامترها برای هر کار فعال هستند.

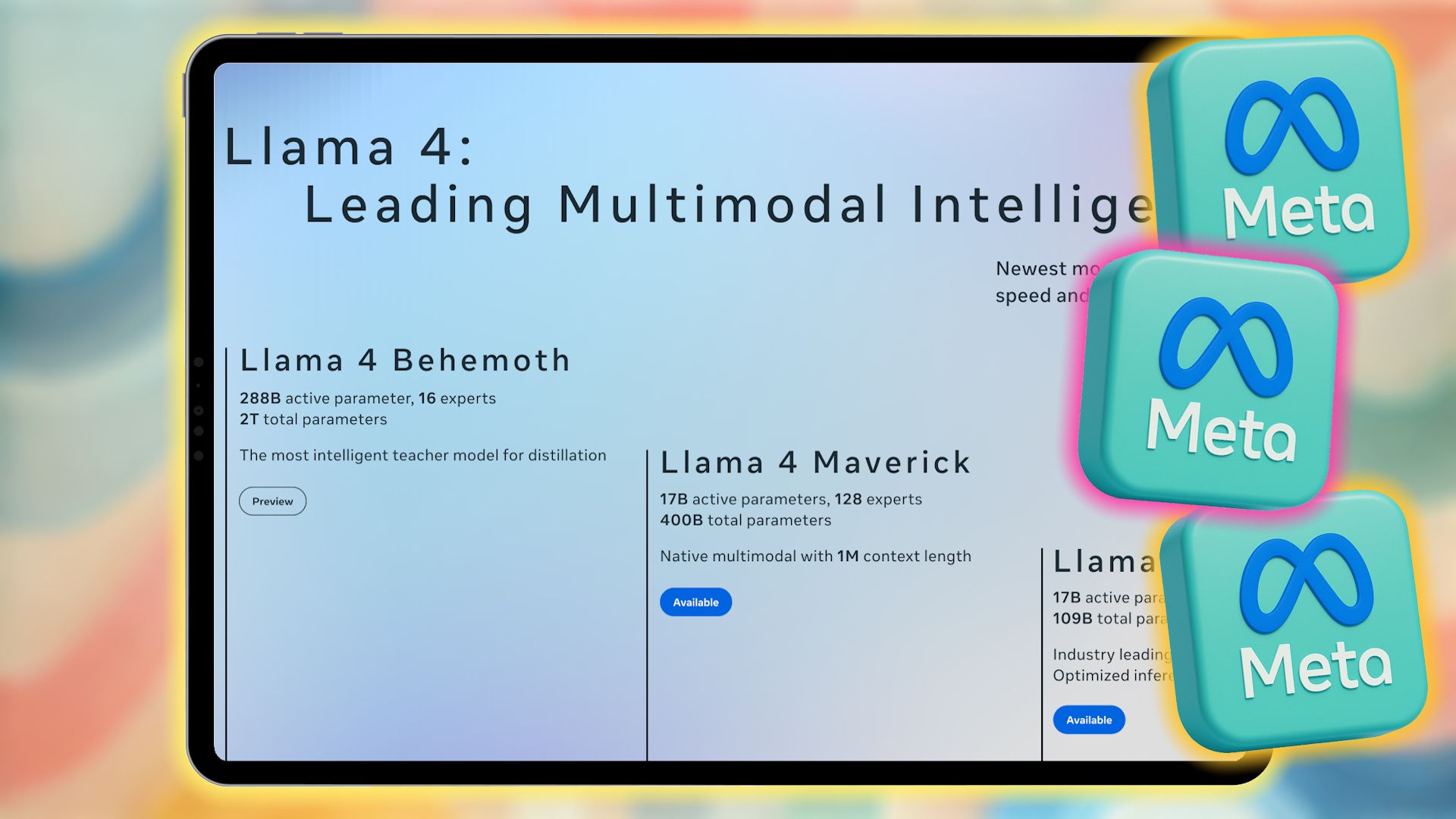

به عنوان مثال، لاما 4 Maverick تنها ۱۷ میلیارد پارامتر فعال از ۴۰۰ میلیارد کل را استفاده میکند، همراه با ۱۲۸ متخصص مسیریابی شده و یک متخصص مشترک. لاما 4 Scout، کوچکترین مدل در این سری، مجموعاً ۱۰۹ میلیارد پارامتر دارد که فقط ۱۷ میلیارد از آنها با ۱۶ متخصص فعال میشود.

بزرگترین عضو این سهگان، لاما 4 Behemoth، ۲۸۸ میلیارد پارامتر فعال (با ۱۶ متخصص) از تقریباً دو تریلیون پارامتر کل استفاده میکند. به لطف این معماری جدید، تنها دو متخصص برای هر کار اختصاص داده میشوند.

در نتیجهٔ این تغییر معماری، مدلهای سری لاما 4 از لحاظ محاسباتی در آموزش و استنتاج کارآمدتر هستند. فعال کردن تنها بخش کوچکی از پارامترها هزینههای سرویس و تأخیر را نیز کاهش میدهد. به لطف معماری MoE، متا ادعا میکند که لاما میتواند بر روی یک کارت گرافیک Nvidia H100 اجرا شود، دستاوردی چشمگیر با توجه به تعداد پارامترها. اگرچه ارقام دقیقی ارائه نشده، اما تصور میشود هر درخواست به ChatGPT از چندین GPU Nvidia استفاده میکند که باعث ایجاد هزینهٔ بالاتر در تقریباً تمام معیارهای قابلاندازهگیری میشود.

2 قابلیتهای پردازش چندرسانهای بومی

بهروزرسانی کلیدی دیگر مدلهای هوش مصنوعی لاما 4، قابلیتهای پردازش چندرسانهای بومی است که به معنای این است که این سه مدل میتوانند بهطور همزمان متن و تصاویر را درک کنند.

این بهدست آمده از ادغام انجام شده در مراحل اولیهٔ آموزش است که در آن توکنهای متنی و تصویری در یک معماری یکپارچه ترکیب میشوند. مدلها با استفاده از مقادیر وسیعی از دادههای متن، تصویر و ویدئوی بدون برچسب آموزش میبینند.

بهتر از این نمیشود. اگر به یاد داشته باشید، ارتقاء لاما 3.2 متا که در سپتامبر 2024 منتشر شد، چندین مدل جدید (در مجموع ده مدل) معرفی کرد که شامل پنج مدل دیداری چندرسانهای و پنج مدل متنی بودند. با این نسل، شرکت نیازی به انتشار مدلهای متنی و دیداری جداگانه نیست، بهدلیل قابلیتهای پردازش چندرسانهای بومی.

علاوه بر این، لاما 4 از یک رمزگذار تصویر بهبود یافته استفاده میکند که به مدلها امکان میدهد وظایف پیچیده استدلال بصری و ورودیهای چندتصویری را مدیریت کنند و برای برنامههایی که به درک پیشرفته متن و تصویر نیاز دارند، مناسب باشند. پردازش چندرسانهای همچنین به مدلهای لاما 4 اجازه میدهد در طیف گستردهای از برنامهها استفاده شوند.

1 پنجره زمینه پیشرو در صنعت

مدلهای هوش مصنوعی لاما 4 دارای پنجره زمینه بیسابقهای تا ۱۰ میلیون توکن هستند. اگرچه لاما 4 Behemoth هنوز در حال آموزش است، لاما 4 Scout یک معیار جدید صنعتی را با پشتیبانی تا ۱۰ میلیون توکن در طول زمینه مطرح میکند که به شما امکان وارد کردن متنی بیش از پنج میلیون کلمه را میدهد.

این طول زمینه گسترشیافته نسبت به ۸ هزار توکن لاما 3 که در ابتدا معرفی شد، بهطور چشمگیری افزایش یافته و حتی پس از ارتقاء لاما 3.2 به ۱۲۸ هزار توکن رسیده است. و نه تنها طول زمینهٔ ۱۰ میلیون توکنی لاما 4 Scout هیجانانگیز است؛ حتی لاما 4 Maverick با طول زمینهٔ یک میلیون توکن خود نیز دستاوردی چشمگیر است.

لاما 3.2 هماکنون در میان بهترین رباتهای گفتگوی هوش مصنوعی برای مکالمات گسترده قرار دارد. با این حال، پنجره زمینه گسترشیافته لاما 4، لاما را به عنوان پیشرو مطرح میکند و از پنجره زمینهٔ دو میلیون توکنی ژمینی، ۲۰۰ هزار توکن Claude 3.7 Sonnet و ۱۲۸ هزار توکن GPT‑4.5 چتجیپیتی پیشی میگیرد.

با پنجره زمینه بزرگ، سری لاما 4 میتواند کارهایی را که نیاز به ورودی با حجم عظیم اطلاعات دارند، مدیریت کند. این پنجره عظیم در کارهایی مانند تحلیل طولانی و چند سندی، تحلیل دقیق کدهای بزرگ، و استدلال بر روی مجموعههای دادهٔ گسترده مفید است.

این همچنین به لاما 4 امکان برگزاری مکالمات طولانی را میدهد، بر خلاف مدلهای قبلی لاما و دیگر شرکتهای هوش مصنوعی. اگر یکی از دلایل اینکه Gemini 2.5 Pro بهترین مدل استدلالی است، پنجره زمینهٔ بزرگ آن باشد، میتوانید تصور کنید یک پنجره زمینه ۵ یا ۱۰ برابر چقدر قدرتمند میتواند باشد.

مدلهای سری لاما 3 متا قبلاً یکی از بهترین مدلهای بزرگ زبانی (LLM) موجود در بازار بودند. اما با انتشار سری لاما 4، متا قدمی فراتر پیش میرود؛ نه تنها بر روی بهبود عملکرد استدلال (بهدلیل پنجره زمینه پیشرو در صنعت) تمرکز میکند، بلکه با بهرهگیری از معماری جدید MoE در هر دو مرحلهٔ آموزش و استنتاج، سعی دارد مدلها را تا حد امکان کارآمد نگه دارد.

بهطور کلی، پردازش بومی چندرسانهای لاما 4، معماری کارآمد MoE و پنجره زمینهٔ عظیم آن، این مدل را بهعنوان یک مدل هوش مصنوعی چندمنظوره، با عملکرد بالا و وزن باز معرفی میکند که میتواند با مدلهای پیشرو در زمینهٔ استدلال، برنامهنویسی و سایر وظایف رقابت یا پیشی بگیرد.